Dockerのコンテナでアプリケーションを分散化する技術は、Linuxの世界の分裂をやや縫合することに役立っている。そして今度は、互いに会話/対話する、あるいは一緒にアップデートされる、複数の小さなアプリケーションのための新しいパッケージフォーマットが、同様の効果を期待している。それはUbuntuにアプリケーションをインストールするために、今年初めにCanonicalが導入した、Snapsと呼ばれるパッケージングフォーマットで、今では複数のLinuxディストリビューションが、デスクトップやサーバー、クラウド、それに各種デバイスといった複数のプラットホームにわたって利用している。

Linuxの新しいパッケージングフォーマットは、RedHatのRPMやDebianのdebなどのフォーマットと競合するので、多くのディストリビューションがサポートしないかぎり、普及は難しい。Canonicalはしかし、Dell, Samsung, Linux Foundation, The Document Foundation, Krita, Mycroft*, Horizon Computingなどかなりの数のサポーターと、Arch, Debian, Gentoo, OpenWrt, Ubuntu, およびこれらのディストリビューションの派生系といったコントリビューターを集めることに成功した。そしてCanonicalによると、今ではSnapsはArchとDebianとFedoraの上、およびUbuntuベースのディストロであるKubuntu, Lubuntu, Ubuntu GNOME, Ubuntu Kylin, Ubuntu MATE, Ubuntu Unity, Xubuntuでネイティブに動き、またCentOS, Elementary, Gentoo, Mint, OpenSUSE, OpenWrt, およびRHELの上では目下検証が行われている。そのほかのLinuxディストリビューションの上でも、容易に利用できるそうだ。〔*: Mycroft, Microsoftではない!〕

Canonical自身が最初にSnapsのアイデアを実験したのは、Ubuntuの”Snappy”エディションの上だ。CanonicalのファウンダーMark Shuttleworthによると、Snapsは最初、CanonicalのディストリビューションであるUbuntuのために開発されたが、コミュニティの力でいち早くそのほかのディストリビューションにも広まっていった。

本誌のインタビューに対して彼は、“今日のニュースはUbuntu関連ではなくて、Linuxの分裂と多様化に関するニュースだ”、と語った。“多くのデベロッパーからのコントリビューションのおかげで、パッケージングアプリケーションSnapsは、すべてのメジャーなLinuxの上で、何も変えずにそのままで動く”。

Snapsのねらいは、ソフトウェアのベンダがLinuxベースのアプリケーションをもっと容易に配布できるようにすることだ。MozillaのFirefox担当VP Nick Nguyenが、声明文の中でこう述べている: “われわれは、ユーザーにすばらしい体験を提供し、Firefoxが多くのプラットホームで使えるよう、努力している。Snapsを導入したことによって、Firefoxの継続的最適化が可能になり、Linuxユーザーにも、もっともアップツーデートな機能を提供できる”。

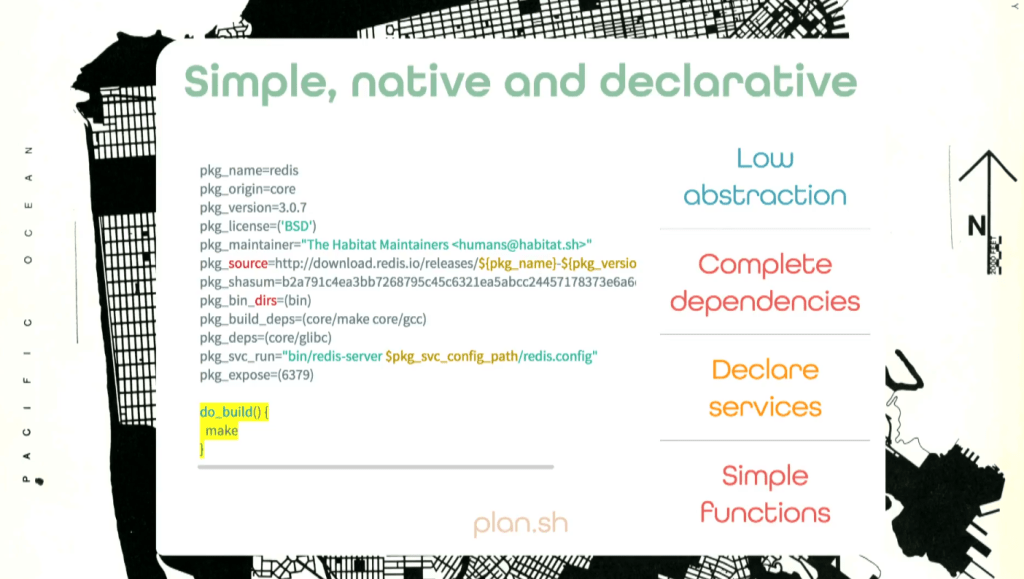

Snapsの初期のユースケースとして彼が挙げるのは、Cassandraのような、複雑なデータベースを動かす必要のある、“依存性の巨大な塊のような”アプリケーションだ。それらのアプリケーションにはたくさんの依存性があり、インストールが難しい。またTelegramメッセージングやAtomエディターのような消費者アプリケーションはJavaScriptで書かれているので、Linuxで使えるけどLinux上に“インストール”はできない、そういうアプリケーションもSnapsは、部品を集めて束ねることができる。それらは互いに会話はできても、互いに、また他のデータからも隔離されている、とNguyenは述べる。そのためにSnapsは、カーネルの隔離機能と、特製のセキュリティ機構を使っている。

これらに加えて、Snaps中のアプリケーションはアップデートもできるし、旧バージョンへの復帰もできる。この機能はすでに、IoTで利用されている。

“IoTの市場は多様化が激しく、複雑であり、デバイスメーカーが完全なソフトウェアスタックを構築するのは高くつく”、と、Samsung Strategy and Innovation Center(SSIC)のエコシステム担当VP兼IoTゼネラルマネージャーのCurtis Sasakiは、声明文で述べている。“だからSamsung ARTIKモジュールをベースに新しいプロダクトを作るデベロッパーは、Snapsのエコシステムを利用してプロダクトのライフサイクルを加速したいのだ。そのためにこそわれわれは、ARTIKの上でSnapsが使えることを喜んでいる”。

Shuttleworthが創業したCanonicalは、Ubuntuのサポートや関連サービスが収益源だ。彼によると、Snapsにはそういう財務的事業的な視角はない。

[原文へ]

(翻訳:iwatani(a.k.a. hiwa))