ウェブサービスで読むあらゆる文章を、速やかに自動的に翻訳できる能力は大したものだが、本当に使えるのは、概略で足りる外国語の記事やメニューや道路標識といった程度の文章だ。この素晴らしいツールは、もっと有効に使われるべきではないだろうか。それは可能だ。Liltという企業が、もう密かに始めている。しかも嬉しいことに、人間的な要素を置き去りにしようとは考えていない。

人間の翻訳者の専門知識と、自動翻訳のスピードと汎用性とを組み合わせれば、双方のもっとも優れた能力を引き出すことができ、大きなビジネスになる可能性がある。

機械翻訳の問題点は、それを本気で使おうとしたときにわかるが、下手なことだ。トマトとポテトと間違えることはないが、一連の言葉の文字通りの意味を正確に訳す以上のことになると頼りない。ほとんどの場合は文字通りの意味で事足りる(メニューなどはそうだ)が、長い文章となると、十分とは言えなくなる。

単に利便性の問題ではない。業務においても個人的なものであっても、言葉は重大な障壁になり得る。

「英語でしか読めないものが大量にあります」と、Liltの共同創設者でCEOのSpence Greenは話す。中東で大学院に通いながらアラビア語を勉強していたとき、彼はその問題に遭遇し、英語を話さない人たちの不自由さを知った。

そうした情報は、ほとんどが機械翻訳には適さない内容だと彼は説明する。Google翻訳で訳された説明書を頼りに重機を操作しなければならない事態や、自分の読めない言語でしか移民法が書かれていない国で仕事をする状況を想像して欲しい。

「本、法的な情報、投票に関する資料……、質が求められるものの場合は人間の関与が必要です」と彼は言う。

中東で翻訳の仕事を行い、その後の2011年にGoogleでインターンとして働いていたとき、Greenは機械翻訳に関心を抱いた。ほとんどのシステムで内容が劣化してしまうのだが、質を保ったまま情報にアクセスできるように改善するにはどうしたらよいか。

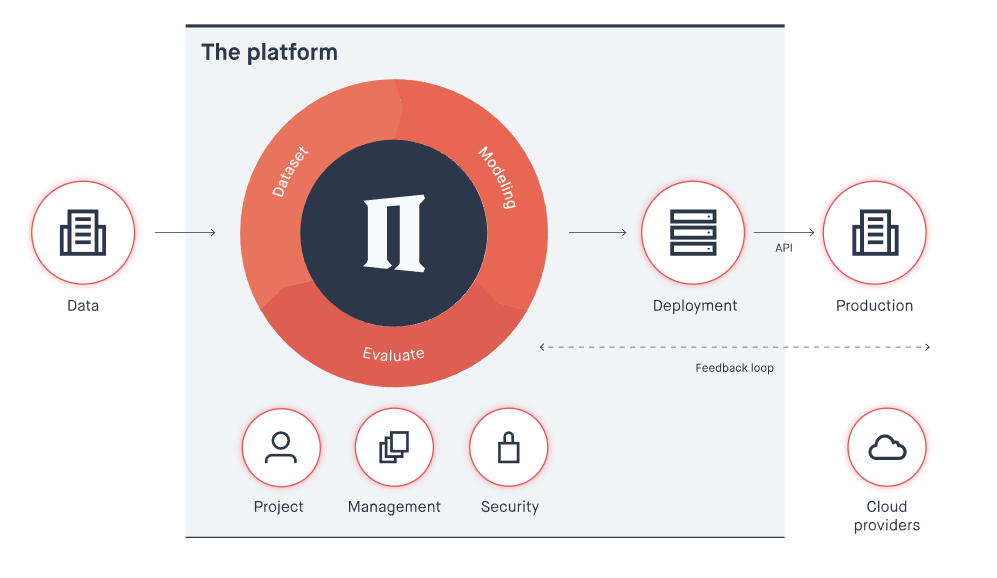

そうして彼が、共同創設者のJohn DeNeroとともに追求し実現させたのが、翻訳のためのツールとしてだけではなく、翻訳者のためのツールにもなる機械翻訳システムだった。翻訳システムの中で作業することで、翻訳者はより速く、より良い仕事ができるようになり、認知的負荷が軽減される。

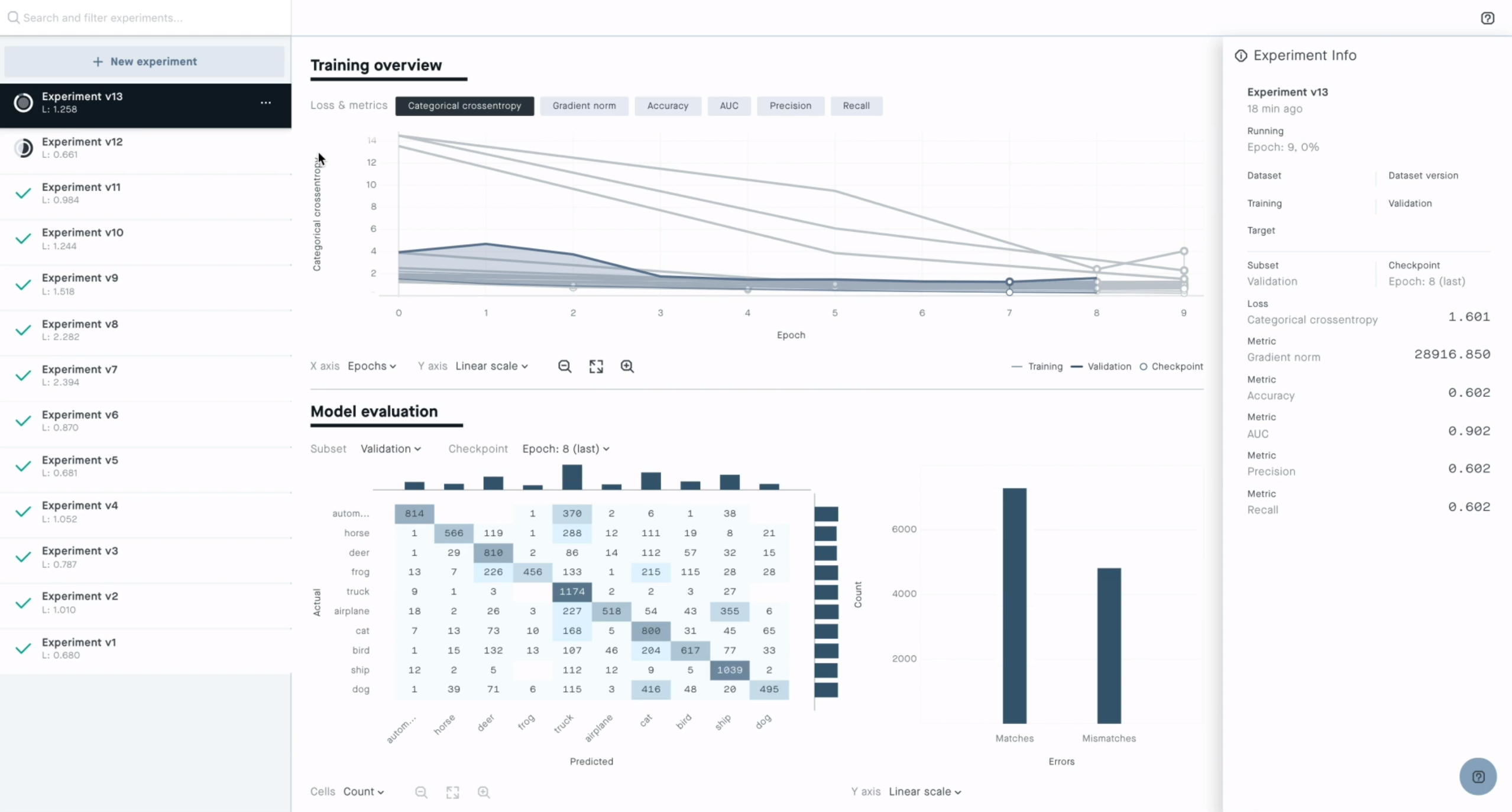

Liltのツールの基本的な考え方は、次の文章や段落の作業の参考になる翻訳をシステムが提供するというものだ。文章構成、時制、慣用句などを翻訳者が参照できることで、少なくとも可能性として、より短時間により良い作業ができる。Liltでは、1時間あたりの翻訳語数は5倍にもなると説明している。結果は、人間の訳者だけが行った場合に比べて同等か、それ以上のものが期待できるとのことだ。

「私たちは複数の論文を発表しています。……この技術が有効であることを、私たちはわかっていました。私たちは翻訳者たちと研究を重ね、大規模な実験も行いました」とGreenは言う。しかし、知りたいのはどのように進めたかだ。

大企業に話を持ちかけて興味を持ってもらったのか? 「それを行うことで、大企業は消費者向けアプリケーションにばかり目を向けていることを私たちは感じました。品質の基準はどこにもありません。それが翻訳業界の実態です」とGreenは語る。

学術研究に留まり、補助金を使ってオープンソース化する? 「お金は、ほぼ枯渇状態です」とGreen。911の事件の後、情報収集とコミュニケーション能力の改善という名目で、予算は潤沢に与えられた。しかし、あれから10年が経過すると切迫感が消え、同時に補助金も消えた。

会社を立ち上げた? 「この技術が必要であることは、わかっていました」と彼は話す。「問題は、誰がそれを市場に持ち込むかでした」ということで、自分たちがそれを行おうと決めた。

面白いことに、翻訳の世界の大きな変化は、彼らが本格的に取り組み始めたときに起こった。統計ニューラルネットワーク・システムが、文章のようなものを効率的に効果的に解釈する自然に近い親和性のあるアテンション・ベースのシステムに取って代わられたときだ。文章の中の単語は、画像の中のピクセルと違い、前後の言葉に構造的に依存している。彼らは中核的な翻訳システムを再構成する必要があったが、それが結果的には発展につながった。

両義的な文の機械翻訳で正しい訳語をガイドするGoogleのTransformerシステム

「これらのシステムは、ずっと流暢です。とにかく優れた言語モデルなのです。次に、学習が速い。わずかなアップデートで特定の分野に適応できます」とGreenは言う。つまり、ひとつの分野に限れば、技術書や不動産の法律など、難しい専門用語や特別な法則に素早く対応できるということだ。

もちろん、だからと言ってすぐさま翻訳ビジネスの真ん中に飛び込で、出版からリアルタイムのもの、技術系文書から無数のバーティカル市場にまで広がる世界に、「ほら、AIを使おう!」と言うことはできない。

「この業界には、何であれ現実に自動化することに対して猛烈な構造的抵抗力があります」とGreenは話す。大手出版社には、今使えている方式を変えようという気はなかった。

「有効なものが見つかるまで、私たちはいくつものビジネスモデルを試しました。『うん、この人間を組み入れた方式は問題を根本的に解決してくれる。それを基盤に会社を興そう』なんていう企業はひとつもありませんでした。そこで私たちはバーティカルに統合したのです。大企業や行政と協力して、彼らのための翻訳のワークフロー全体を私たちが持つことにしました」

品質を落とさずに高速化する方式は、基本的に効率性を倍加させる。正確に訳さなければならない文書が大量にあるが、ほとんどを自腹でやらなければならない組織にとって、それはマタタビのようなものだ。

こう考えて欲しい。それぞれ異なる言語を話す20カ国で製品を販売する企業の場合、パッケージ、広告、説明書などの翻訳は、実質的にはいつまでも完了しない作業だ。それが速く安く、高品質でできるなら、そしてそれを一手に引き受けてくれる企業があったなら、渡りに船だ。

「私たちは、Zendesk、Snap、Sprinklrなどと仕事をしています。すべての翻訳作業を引き受けています。これは海外市場への進出を手助けするものです」とGreen。翻訳用の予算や人員に限りがあり、一定期間内で可能な新規市場の開拓が5〜6件だった企業も、Liltを使えば、効率化の度合いにより、同じ予算と人員で開拓件数は2倍から3倍にできる。

現在彼らは、自然な流れとして顧客の獲得に努めている。「去年の第四半期には、初めての営業チームを結成しました」とGreenは教えてくれた。しかし、行政との最初の仕事はとくに励みになった。なぜなら「独特な用語が必要」であり、文書の量も膨大だったからだ。現在、Liltは29の言語に対応しているが、今年末には43言語に対応するという。校正機能は、翻訳者ばかりでなく編集者の作業効率も高めてくれる。

彼らはまた、学術経験者とのつながりを増やすことにも努めていて、Liltの周りに翻訳コミュニティーを構築している。学術経験者は翻訳者に欠かせない情報源であり、言語の専門家であり、大きな市場でもある。科学文献のほどんどは、高度に技術的な内容を他の言語に翻訳することが大変に難しいため、英語でのみ出版されている。

「ハイテク企業はあらゆる才能を吸い取って、アシスタントやらAlexaとやらにつぎ込んでいます」と話すGreenは、優れた研究者が退屈な仕事をさせられていることに腹を立てているように見える。AIやロボティクスのような先端技術の分野では、何度も繰り返されていることだ。

最後にGreenはこう話していた。「この輪を閉じて、書籍の翻訳に挑戦することが私の最大の夢です。儲かる仕事とは言えませんが、第三の目標なのです。もし可能なら、それは何か意味のあることを成し遂げたと気になれる道になります」

まずはアプリの説明書や政府の無秩序な契約書といった仕事から始まるのだろうが、Liltの人間を輪に組み入れた作業方法を受け入れやすい、そうした部類の文書や市場は増える一方だろう。それに、AIと人間が協力し合う未来は、人間が置き換えられる未来よりも心強い。少なくとも翻訳の世界では、人間の手が排除できるようになるのは、ずっと遠い話だ。

[原文へ]

(翻訳者:金井哲夫)

参加企業が収集したアンケートや人事データ(勤怠、性格、顔画像、ストレス、退職状況など)を、楽天技術研究所のディープラーニング技術を用いて分析。参加企業には、データの分析結果や完成したAIの先行提供などを予定しているという。

参加企業が収集したアンケートや人事データ(勤怠、性格、顔画像、ストレス、退職状況など)を、楽天技術研究所のディープラーニング技術を用いて分析。参加企業には、データの分析結果や完成したAIの先行提供などを予定しているという。