【編集部注】著者のRudina Seseri氏は、Glasswing Venturesの創業者でマネージング・パートナーであり、かつハーバード・ビジネス・スクールのアントレプレナー・イン・レジデンスと、ハーバード大学イノベーション・ラボのエグゼクティブ・イン・レジデンスも務める。

情報技術はディストラプション(破壊)の波を超えて進化する。最初はコンピューター、そしてウェブ、遂にはソーシャルネットワークとスマートフォン、全てが人びとの生き方や、ビジネスの回し方に革命を起こす力を持っていた。それらは適応に失敗した企業を破壊し、一方では成長するマーケットの新しい勝者を生み出して来た。

そうした波の到来のタイミングと形を正確に予測することは困難だが、それらがたどるパターンは認識しやすい。例えば、ウェブ/デジタルのディストラプションを考えてみよう:まず先行するテクノロジー(例えばTCP/IPや設置済のコンピューター群)の利点を活かした、テクノロジーのブレイクスルーがあり(例えばTim Berners-LeeのWWW)、そして一見緩やかに見えながら、実は爆発的に、既存の市場を破壊したり(例えばAmazon)創造したり(例えばGoogle)する、新しいアプリケーションとプラットフォームの勃興が導かれた。

そして今、新しい波のうねりが見え始めている。ウェブが既存の技術を利用したことと同様に、この新しい波は、コンピューティングハードウェアのコストの低下、クラウドの出現、企業システムのコンシューマライゼーション(専用機器ではなく消費者向けデバイスを利用すること)、そしてもちろん、モバイル革命などの動向に基いている。

更にスマートデバイスと「モノ」の急増と多様化は、定常的なコミュニケーションと共有を可能にし、一方ソーシャルネットワーキングネイティブたち(世界のSnapchatユーザーは団結する!)は常時共有と自己表現を「必需品」としている。この結果が、私たちが普遍接続性(pervasive connectivity)として作り出したものの出現だ。

普遍接続性はこれまで以上に豊かでパーソナライズされたデータの急増につながる、そしてそのことはデータを処理し、価値があり操作可能な洞察を引き出す方法への、完全に新しい機会を生み出すのだ。人工知能が、まさにそれを可能にする。

AIのもたらす機会 – なぜ今なのか、どうそれを活用するのか

AIは、より広い意味では、知性を発揮する機械の能力として定義され、ここ数年で劇的に改善された、学習、推論、プランニング、そして知覚といった、いくつかのコンポーネントで構成される。

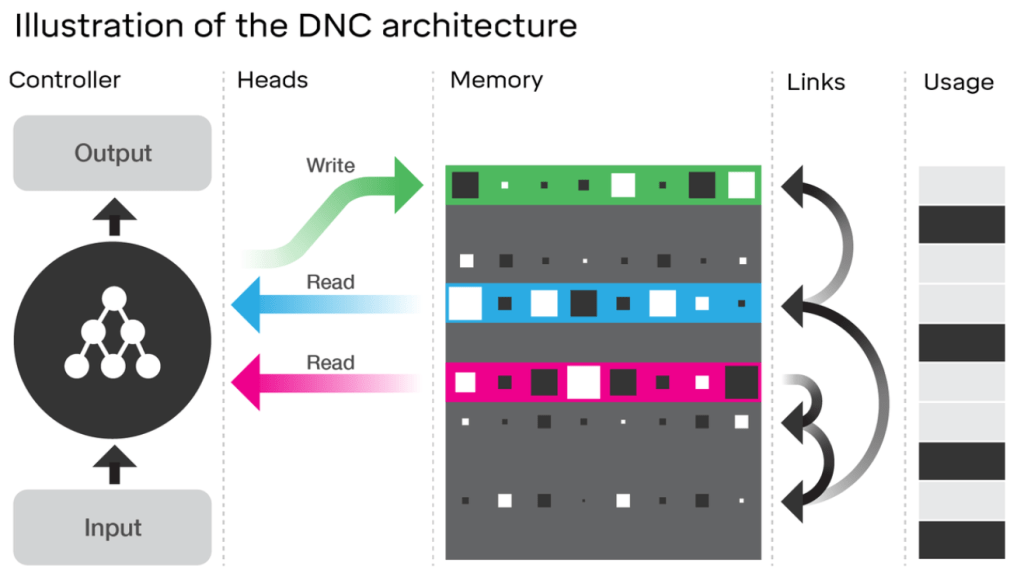

機械学習(ML)は顕著なブレークスルーを達成し、それによりAIコンポーネント全体にわたるパフォーマンスの向上が促進された。こうしたことに最も貢献しているMLの2つの流れは、理解に関わる深層学習(ディープラーニング)と、特に意思決定に関わる強化学習(リインフォースラーニング)だ。

興味深いことだが、これらの進歩はアルゴリズムではなく、むしろ(高品質な注釈付の)データ(セット)の指数関数的成長によって促進されたことはほぼ間違いないだろう 。その結果は驚くべきものだ:ますます複雑になるタスクに対してしばしば人間のパフォーマンスを上回るよい結果が継続的に達成されている(例えばゲーム、音声認識、そして画像認識の分野で)。

とはいえ、それはまだ黎明期であり、いくつかの課題が残されている:ほとんどのブレークスルーは「狭い」アプリケーションの領域で起きているものであり、(作成には高いコストのかかる)大量のラベル付データセットが必要な訓練手法を使っている。ほどんどのアルゴリズムは(いまでも単に)人間以下の能力を発揮できているのに過ぎず、その訓練にはかなりのコンピューティングリソースを必要とし、大部分のアプローチが理論的フレームワークを欠いた発見的手法に基いている。

AIは、既に自宅と職場の両方で、私たちの日常生活の多くの側面を変えている。しかし、これはほんの始まりに過ぎない。

これらの課題の多くは、おそらく中長期的には克服されるが、今日作成されている大部分のAI応用プロダクトは、こうしたことを考慮して置かなければならない。これが、AIを活用することを計画している企業が以下の事に気を配ることが重要である理由だ:柔軟なアプローチをとること(すなわち、最初は、良いパフォーマンスを出すためのMLアルゴリズム訓練データを集めることができるか、あるいは非AIアプローチをとるか)、(AI機能を開発しその性能を促進するための)「ラベル付けられたデータ」をユーザーから集める連続的な情報の流れを作り出すこと、そして十分に支援されていない、あるいは「人間が介在している」ユースケースに注力することだ。

現在多くの注目は、大規模テクノロジー企業(Google/DeepMind、Facebook、 Pinterestなど)に向けられているが、わたしはこの(もしくはこれに類似した)アプローチを使って、企業と消費者市場にAIディストラプションの波を起こすのは、スタートアップたちだろうと考えている。そして、既にいくつかのスタートアップはそれを始めているのだ。

企業内のAIディストラプション

企業内でAIは、企業が消費者とインタラクトするための新しい方法や、従業員同士が相互にコミュニケーションするための新しい方法、そしてそのITシステムと共に、より大きな収益と生産性の向上の両者を促進している。

マーケティングは、新技術の典型的なアーリーアダプターであり、それは既にAIを採用していて、セクター全体にわたって高い認識とコンバージョン指標が育っている。ソーシャルメディアでは、SocialFlow*などの企業が、キャンペーンの効果を向上させるための機械学習の使用を開拓してきている。ディープラーニングによって支えられる新しい画像認識技術は、Netraのようなスタートアップが、視覚に対する知性と検索性の改善をすることを可能とし、ユーザーエクスペリエンス全体を向上させている。電子商取引では、Infinite Analyticsが、より良いパーソナライゼーションを可能にするプロダクト群を作成することができている。

セールス分野では、営業チーム/見込み客とCRMの間のUIを再考した新しいプロダクトが、効率を大いに改善し、成約率を向上させている。Troops.aiは、セールスチームが現在自身の使っているプラットフォームを通して、CRMデータに簡単にアクセスすることを可能にする。Rollioは自然言語を介したCRM情報のアクセスおよび更新を可能にする。Conversicaは、より良いスクリーニングを行い、見込み客をフォローアップできる、セールスアシスタントを作成した。

普遍接続性の世界では、AIがデータのパワーを活用するための鍵である。

人事分野では、スタートアップは様々な活動にわたった効果と効率性の改善を行おうとしている。Tallaは、企業内のナレッジマネジメントの改革を目指している。一見単純な会話エージェントから始めて、最終的には本格的で先回りを行うナレッジエージェントへと向かうのだ。Wade & Wendyは採用時に使用するための両面会話エージェントを作った、目的は向かい合う両者の満足度のレベルを上げながら、全体の採用時間を短縮することである。

生産性という話では、x.aiのような企業たちが、スケジューリングに際しての苦痛を大幅に取り除き、シームレスなユーザーエクスペリエンスを生み出そうと努力している。

最後に、部門をまたがるアプリケーションを擁する広範なプラットフォームを作っている企業もある:Indicoは、アプリケーション間をまたがったアルゴリズムの訓練をかなり高速に行うために、学習転送を使っている;Receptivitiは、人びとのテキストやボイスメッセージを解析して、彼らの心理的かつ個人的な意思決定スタイルと感情をリアルタイムに明らかにする。

消費者市場におけるAIディストラプション

消費者市場で、おそらく最も私を興奮させるものは、AIが新しいプラットフォームを創造し、日々の生活の中の重要な空間で私たちが技術と対話する方法を再定義していくやり方である。

そのような重要な空間の1つが家だ。Jibo*は家庭の変革を目指す、フレンドリーでインテリジェントなソーシャルロボットだ。よりよいユーザーエクスペリエンスを生み出すために、それは人間臭いリアクションを採用している。一方、幅広いタスクにとても役に立つ働きをする、誰が話しているかによって調整を自動的に行うインテリジェントビデオコールから、料理をする際の材料の提案、そして子供向けの読み聞かせの手伝いまで、といった具合だ。

また別の重要な空間は車だ。nuTonomyはシンガポールにおける自動運転の導入で、テクノロジーを迅速に市場に持ち込み、現行勢力を飛び越えることができたスタートアップの良い例だ。

そしてどうなる?

ほとんどの人が、AIの仮説上の発展の、長期的な可能性と脅威に焦点を当てているが、いまのところ、新しいディスラプションの波を促しているのは、経験則に基づく、限界のある適用形態である。これまでの波のように、この変化は微妙で最小のもののように見えるが、ほどなくそれはひろく普及し、無視することができないものになる。

普遍接続性の世界では、AIがデータのパワーを活用するための鍵である。企業が生き残るためにはAIの利点を活かす必要がある ‐ Google、Facebook、Amazon、そして無数のスタートアップはそれを知っている。そして、あなたも知るべきなのだ。

AIは、既に自宅と職場の両方で、私たちの日常生活の多くの側面を変えている。しかし、これはほんの始まりに過ぎない。AIは、ゆっくりと、着実に、そして広範囲に、私たちとテクノロジーの関係を再定義している。そして人間の能力と、基本的には私たちの生き方を、向上させているのだ。

*Rudina Seseriの投資ポートフォリオには、SocialFlowとJiboが含まれている。

[ 原文へ ]

(翻訳:Sako)