【編集部注】執筆者のTim Merelは、Eyetouch RealityとDigi-Capitalのファウンダー兼CEO。

もしもこれまでにVRやARという言葉を耳にしたことがないとすれば、あなたが住む島にはWi-Fiが飛んでいないのだろう。一方で、VRやARのことを知っていても実物は見たことがない、という人はたくさんいる。つまりVRやARが一般に普及するためにはデモが欠かせないのだ。過去のデジタルプラットフォームは、いかに大衆の心を認知から行動へと動かしていったのだろうか。

AKQAのファウンダー兼会長であるTom Bedecarreは「新しいテクノロジーは似たような過程を経て一般に普及していきます。最初のお客さんになるイノベーターやアーリーアダプターをひきつけるのは比較的に簡単ですが、垣根を超えてアーリーマジョリティやそれ以外の消費者の心を掴むのは大変難しいことです」と単刀直入に話す。

360度動画でさえ、高品質のVR・ARアプリを使って初めて本当の驚きや喜びを体験することができることを考えると、VRやARが一般に普及するまでには大きな壁を超えなければいけないとわかる。AR・VRの全てを体験するためには、実際にスコープを装着しないといけないのだ。言い換えれば、「これこそが本当の立体映像だ、この野郎」といったところか。

それではVR・AR企業は、どのようにしてアーリーアダプター以降の消費者にプロダクトを体験させているのだろうか。

無料=なかなかの価格設定

New York Timesはこれまでに、100万個以上のGoogle Cardboardsを読者にプレゼントしてきた。マクドナルドは”Happy Goggles“と名付けられたセットで、VRヘッドセットに変形するボックスを配布し、コカコーラも複数本入りのパッケージで同じようなキャンペーンを行った。

紙箱からアップグレードしたものだと、SamsungはVR対応の携帯電話にGear VRヘッドセットを無料でバンドルした結果、「何百万人ものユーザーにGear VRを配布し、100万人以上の月間アクティブユーザー」を獲得したと同社の広報担当者は話す。さらにSamsungは店頭デモも積極的に行っており、「アメリカ国内で1万5000軒もの店舗」にデモ機を導入した。VerizonもPixelの先行予約者に対して、GoogleのDaydream View VRヘッドセットをプレゼントし、中国のOnePlusも携帯電話とセットで3万台ものVRヘッドセットをこれまでに配布してきた。

ハイエンドのパソコンやコンソールにVRヘッドセットが無料でバンドルされることはないだろうが、Microsoftが新たに発表したWindows 10用VRヘッドセットの登場で、ハイエンドVRシステムの価格は今後下がっていくことが予想される。

一にも二にも実体験

Sony PlayStation Magic Labのトップを務めるRichard Marksは、「ユーザーに実際にVRを試してもらうというのは極めて重要です。というのも、VRで得られる体験は、ほとんどの人がこれまでに他のメディアで経験したものとは比べ物にならないですからね。これまでに私たちは40万人以上を対象にデモを行い、体験した人には友人にも宣伝するようお願いしてきました。また、PSVRを購入した人全員に無料のデモディスクを配布しているほか、VRヘッドセットを持っている人もそうでない人も一緒に遊べるよう、非対称マルチプレイゲームも併せて配布しています」

HTCで部長を務めるPearly Chenも、Viveをユーザーに試してもらうことの重要性を強調している。「百聞は一見にしかずという言葉の通り、VRの素晴らしさを伝えるにあたって、実際に消費者にVRヘッドセットを装着させて、彼ら自身の目でVRを体験させるよりも良い方法はありません。HTCでは、2015年の半ばからVive World Tourと呼ばれるプロジェクトに取り組んでおり、世界の主要都市や大学、イベント、展示会などを巡りながら、製品を宣伝すると共に、VRの普及に向けた草の根活動を行い、消費者からのフィードバックを集めています」

「また、引き続き大手小売店とのパートナーシップを深めていき、アメリカ国内で言えばMicrosoftストアやGameStop、MicroCenter、中国だとSuningやGuomei、インターネットカフェなどにデモステーションを設置していく予定です。さらに台北には、多くの人にVRを体験してもらえるようなエンターテイメントセンターとしてVive Landをオープンしました。」

一般大衆向けのコンテンツやアプリケーションをつくる際には、どうすれば多くの消費者にその存在を知らせ、トライアルの効果を行き渡らせることができるのだろうか?

HTCは自社のプロダクトを消費者に届けるだけでなく、もっと広い視野で業界を眺めている。「VRエコシステム全体の発展に寄与するため、1億ドル規模のファンドであるVive Xを利用し、VRに関する全ての人やモノのためになるようなビジョンを持った企業をサポートしています」

AR・VRを利用したサービスを提供する教育系スタートアップのzSpaceは、店頭でのトライアルに関してもっと積極的なアプローチをとっており、ユーザーが店舗を訪れるのではなく、店舗がユーザーのもとを訪ねる仕組みを構築した。彼らはデモ環境を整えたバスを複数台用意し、アメリカ中の学校を訪れているのだ。CEOのPaul Kellenbergerは「私たちはこの方法に効き目があるからやっているんです。このプロジェクトによって、教師や生徒は遠い距離を移動したり、試したこともないシステムを買ったりする必要がなくなります。さらに、私たちのプロダクトの協力的な側面もあり、学校を取り囲む人を含めた教育コミュニティ全体が、その効率性を感じてくれています。また、このプロモーション活動のリターンはとても大きく、規模の大きな学校からの注文の中には、バスツアーがきっかけとなったものもありました。つまり、潜在的なユーザーがいる場所を実際に訪問し、トライアルのプロセスを簡素化することで、利益に直接的な影響があることがわかったんです。これは私たちのビジネスが成長する上で、とても大きな要因となるでしょう」と話す。

ポケモンゲットだぜ!

これまでに市場に出ているARスマートグラス(Microsoft HoloLens、ODG、Metaなど)のほとんどは法人向けのため、現状の製品を消費者向けのトライアルで試すのは時期尚早だ。しかしPokémon GOのおかげで、(業界の中にいる人はPokémon GOがARだと認めていないものの)既に大衆はARの存在を知っているばかりか、実際に体験までしている。Apple CEOのTim CookやGoogle CEOのSundar Pichai、さらにFacebook CEOのMark ZuckerbergやMicrosoft CEOのSatya Nadellaも口を揃えて早期AR市場の勝者はPokémon GOだと認めている。つまり、これまでにPokémon GOが一時は5000万人という恐ろしいほどの月間アクティブユーザー数を記録したかたわら、全世界の(何億人とは言わずとも)何千万人という消費者が、自分はARを試して気に入ったと感じているのだ。

大きな問題は、今後数年のうちにスマートグラスが消費者市場に参入する際に、Pokémon GOによって広まったARの認知を、”本当の”ARプロダクトがどう利用できるかということだ。願わくは(失敗に終わった)Google Glassや(好評だった)SnapのSpectacles両方から得た教訓が、次世代のプロダクトに反映されてほしいものだ。

Snapの戦略勝ち

SnapのSpectaclesへの臨み方は、素晴らしいマーケティング戦略に他ならない。Spectaclesは、Google Glassによって数年間に渡りダメージを与えられた消費者のARに対するイメージを、(Spectaclesは本当の意味でのARではないとしても)ほぼ一手に回復することに成功した。

Spectaclesは一般消費者向けのカッコいいガジェットであり、ディストピア的未来を象徴するものではない。また、数に限りはあるがエリート主義的ではなく、Spectaclesを入手するために何時間も車を運転して自動販売機のもとを訪れる覚悟がある人であれば、(選ばれた”Glassholes“だけでなく)誰でも手に入れることができる。機能にこだわらなければ、Spectaclesの130ドルという価格も競合製品に比べるとずっと低い。

お金をかけないマーケティングの成功やSpectaclesビデオがバイラルに広がった結果、Snapchatの1億5000万人を越えるデイリーアクティブユーザーは、Spectaclesを使って撮影されたビデオを通して(実物をまだ手にできていなくても)自分がSpectaclesを使っているような体験をすることができる。さらにアーリーアダプター(一部からは課金ベータテスターとも呼ばれている)から収集したデータを利用し、SnapはSpectaclesをハード・ソフト両面から改善し、フルローンチに向けて準備を勧めている。CEOのEvan Spiegelとは大した男だ。

Call me maybe

消費者向けのARプロダクトが成功する上で重要な要素が次の5つだ。ヒーローデバイス(Apple製かどうかに関わらず、Apple製品のような品質のデバイスを指す)、モバイルデータ通信、丸一日もつ電池、(初期のスマートフォン同様)アプリのエコシステム、そして通信会社によるデバイス代負担だ。通信会社が徴収するデータ使用料と、そこから捻出されるデバイス代が料金面での鍵となってくるが、実際に通信会社は消費者がVRを体験する上でどんなことができるのだろうか?

Verizon Venturesでディレクターを務めるEd Ruthは、ARプロダクトが消費者市場に参入する準備ができた段階で、通信会社は大きな役割を担うことになると考えている。「店頭でのトライアルを超えて、通信会社は全国の店舗網を利用し、最終的にはスマートフォンの普及と同じやり方でARプロダクトを消費者のもとに届けることができる可能性があります。この新たな市場から得られるデータ通信料が、モバイル通信の成長を再活性化していくことになるでしょう。特に360度動画だけで考えても、通常のビデオの4~5倍の通信量が消費されることになります」と彼は話す。

改めて強調したいコンテンツの重要性

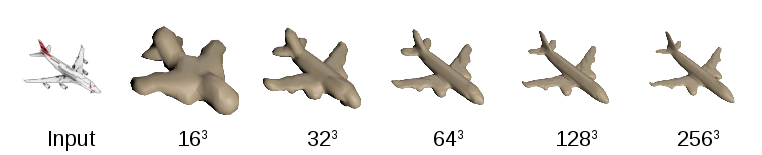

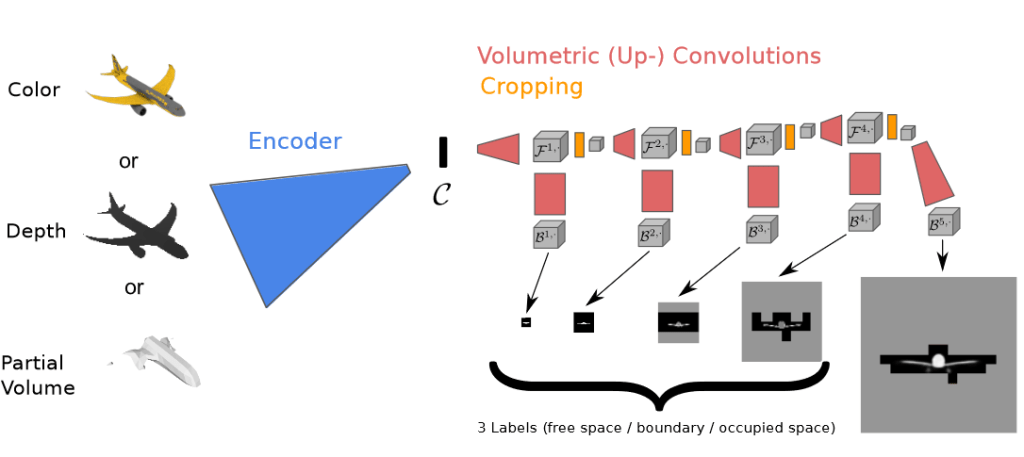

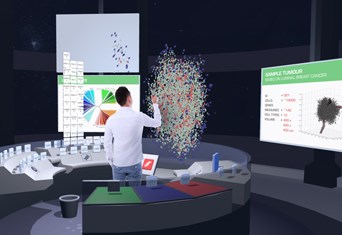

Baobab StudiosのInvasionやAsteroidsといったハイエンドVRコンテンツから、Eyetouch RealityのようなVR・AR機器向けの次世代ビジュアルメッセージサービスなど幅広い可能性がある中、一般大衆向けのコンテンツやアプリケーションをつくる際には、どうすれば多くの消費者にその存在を知らせ、トライアルの効果を行き渡らせることができるのだろうか?

Penrose StudiosでCEOを務めるEugene Chungは、業界全体の動向について「新しい芸術的な表現方法としてのVR・ARの発展というのは、これまで前例がありません。このような大きな転換が最近起きたのは、動画関連の技術が進化したときでした。誕生したばかりのハードウェアがまだ市場に浸透していないため、今の段階ではVR・ARの本領が発揮されていませんが、その状況もかなりの速さで変わっています。PlayStation VRやGoogle Daydreamの誕生で、消費者が手にしやすいVRの市場がこれまでにないほど成長しています。テクノロジーに詳しい人の大部分は既にVRを体験していますが、消費者の大多数はまだVRに触れられていません。一般消費者がVRを体験してその力を理解すれば、普及率も上がってくるでしょう」と語っている。

Sketchfab CEOのAlban Denoyelは「ユーザーが自分でVRコンテンツをつくれるようになれば、普及率は上がってくるでしょう。家族や休暇の様子をVR用に(360度もしくは3Dで)撮影すれば、きっとVRシステムを使ってそれを視聴したいと思うはずです。そのため、ユーザー・ジェネレイテッド・コンテンツがVR普及の鍵となるでしょう。ターゲット層へのアプローチに関しては、ソーシャルネットワークのように、既にターゲットがいる場所へコンテンツを届けることが大切になってきます。だからこそ、アプリを介すことなくクリエイターから消費者へ直接コンテンツが提供できるWebVRが重要視されているんです」と話す。

若者にフォーカス

一般消費者には、あなたの姪から祖母まで色んな人が含まれている。しかしFacebookやSnapchatなど最近のテック界での成功例を見ると、大衆にターゲットを移す前のローンチ時に、若者の支持を集めたサービスが多いことに気がつく。そのため、VR・AR界も一般消費者にアプローチする前に、Pokémon GOやSnapのSpectaclesのように、流行に敏感な若者にプロダクトを試させる必要があるのだ。古い言葉で言えば”Ditto(同じ、前例にならって)”ということだ。

[原文へ]

(翻訳:Atsushi Yukutake/ Twitter)