MITの研究者たちが、睡眠をワイヤレスでモニタする新しい方法を公開した。それは反響定位法(エコーロケーション, echolocation)に似ていて、電波を睡眠者に当てて反射波を捉え、体の影響による電波の変化を調べる。

チームはこれまでも、低出力の電波をモニタリングに利用する方法をいろいろトライしてきたが、今回のはその最新の成果だ。今回はAIを利用することによって、睡眠者の体のわずかな動きでも、電波の変化の中に捉えることができた。それにより、睡眠ステージ(浅い深い、REM/NREM)、睡眠中の運動、呼吸率など、睡眠のパターンに関する有意味な情報を得ることができた。

テストは25名のボランティアに対し、100晩かけて行われた。研究の指導教授Dina Katabiによると、そのシステムは80%の正確度で睡眠パターンを検出できた。それは業界標準の睡眠テストEEGにほぼ匹敵する。

睡眠の追跡調査はFitbitやApple Watchのようなウェアラブルでもある程度行われているが、それらはもっぱら、スマホが内蔵している加速度計を使って体の動きを検出し、それにより睡眠のパターンを判断している。

“ウェアラブルもいいけど、われわれのねらいは、目に見えないものを捉えることだった”、とKatabiは語る。“それは家庭の中で、みんなが忘れてしまうぐらい目立たないが、しかしそれと同時に、ワイヤレスの信号だけを使って健康上のあらゆる問題をモニタできる”。

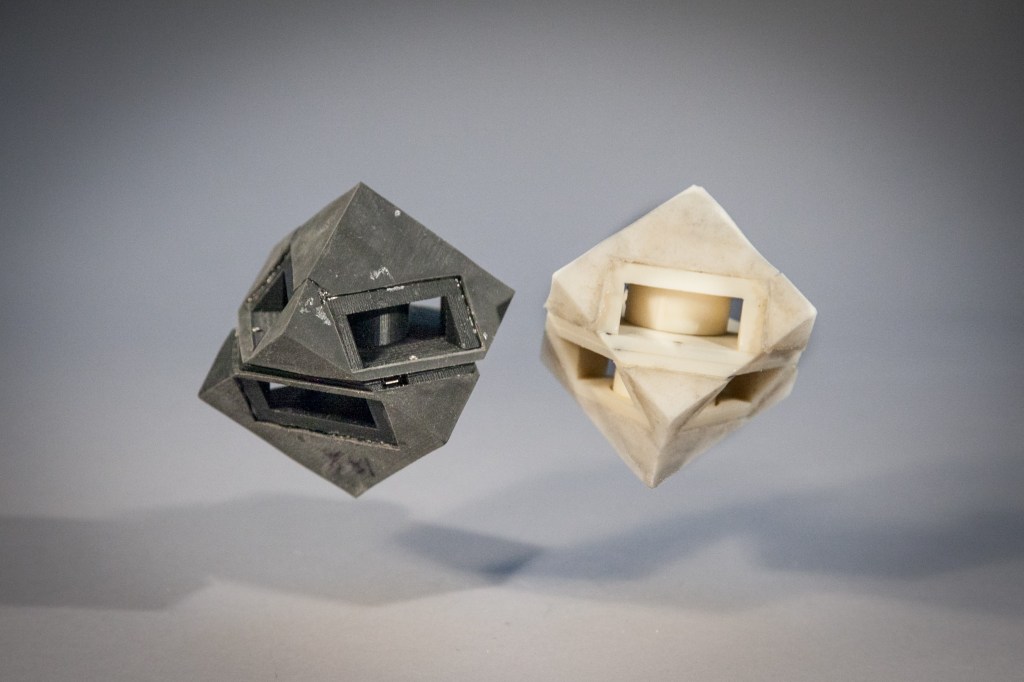

そのワイヤレスシステムは、取り上げる要素がウェアラブルよりずっと多い。動きだけでなく、呼吸や心拍も捉える。それでいて、まったく生活の邪魔にならず、ベッドから数メートル以内の棚や壁に目立たない形で置ける。

使用する電波はWi-Fiよりずっと弱く、一家の中で複数台を複数の人に対して使える。調整などは要らない。被験者にとって、まったく気にならない存在であることも、本機の理想的な性質だ。

本人がその存在を忘れている状態で長期の検診ができるから、パーキンソン病やアルツハイマー病のような睡眠障害と関係の深い疾病のモニタにも向いている。ただし、そこまで一般化大衆化するためには、まずFDAなどの認可が必要だ。結果はすでに良好だから、それも大丈夫だと思えるが。