[筆者: Dave Mariani](AtScaleのCEOで協同ファウンダー。)

ビッグデータとビッグデータ分析の世界に最近、二つの重要な展開があった。まず、Tableau(DATA)が決算報告を出したが、EPSはアナリストたちの予想を$0.05下回り、同社の株価は5%下がった。そしてHortonworks(HDP)は売上の低迷を発表し、それにより株価は大幅に下落した。

ビジネスインテリジェンス(BI)やHadoopの世界に、今何が起きているのか? BIやビッグデータの世界が内部崩壊する前に、われわれは遠くの高台に避難すべきか?

何をどう考えていたのか?

市場記事のセンセーショナルな見出しを見て、怖がる必要もないが、しかし、彼らの予想を裏切る業績の背後には、投資家たちやテクノロジー企業を買収しようと考えている人たちが留意すべき重要なトレンドがある。

まず、純粋にパフォーマンスだけを見るとどうか。Tableauはビジネスインテリジェンスのリーダーだ、と多くの人が見ている。売上は前年比で35%も増加した。上場しているデータ分析企業で、昨年こんなペースで成長したところが、ほかにあっただろうか?

これを、業界全体と対比してみよう。Gartnerの予想では、2016年の全世界のIT支出額の成長率は0.0%、すなわち横ばいだ。そんな中で35%の成長は、きわめて異例である。Hortonworksの前四半期はどうか。売上は前年同期比で46%増加している。

一体どういう意味か?

投資家の期待や予想は、頑固だ。テクノロジーバイヤー*や業界のオブザーバーは、(一見成績の良い)両社のパフォーマンスを、業界全体の傾向や見通しと照合したうえで、評価する。〔*: technology buyer, テクノロジー系の企業やその株を買おうとしている人たち、≒テクノロジー指向の投資家。〕

たとえばTeradataも最近、売上を報告したが、同社のビジネスは前年比で約4%縮小した。だからほかの条件が変わらなければ、Hortonworksの売上は2020年までにTeradataを上回るだろう。

ここからどこへ行くのか?

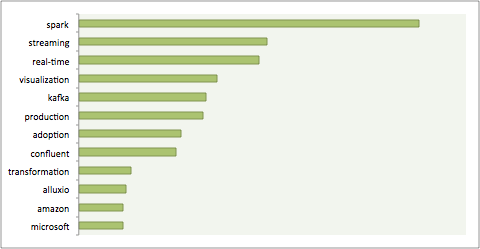

あなたがテクノロジーバイヤーなら、これらの短期的な業績にはとらわれないだろう。あなたが気にするのは、この業界にこの夏、何が起きたかだ。Workdayは7月にPlatforaを買収し、Qlik Techは6月に投資企業Thoma Bravoに吸収された。噂ではAmazonは来月、ビジネスインテリジェンスの視覚化ソリューションをリリースするらしい。もちろんMicrosoftとGoogleには、すでにこの市場向けの製品がある。

視覚化やビジネスインテリジェンスを一社に絞ることは、最近ますます難しい。だから業界のいろんな選手たちの業績を気にするよりは、全体としての彼らの技術の方向性やビジョンに着目すべきなのだ。

たとえばこの市場では、一枚岩的でクローズドなやり方は、きわめて受けが悪い。Platforaのアーキテクチャを見て気づくのは、そのエンドツーエンドの統合に最大のメリットがあることだ。データプラットホームという一方のエンドから、視覚化レイヤという片方のエンドまで、全体が統合化されている。しかしこのアプローチが有効なのは、ユースケースがきわめて特殊で、ユーザーが少数の高度な専門家であるときだ。何十万ものユーザーを対象とする幅広いユースケースのためにデータサービスを提供したい、と考えている一般企業には、向いていない。

しかしTableauは、セルフサービス型ビジネスインテリジェンスというものを開拓し、業界全体をその方向へ向かわせようとしている。MicrosoftやGoogleやAmazonが視覚化市場への参入に熱心なのは、Tableauの成功によって、データをビジネスユーザーの手中に置くことの威力を、思い知らされたからだ。

プラットホームのベンダーは今明らかに、今後成長し栄える市場がこれであることに、気づいている。Tableauが見つけたのは、本当にビジネスインテリジェンスを必要としているのは、日々十分なサービスにも恵まれず日陰に放置されている、9億人を超える情報労働者であることだ。それだけでも、今もっともらしく“ビジネスインテリジェンス”と呼ばれている市場の、約10倍はある。MicrosoftやAmazonがビジネスインテリジェンスの低価格化をトライしていることからもうかがわれるように、明日の業界が必ず目にするのは、BIが、これまで、そんなものとは無縁だと思われていたところで増殖し拡大していく光景だ。