【抄訳】

AWSは今四半期でも、クラウドインフラストラクチャ市場の無敵のトップだ。いわゆる成長率ではMicrosoftやGoogle、Alibabaなどが高いが、彼らは分母が小さすぎるから、その成長はAWSから見れば痛くも痒くもない。

AWSの今四半期の売上は、45億7000ドルという巨額だ。この額はアナリストたちの予想45億1000万ドルを上回り、この成長率が続けば2017年の年商が180億ドルに達しそうなペースだ。

“でも、Microsoftのクラウド部門は年商200億ドルでしょ?”、と言うのは無意味な比較だ。なぜならそのクラウド部門なるものに大きく貢献しているのはAzureのようなインフラプラットホームではなくて、Office365などのSaaSビジネスだ。IaaSとかSaaSとか、クラウド方面の謎のような言葉は、この記事で勉強できるだろう。

クラウド市場を追い続けるアナリスト集団Synergy ResearchのJohn Dinsdaleによると、クラウド市場のマーケットシェアを云々するときはSaaSを別立てで計算すべきである。そしてIaaSとPaaSおよびプライベートクラウドを合わせた市場では、SynergyによるとAWSのシェアは35%だ(下図)。他社は、はるか後方に引き離されている。

【中略】

Synergyが作った上図を見ると、AWSはいわゆる“ダントツ”である。Microsoftも頑張ってはいるが、AWSには接近できない。同じくアナリスト企業のCanalysは、やや低い31%をAWSのシェアとしているが、市場の全体像としてはSynergyの結果とほぼ同じだ。

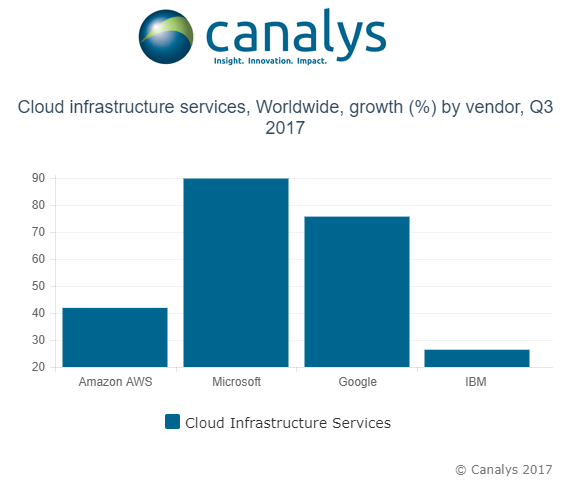

ちょっと意外なのは、これら競合サービスの成長率の高さかもしれない(上図および下図)。Canalysの数字では、AWSの成長率およそ40%に対してMicrosoftは90%、Googleはおよそ75%だ。でも、小額な売上増でも、分母が小さいと増加率は大きくなるのであり、いずれにしても当分は、AWSの牙城はびくともしない。

もちろんクラウド市場はまだ飽和にはほど遠くて、今後ますます大きくなると予想されるが、成長率の高いMicrosoftも含めて、AWSにとって‘脅威’と言えるほどのコンペティターはまだ存在しない。

CanalysのリサーチアナリストDaniel Liuは、こう言う: “AWSは多様なサービスとデベロッパーの大きな知名度により、先行馬としての優位を維持し続ける。しかし後続集団の中での先頭は、伝統的にエンタープライズに強く、Office互換性という有利性を持つMicrosoftだろう。Microsoftのもうひとつの強みは、強力なハイブリッドクラウドソリューションにおける技術と経験だ”。

一方AWSのCEO Andy Jassyは、自社の優位性についてそれほど楽観的ではない:

“これからの市場では、一人勝ちはありえない。この業界はコストが大きいし、サービスの品揃えの豊富さと最先端性が重要だから、30社が市場にひしめくということはありえないだろう。でも、成功者が複数社になることはほぼ確実で、それらの名を今挙げることはできない。でも長年のエンタープライズ顧客が多くて営業に大軍を抱える古顔たちが、きっとその中にはいるだろう”。

でも、少なくとも現状のクラウドコンピューティング市場では、各社間の売上規模の格差が大きく、またクラウドサービスの内容も多様なので、成長率等の数字を見るときは注意が必要だ。

〔訳注: 各社、発表している数字の部門分けなどがまちまちなので、成長率90%、75%のMicrosoftやGoogleが、成長率40%のAWSに追いつくのは何年後か、という単純計算も、一般に公表されている数字からはできない。〕