今週行われたGoogleのハードウェアイベントでは、Androidの新バージョンAndroid 7.1(Nougat 7.1)についてほとんど触れられていなかった。というのも、Pixelに盛り込まれる目玉機能のいくつかは新OSには搭載されない予定なのだ。備え付けのカスタマーサポートサービスであるGoogle Assistantや、オリジナル解像度で写真・ビデオの無制限バックアップができるSmart Storageなどは新OSには搭載されない。

どの機能が”Pixelオンリー”なのかについては、Android Policeが既にGoogleの内部から入手したログを引用してレポートしていた。そしてこの度、Googleはその内容が正しいと認めたのだ。

搭載されない機能のいくつかについては納得がいく。例えば、iPhoneからAndroidへのデータ移行を簡単にする“クイックスイッチ”アダプターは、Pixelにしか同梱されない予定だ。というのもこれにはケーブルアダプターというハードウェアが必要になる。

Pixelの新しいカメラアプリもハードウェアに依存している。Pixelの背面には12.3メガピクセルのカメラが搭載されており、4Kビデオが撮影できる他、連続で複数枚の写真が撮れる”スマートバースト”といった特別機能もいくつか盛り込まれる。

さらに、Pixelにはさまざまなセンサーや接続方法(Wi-Fi、セルラー移動通信、GPSなど)を集約したSensor Hubプロセッサーが搭載されている。

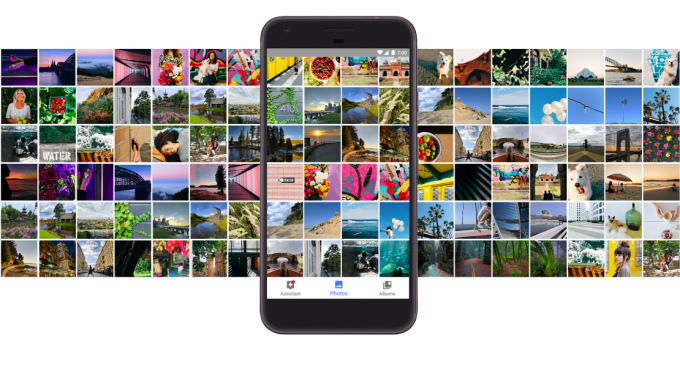

Google Photos経由の無制限写真・ビデオバックアップサービスを無料でバンドルするというのは、上手いマーケティング戦略であるとも言える。自分のAndroidをアップグレードする言い訳を求めている写真好きにとっては、このサービスを利用できるだけでPixelが魅力的に映るだろうし、iCloudにお金がかかることを考慮すると、iPhone 7よりもPixelを選ぶ人がいるかもしれない。

しかし、新OSで採用を見送られた機能の中には疑問に感じるものもある。

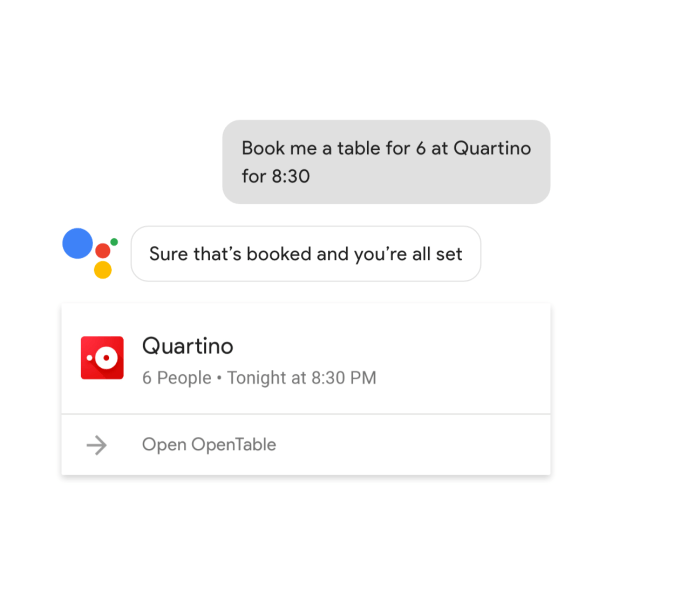

1番大きなものとして、Nougatのアップデート版であり、PixelやPixel XLのOSに採用されているAndroid 7.1には、Google Assistantが含まれていない。このスマートバーチャルアシスタントは、AppleのSiriやMicrosoftのCortana、AmazonのAlexaに対するGoogleの答えだ。さらにGoogle Assitantは、現存するAndroidデバイスに搭載され、スタンドアローンのアプリとしても配信されているデジタルアシスタントのGoogle Nowよりも強力なことで知られている。

そもそもGoogle Now自体もパワフルで、自然言語が処理できるほか、競合サービスのようにさまざまなアシスタント機能を果たすことができる。通勤路を利用してどのくらいで自宅に着くかや、飛行機に間に合うにはいつ出発しなければならないか、いつ頃荷物が届くか、さらに天気・スポーツ・株式に関する情報や、イベントのリマインダー機能など、ユーザーが気になる情報に関するアラートを発信してくれる。

さらにGoogle Nowは、近場のレストランやお店に関するユーザーの質問に回答することで、Google検索のとっかかりになっているほか、単純にウェブ上の情報も検索できる。より実用的な機能として、デバイスの設定変更やテキスト・メールの送付、電話をかけたり、リマインダーを設定したりといったこともできる。

しかし、Google Assistantはさらにその上をいく、Google Nowがよりスマートになったアップグレード版のようなものだ。Google Nowができることは全てできるのはもちろん、その根底にあるAIテクノロジーはユーザーと双方向の会話ができるため、話の中で出てきた情報を記憶し、後日別の話をしているときにその内容を引っ張り出すことができる。さらに、サブスクリプション機能を利用して、ユーザーが気にしている情報のアップデートを毎日配信することも可能だ。

また、Google Assistant経由で、ChromecastやGoogle Castを搭載したデバイスのほか、NestやSmartThings、Philips Hueのスマートホームデバイスも操作することができる。

サードパーティ製のサービスともAction(Alexaの”Skills”のGoogle版)を介して連携可能だ。

Google Assitantの強力な機能を考えると、Android 7.1からGoogle Nowに取って代わらないのは残念だが、今後Pixel以外のデバイスにAssistantが登場しないというわけではない。同時に、AssistantをずっとPixelだけの機能にするのはバカげている一方、近いうちに無料のAndroidアップデートに盛り込まれるとも考えづらい。

Googleの広報担当者は下記のように話している。

私たちのゴールはGoogle Assistantをできるだけたくさんのユーザーに使ってもらうことです。来年中もGoogle Assitantの新たな機能を順次発表していく予定です。

Pixel Launcherとユーザーインターフェースについては、PixelにだけAssistantにアクセスするためのナビゲーションバーアイコンが表示される。その他には、システムUIのアクセントカラーテーマや、新しい見た目と雰囲気のセットアップ画面、新しい壁紙設定機能、日付が表示されるカレンダーアイコンなどもPixelのみで利用可能だ。

そうは言っても、Android 7.1にも、いくつか使える機能が搭載される予定だ。

ハードウェアアクセラレーションに対応したナイトライトや、タッチ機能・ディスプレイ性能の向上、Moves(ステータスバーを開閉するための指紋ジェスチャー)、シームレスな自動アップデート、Daydream VRモードへの対応のほかにも、開発者向けにアプリショートカットのAPIやサークル型アプリのサポートなどが発表された。

Android 7.1はディベロッパープレビューとして今月中にローンチ予定だ。一方で、いつ頃一般消費者向けのバージョンが配信されるかや、どのデバイスが最初にアップデートできるようになるかについてはGoogleと確認がとれていない。

[原文へ]

(翻訳:Atsushi Yukutake/ Twitter)