おそらくこれまでに、国防総省による「勝者総取り」の100億ドル規模の大規模なクラウド契約について耳にしたことがあるだろう。これは別名Joint Enterprise Defense Infrastructure(略称JEDI:ジェダイ)と呼ばれている。

スター・ウォーズを連想させる名前はともかく、この契約は政府の基準に照らしてみても巨大なものだ。ペンタゴンは、単一クラウドベンダーがその組織クラウドを構築することを望んでいる。事の是非はさておき、彼らはそれこそがクラウド戦略に集中しコントロールをするための最適なアプローチであると信じているからだ。

国防総省(DOD)のスポークスマンHeather Babbは、TechCrunchに対して、同省はこのやり方をとることに多くの利点を見ているのだと語った。「単一契約は有利です。なにしろ何よりもセキュリティを改善し、データアクセス性を改善し、そして国防総省がクラウドサービスに対して適応し利用する過程を単純化してくれるからです」と彼女は言う。

この契約のために国防総省がどの企業を選択しようとも、これはコンピューティング基盤とその戦闘組織を、旧来の基盤もある程度取り込みつつ、IoT、人工知能、そしてビッグデータ解析の世界に向けて近代化することなのだ。「このDODクラウド・イニシアチブは、国防総省の情報技術体制の近代化に関わる遥かに大きな動きの一部なのです。この試みの基礎は、現在国防総省内にあるネットワーク、データセンター、そしてクラウドの数を合理化することです」とBabbは語る。

その後の動向を決める

このDODの契約を勝ち取るものは誰でも、政府内での類似のプロジェクトに対して有利な立場をとることが可能になるだろう。結局のところ、軍に対してセキュリティと信頼性で合格することは容易なことではない。そしてもし1つの会社がそれを遂行する能力があると証明できたなら、この先の取引を、安泰なものとすることができるだろう。

しかしBabbが説明するように、それはクラウドを長期的に理解するという行為なのだ。「JEDI Cloudは、DODがエンタープライズクラウドソリューションをどのように取り込むべきかを学ぶ手助けになる、草分け的な取り組みとなるでしょう。そしてデータ駆動型意思決定を可能にし、DODがアプリケーションとデータリソースを最大限に使うことを可能にする重要な最初の1歩となるのです」と彼女は言う。

写真: Mischa Keijser for Getty Images

だが、この単一ベンダー方針は、応札している様々なクラウドベンダーたちが少々取り乱している理由を説明するものだ。ただしAmazonを除いてだが ―― 同社はほとんど何も語らず、一見事態の推移を落ち着いて眺めている。

その他のプレイヤーたちが信じているのは、Amazon がこの入札の主導権を握っているということだ、なぜならAmazonは2013年に政府に対して6億ドル分のクラウド契約を提供し、CIAのためにプライベートクラウドを立ち上げているからだ。当時それは様々な意味で大きな取引だった。何よりもまず、それは情報機関がパブリッククラウドプロバイダーを使った、最初の大規模例だった。そして当然のことながら、当時の金額は印象的で、100億ドルという規模ではなかったものの、良い契約だった。

こんなことを言っても慰めになるかどうかはわからないが、Babbはそのような意見を一蹴する。入札プロセスはオープンで、有利に扱われるベンダーはないと言うのだ。「JEDI Cloudの最終RFP(提案依頼書)はDODのユニークで重要な要求を反映したものです。競争力のある価格設定とセキュリティのベストプラクティスが考慮されます。どのベンダーも事前に選択されてはいません」と彼女は言う。

大声で不満を言う者

ペンタゴンが今後10年間に向けての主要なクラウドベンダーを選ぶ方向に向かう中で、特にOracleは、耳を傾ける者たちに対して、Amazonはこの取引に対して不公平に有利な立場に立っていると不満を言い続けている。そして先月には正式な訴状を提出している。これは入札がまだ始まってもおらず、ペンタゴンが決定を行う遥か前のタイミングだ。

写真: mrdoomits / Getty Images (一部編集)

皮肉なことに、自身の過去のビジネスモデルにもかかわらず、Oracle は何よりもこの取引が、国防総省を長期間にわたって1つのプラットホームにロックインしてしまうことに不満を述べているのだ。またワシントン・ポストのレポートによれば、Oracleは入札プロセスが、この手の取引の調達規則を遵守しているかどうかに対して疑問を呈している。またBloombergによれば、4月には共同CEOのSafra Catzが直接大統領に対して、この取引はAmazonのために誂えられていると不満を訴えたと言う。

Microsoftも単一ベンダーのアイデアに満足していない。単一ベンダーに制限してしまうことで、様々な変化が起きるクラウドマーケットの世界の中のその他の企業からのイノベーションを、ペンタゴンは取り入れ損なう可能性があると指摘する。特にそれほどまでに長期にわたる契約について語っているときは尚更だ。

4月にMicrosoftのLeigh Maddenは、同社は競争する準備は整っているが、単一ベンダーアプローチが必ずしも最善の道とは思わないと、TechCrunchに対して語った。「もしDODが単一ベンダーだけを採用する道を行くのなら、私たちは勝つために参加します。しかしそうは言いいながらも、それは私たちが世界で見ているような、80パーセントのお客様がマルチクラウドソリューションを採用している動きとは、対照的なものなのです」と彼は同時に語った。

彼の指摘は妥当だが、90年代のような独自システム(OracleやMicrosoftがその代表だ)に比べて、クラウドは遥かに大きな相互運用性を提供するのにかかかわらず、ペンタゴンは単一ベンダーのアイデアを推し進める決意をしているように見える。

Microsoftもそれ自身の大規模な契約をDODと結んでいるが、その規模はほぼ10億ドルに達する。2016年から続くこの取引はDODの職員のためのWindows10と関連するハードウェアの関するものだが、AmazonがCIAと結んだような純粋なクラウド契約ではない。

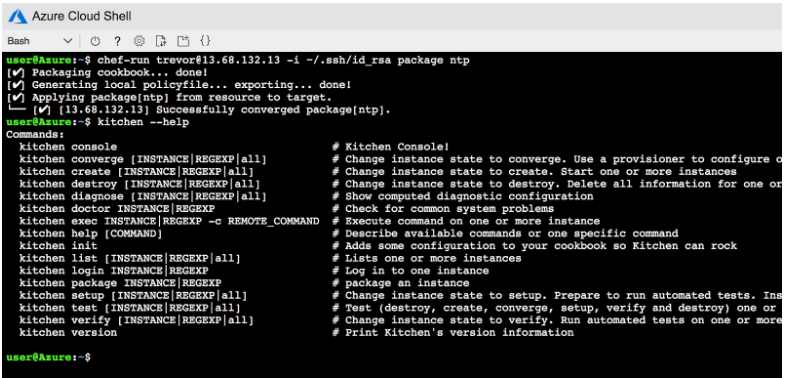

また同社は最近、政府向けのAzure Stackをリリースした。これは政府の顧客に対してプライベート版のAzureを、パブリック版と全く同じツールと技術と共にインストールするもので、JEDI入札の際には魅力的なものとなるだろう。

クラウド市場の動向

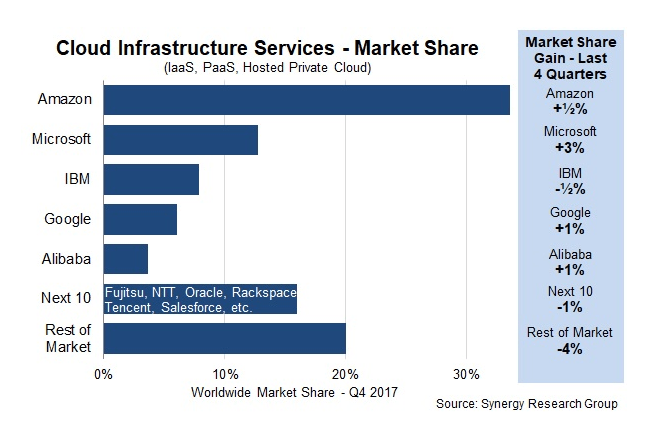

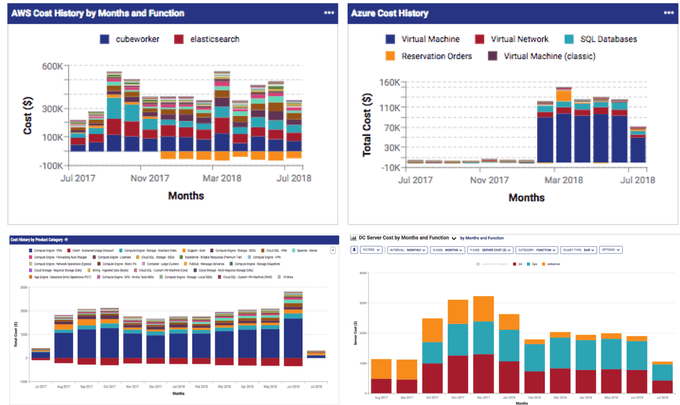

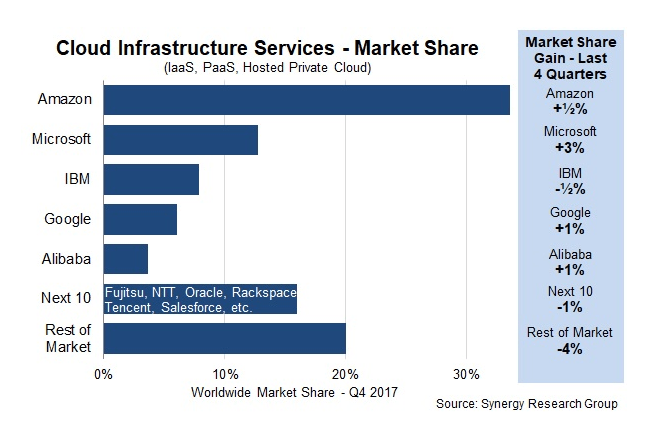

またAmazonがクラウドインフラストラクチャ市場の最大のシェアを占めているという事実が、ある程度効果を発揮する可能性もある。Synergy Researchの2017年第4四半期データが明らかに示すように、Microsoftは急速に成長してはいるものの、それでも市場規模という意味では、Amazonのまだ3分の1に過ぎない。

このデータが出されて以来、市場は劇的には変化していない。市場シェアだけが決定要因ではないものの、Amazonはこの市場に最初に参入した企業であり、市場での規模という意味では後続の4社を合計したものよりも(Synergyのデータによれば)遥かに大きいのだ。これは、なぜ他のプレイヤーが非常に激しいロビー活動をしており、Amazonを最大の脅威であると考えている理由を説明できるだろう。なにしろ、その凄まじい大きさゆえに、おそらくあらゆる取引で向かい合うことになる最大の脅威だからだ。

最大の不満の声をあげるOracleがが、何年もの間クラウドを無視していたために、乗り遅れていることも考慮しよう。彼らはJEDIプロジェクトを、プライベート版のクラウドビジネスを構築するために使うことのできる、政府の中の足場を確立するチャンスだと考えているのだろう。

10年は10年ではないかもしれない

実際の取引には、複雑な部分と、スポーツ選手のように最初の2年だけが保証された、オプトアウト条項が含まれていることは指摘しておく価値はあるだろう。その後2回の3年のオプションが続き、最後の2年のオプションで契約はクローズする。これが意味することは、もしこれが良くないアイデアだと判明したならば、ペンタゴンは様々な地点で契約を終了できるということだ。

写真:Henrik Sorensen / Getty Images (編集済)

JEDIの「勝者総取り」アプローチにもかかわらず、何が起きようともDODは複数のクラウドベンダーと作業を続けるとBabbは述べている。「DODは複数のクラウドを所有していますし、その運用も続けるつもりです。そしてJEDI Cloudは、DODのクラウド全体戦略の重要なコンポーネントとなるでしょう。私たちの任務の規模は、DODが複数のベンダーから複数のクラウドを調達することを要請するのです」と彼女は言う。

国防総省は8月に最終入札を受け入れ、RFPへの最終締切を10月9日(米国時間)へと延長した。締め切りが再び延長されない限り、この先数週間のうちに、私たちは幸運な会社の名前を耳にすることになるだろう。そしておそらく決定の暁には、多くの泣き言が聞こえ、敗者たちからの様々な策が巡らされることになるだろう。

[原文へ]

(翻訳:sako)

画像: Glowimages / Getty Images (編集済)

本日(米国時間10月9日)、Cloud Foundry財団は、両者の統合を新しいレベルに進めるために、2つの新しいKubernetes関連プロジェクトを立ち上げた。1つ目は

本日(米国時間10月9日)、Cloud Foundry財団は、両者の統合を新しいレベルに進めるために、2つの新しいKubernetes関連プロジェクトを立ち上げた。1つ目は 2番目の新しいプロジェクトは、最初Suseによって開発された

2番目の新しいプロジェクトは、最初Suseによって開発された