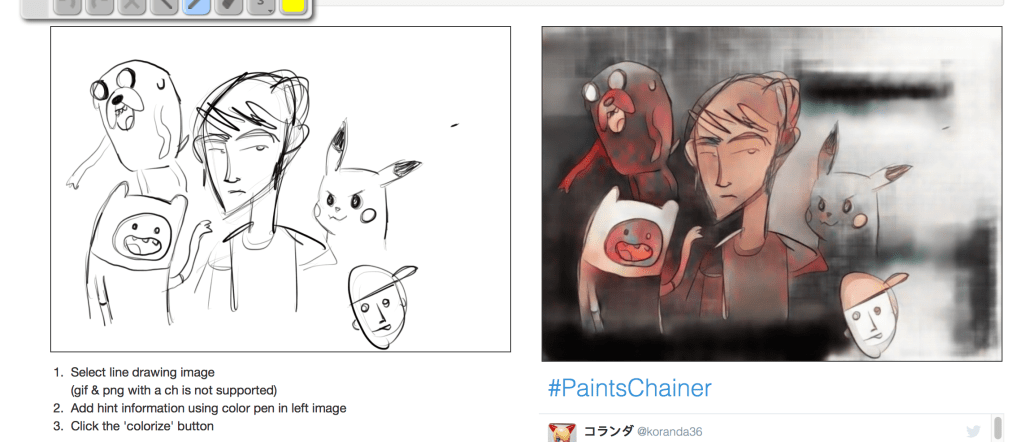

TechCrunch Japanでも機械学習やディープラーニングを含めた人工知能について何度も取り上げている。最近ではGoogleのリアルタイム翻訳や日本発のニューラルネットワークを利用した線画着色システムの記事を掲載している。

そこでこうしたトレンドを横断的に見渡せる入門書があると便利だろうと考えていたが、 最近、日経BPから刊行された『グーグルに学ぶディープラーニング』が役に立ちそうなので紹介してみたい。

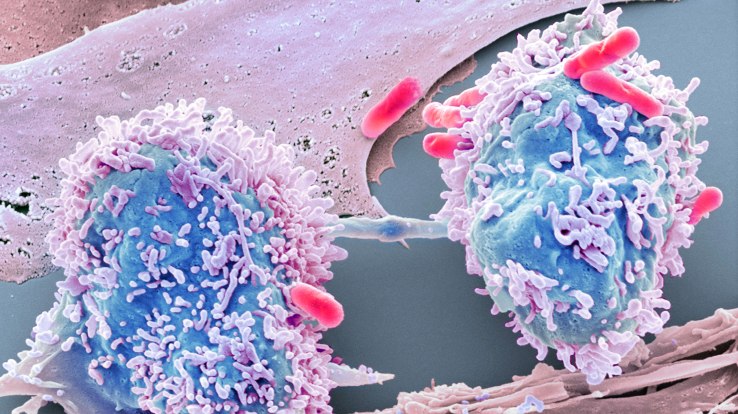

本書ではまず人工知能の一部が機械学習、機械学習の一部がディープラーニングという位置づけを説明し、続いてGoogleのデータへの取り組みを中心として実例が紹介される。「入門」篇ではニューラルネットワークを利用したディープラーニングが解説されている。ニューラルネットワークの入力層では画像の各部分の明暗などの物理的情報が得られるだけだが、脳のシナプス構造を模した層を重ねるにしたがって高度な情報が生成され、最後に「この写真はネコだ」というような判断が下される。60ページのイラストはこの関係が直感的にわかりやすい。

後半では企業の導入事例が紹介されている。特に三井住友フィナンシャルグループではディープラーニングをクレジットカード不正の検知に利用して大きな成果を収めているというのが興味ある例だ。オンライン取引の不正検知では数年前からアメリカでディープラーニングを利用した取り組みが注目されているが、日本の大手銀行系組織でもすでに実用化されているようだ。

本書はIT実務者、企業管理職向けの入門書なのでディープラーニングの積極面の紹介が中心となっている。そこからはやや脱線するかもしれないが、「弱いAI」と「強いAI」について補足しておいてもいいかもしれない。「強いAI」というのは「人間の知能そのものを再現する」ことを目標にしたアプローチで、初期のAI研究の主流だったが、実はことごとく失敗している。通産省が主導して鳴り物入りで10年間も開発を続けた日本の第5世代コンピュータは「強いAI」のいい例かもしれない。

その後「汎用知能」を目指す「強いAI」に代わって、「結果を出せればよい」とする「弱いAI」が登場した。1997年にチェスの世界チャンピオンを破ったIBMのDeep Blueに対して「強いAI」から「本当の知能ではない」という批判が出た。このとき、コンピュータ科学者のDrew McDermottはNew York TimesにYes, Computers Can Think (イェス、コンピュータは思考できる)という記事を書いた。この中の「Deep Blueが本当は考えていないというのは飛行機は羽ばたいていないから本当は飛んでいないというのと同じだ」という反論は「弱いAI」の立場を代表する言葉としてあちこちで引用されるようになった。

本書でも詳しく紹介されているが、機械学習が成果を挙げるには、機械の能力の進歩と同時に機械に学習させるための膨大なデータが必要となる。つまりハードウェアの能力とインターネットの普及によるデジタル情報量の爆発が「弱いAI」を可能にしたといえるだろう。あるマシンにネコが写っている写真を10万枚入力するとそのマシンはネコが認識できるようになる。「弱いAI」の立場からは機械がネコを認識できれば当面それでよい。

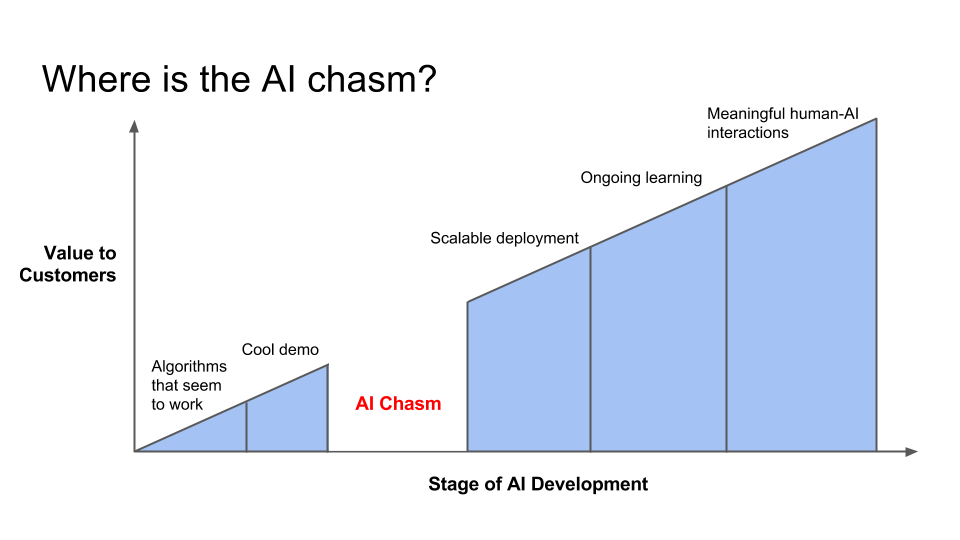

人工知能は現在ガートナーのハイプ・サイクルにいう「流行期」に入ってきた。人工知能がニューラルネットワークやディープラーニングによって強化されると、次第に「汎用知能」を構成したいという誘惑が生じる。つまり「強いAI」的な考え方の復活だ。「機械が知能をもち、なんでもできるようになる」という「強いAI」的約束はわかりやすく、流行期の過剰期待を作り出すのに非常に効果的だ。

しかし、流行期の山が高ければ幻滅の谷も深くなる。このあたりは人工知能利用にあたって現在もっとも警戒しなければならない点だろう。『グーグルに学ぶディープラーニング』の末尾ではGoogleの機械学習の責任者ジア・リー氏にインビューしている。そこでリー氏が「AIの技術ありきではなく、現実世界で解決すべき課題の内容そのものが私たちにとって最も大切」と語っているのは重要な指摘だ。

本書は日経BPの専門誌、日経ビッグデータに掲載された記事を中心に再構成、補筆したものだという。日経ビッグデータの杉本昭彦編集長から献本いだいた。