ものごとの動きがこれほど速くなると、しくみに対するわれわれの想像が、実際に機能しているしくみに追いつくまでに少々時間がかかるのはいたしかたない。ただ、これは非常に繊細な問題なので誤解を解いておく価値があるだろう。Apple(あるいはGoogleでもどこでも)は特別なフォルダーをもっていて、いけない写真は全部そこに保管してある、という噂。心配になるのは当然だが、幸いなことに実際そんなことは起きていない。

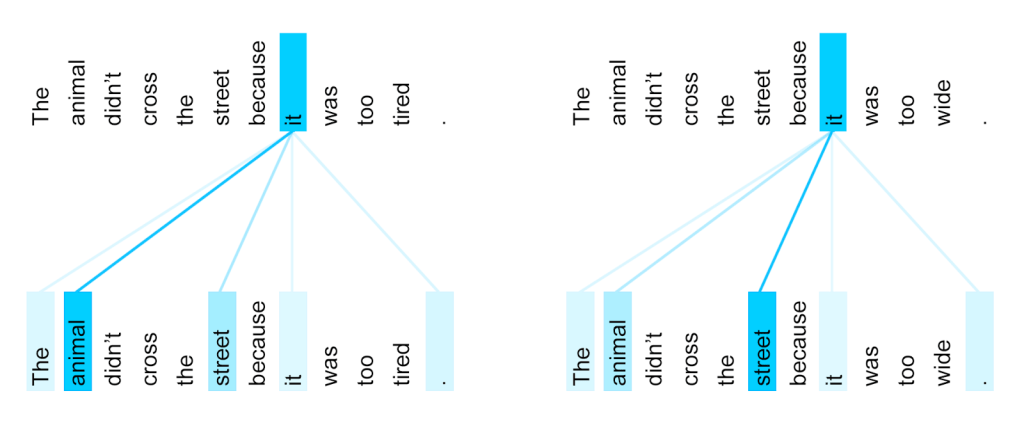

そういう会社が何をやっているかといえば、何らかの方法で写真の内容を分析することだ。彼らは高度な画像認識アルゴリズムを使って、犬やボートから人の顔まで何でも簡単に識別できる。

犬が検出されると、その写真に関連付けられたメタデータに「犬」タグを付加してシステムが追跡できるようになる。撮影時の露出設定、位置情報なども一緒に保存されている。これは非常に低いレベルで行われる処理なので、システムは犬がなんであるかは知らない。単に特定の数値(様々な視覚的特徴に対応している)に関連付けられた写真をとってくるだけだ。しかしこうすることで目的物を検索したときシステムは容易に見つけられるようになる)。

通常この分析はセキュリティー保護された「サンドボックス」の中で行われ、識別された内容はほとんど外へ出ない。もちろん特別な例外はある。例えばチャイルドポルノに関しては非常に特殊な分類システムが用意されており特別にサンドボックス外へのアクセスが許されている。

かつてサンドボックスは非常に大きくウェブサービスを必要としていた ―― 写真が内容に応じてタグ付けされるのはGoogleフォトやiCloudなどのアップロードした時だけだった。今はもう違う。

かつてサンドボックスは非常に大きくウェブサービスを必要としていた ―― 写真が内容に応じてタグ付けされるのはGoogleフォトやiCloudなどのアップロードした時だけだった。今はもう違う。

機械学習や処理能力の向上によって、以前巨大なサーバー群の中でしか生きられなかったアルゴリズムと同じものが携帯電話の中で十分実行できるようになった。このためあなたの写真をAppleやGoogleに送らなくても「犬」のタグを付けられるようになった。

セキュリティーやプライバシーの観点から見て、この方がシステムとしてはるかに優れていることは間違いない ―― プライベートなデータを検査するのに誰かのハードウェアを使い、秘密を守ってくれると信じる必要がなくなった。今でも信じなくてはならないが、信用すべき部分や手順が少なくなった ―― 「トラストチェーン」の単純化と短縮だ。

しかしこれをユーザーに説明するのは簡単ではない。ユーザーから見れば自分たちのプライベートな ―― おそらく非常にプライベートな ―― 写真が本人の承諾なしにカテゴリー分けされているのだから。会社の干渉なしにこれが可能だとは何とも信じ難い。

問題の一部はUIの欠陥にある。iPhoneの写真アプリで検索すると、(もし見つかれば)検索結果が「カテゴリー」として表示される。このことがこの写真はiPhone内のどこかにある「フォルダー」に「入っている」ことを暗示させている ―― 「車」や「水着」などのラベルをつけられて。ここで起きている問題は、検索の実際のしくみを伝達することに失敗していることだ。

この種の写真分類アルゴリズムの限界は、必ずしも柔軟性がないことだ。写真によく出てくる一般的な対象物を500種類識別できるようにシステムを訓練することはできるが、あなたの写真にそのうち1種類も入っていなければ何もタグ付けされない。検索した時に出てくる「カテゴリー」はシステムが探すように訓練されたよくある物事の名前だ。前にも言ったようにこれはかなり近似的なプロセスだ ―― 写真の中に一定の信頼度を超えた物体があるかどうかを見るだけ(例えば上の画像で、私が無響室にいる写真に「カートン」というラベルが付いてる。思うにこれは壁が牛乳パック(milk carton)に見えるからだろう)。

「フォルダー」を始め今日のコンピューターシステムにファイルが保管されているしくみに関するほとんどの知識は時代錯誤だ。しかし、デスクトップ式の階層化されたフォルダーシステムと共に育ったわれわれは、ついついそれを想像してしまい、写真が保管されているものがフォルダー以外であるとは考えられない ―― ただしフォルダーには作成、アクセス、管理などここではあてはまらない特殊な意味合いもある。

あなたの写真は「水着」のラベルがついたフォルダーの中に入っているのではない ―― あなたが検索ボックスにタイプしたテキストを写真のメタデータのテキストと比較して、一致すればその写真を表示しているだけだ。

これは、問題となっている会社があらゆる疑問について完全に無罪放免だという意味ではない。例えば、サービスはどんな対象やカテゴリーを探しているのか、何を除外しているのか、それはなぜなのか?どうやって分類アルゴリズムを訓練しているのか、例えばそれは、皮膚の色や性別の異なる人についても同様に有効なのか?どうやってこの機能を制御やるいは停止するのか、もしできないのから理由は何か?等々。

幸い私はトップIT企業数社と連絡を取り直接この質問をすることができたので、今後の記事で回答の詳細を伝える予定だ。

[原文へ]

(翻訳:Nob Takahashi / facebook )