Webプロジェクトの継続的なデプロイメントを支援するサービスNetlifyのビジョンは、Webサイトの作り方を変えることだ。とくに、フロントエンドのデザインとバックエンドで実行されるサービスとの結合を、もっとシンプルにしたい。今日同社は、そのビジョンの実現に向かう次の一歩として、NetlifyのサービスにAWS Lambdaのファンクションを導入した。

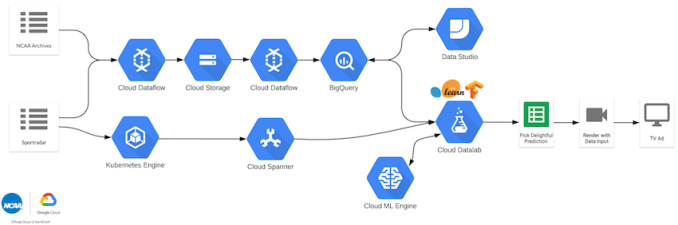

同社のねらいは、Web開発に伴う多くの複雑性を、できるだけ減らすことだ。たとえば、ユーザーがHTMLとJavaScriptでフロントエンドをデザインすると、Netlifyはそれをさまざまなサービスに結びつける。決済ならStripe、メールによるニューズレターの管理ならMailChimp、というように。このやり方でNetlifyは、Webサーバーという概念を抽象化(実体のないものに)してしまう。デプロイが遅くてセキュリティもスケーリングも困難なあのあれが、消えてなくなる。そして、一枚岩的なWebサイトから、スタティックなフロントエンドとバックエンドのマイクロサービスという組み合わせへ移行し、それによりセキュリティとスケーリングの問題を解決、そしてサイトを従来よりも相当早くユーザーに渡せるようになる(デリバリが早い)、と同社は信じている。

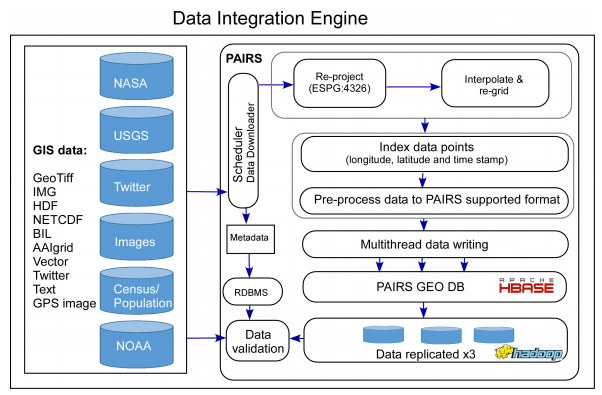

ユーザーは、サイトの構築に何を使ってもよい。ユーザーが作った設計/デザインを渡されたNetlifyは、バックエンドのコーディングのすべてをエッジに置き、コードはエッジで実行される。その意味で同社のサービスは、半分はContent Delivery Network(CDN)、残る半分はデベロッパーの自動化エンジンだ。

この、より動的なWebサイトをより早く作るというNetlifyの能力がAndreessen HorowitzのパートナーPeter Levineの目に留まり、昨年8月に同社の1200万ドルのシリーズを彼がリードした。Levineは曰く、“彼らの、マイクロサービスとAPIsを活用して柔軟性に富む動的な(ダイナミックな)Webサイトを作る、という考え方はすばらしいアイデアだ。しかも、エッジへデプロイすることによって、さらにハイパフォーマンスなユーザー体験を作れるし、GitHubを統合することによってアプリケーションを容易に作成し管理できる”。

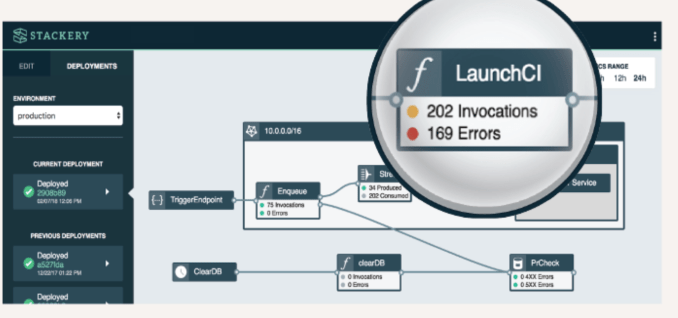

今日の発表は、同社のサービスのそんなアプローチをさらに一歩前進させる。Lambdは、AWSのいわゆるサーバーレス・ツールだ。デベロッパーはファンクションを作り、それが特定のイベントにトリガされて実行される。デベロッパー側には、サーバーを24/7動かし管理しメンテナンスする苦労がない。これは、NetlifyのWeb開発アプローチとぴったり相性が良い。つまりそれは、AWS Lambdaと同じく、WebのパブリシングプロセスからWebサーバーを取り除くから。

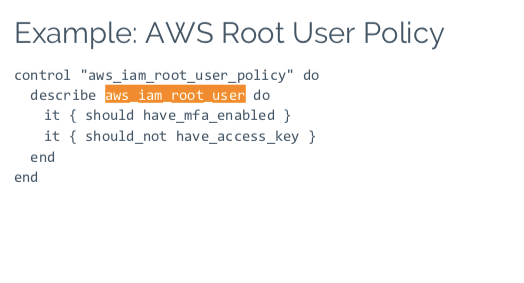

そしてNetlifyは、Lambdaのファンクションを、もっと容易に実行できるようにした。同社によると、Webデベロッパーは確かにイベントトリガーという考え方を気に入っているけど、AWSのワークフローは複雑すぎる。イベントトリガーをデベロッパーのアイデンティティで容易に作れるようになれば、Lambdaをもっと気軽に利用できるだろう。

同社の協同ファウンダーChristian Bachは、こう説明する: “Lambdaが良いことは自明だが、それを軸とするワークフローがないために、使いづらい。われわれにはフロントエンドをパブリシングするワークフローがあるので、サーバーレスもそれと同じようにしたい、と考えた”。

“Lambdaのトリガのひとつひとつが小さなマイクロサービスになり、ブラウザーからそれらにアクセスできる”、と彼は述べる。たとえばStripeを使って決済をする場合なら、Stripeの秘密の認証情報のコードで決済のゲートウェイに入る。“従来なら、この小さな呼び出しのために、どこかでサーバーを動かす必要がある。この小さな機能だけのために、Railsのアプリケーションを作るだろう”、Bachはそう述べる。

しかしNetlifyのやり方では、認証情報を数行のコードでタイプし、それからLambdaのトリガとNetlifyの糊的なコードを少々使うだけだ。これにより、そのコードをどこに置くか、それをどうやって管理するか、という問題が解決する、とBachは言う。

かねてからエッジコンピューティングをテクノロジーの大きな駆動因として見ているLevineがNetlifyのシリーズAをリードし、同社の取締役会に加わったたのは、たぶん偶然ではない。

Levineは曰く、“かなり前からエッジコンピューティングには注目しているし、Netlifyは、エッジにおけるサービスという大きなトレンドの一部だ。同社は、現代的なWebサイトを構築しデプロイする方法を開発した”。

同社は、2015年に創業され、これまでに1410万ドルを調達している。

[原文へ]

(翻訳:iwatani(a.k.a. hiwa)