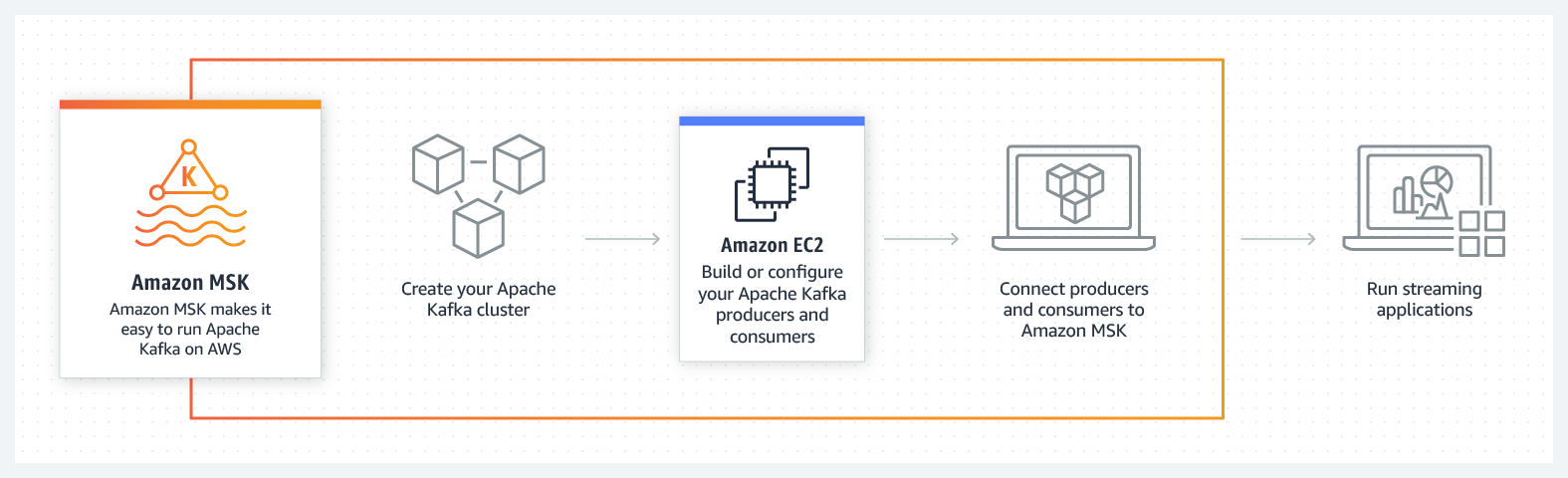

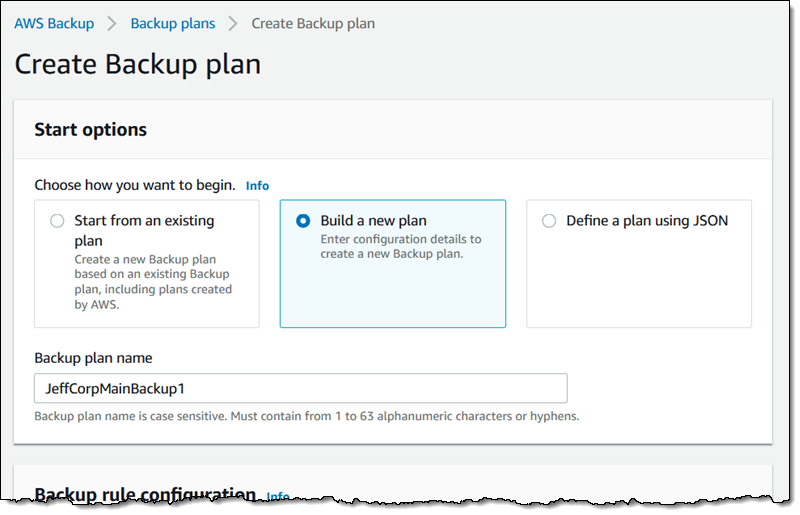

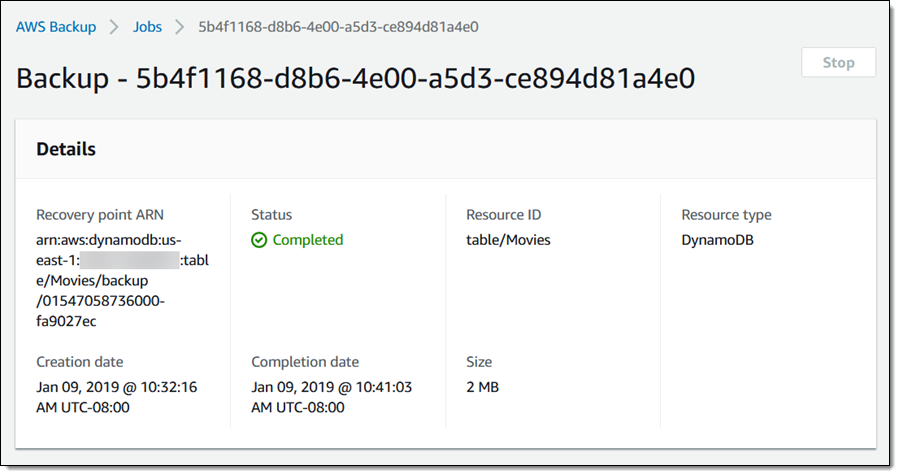

AmazonのクラウドコンピューティングサービスAWSが今日(米国時間1/16)、AWSのサービスからはもちろんオンプレミスのアプリケーションからも容易にデータをバックアップできるツールBackupをローンチした。それは今すでにAWSのユーザーなら誰もが利用でき、最初はバックアップのポリシーをセットアップする。それらはたとえば、Amazon EBSのボリュームやRDSデータベース、DynamoDBのテーブル、EFSファイルシステム、AWS Storage Gatewayのボリュームなどのためのポリシーだ。これら以外のそのほかのサービスも今後サポートされる。オンプレミスのデータをバックアップするためには、AWS Storage Gatewayを使用する。

このサービスによりユーザーは、さまざまなバックアップポリシーやリテンションポリシーを定義できる。たとえば、(EFSなどの)バックアップをコールドストレージに移せるようにするのか、一定の時間後に完全に削除するのか、など。デフォルトでは、データはAmazon S3のバケットに保存される。

サポートされているサービスの多くは、EFSファイルシステムを除き、すでにスナップショットを作る機能がある。基本的にBackupのやることは、その工程の自動化であり、またそのためのルールを設けることだ。というわけでBackupの利用料金は、スナップショット機能の使用料と同じだ(ファイルシステムのバックアップのみGB単位の課金となる)。なお、EFSファイルシステムや、DynamoDBのバックアップからのデータのリストアも、GB単位の課金だ。

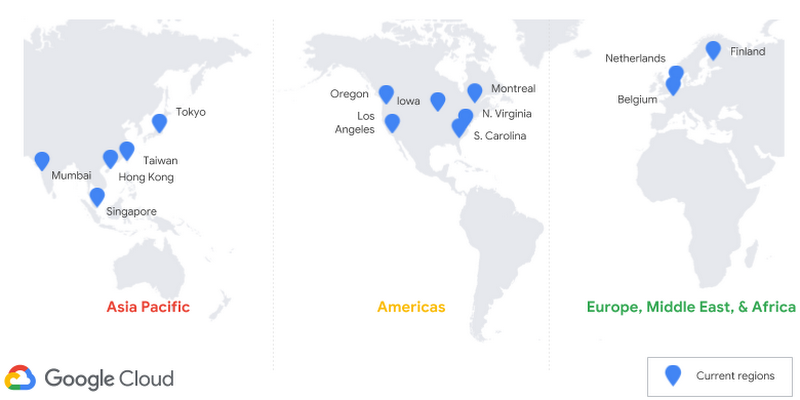

現在、BackupはAWSのひとつのリージョンに限定されているが、同社によると年内には複数のリージョンにまたがるバックアップもできるようにする。

AWSでストレージとオートメーションと管理サービスを担当しているVP Bill Vassはこう言う: “クラウドは今や、どんな規模の企業でもデフォルトだから、二つの異なるタイプのビルダーを惹きつけている。ひとつは“いじくり屋”(tinkerers)で、AWSのサービスの全体をいじくり微調整して求めるアーキテクチャを実現する。もうひとつは、やはりAWSの機能性の幅広さと深さに惹かれるのだが、サービスの粒度の一部を犠牲にして、より高い抽象化層でスタートする。それによりビルドがもっと速くなることすらある。AWSのBackupは、後者のタイプのビルダーが対象であり、かねてから彼らは、個々のサービスごとにバックアップをするのではなく、一箇所でバックアップしたい、という要望を寄せていた”。

AWS BackupのアーリーアドプターはState Street Corporation, Smile Brands, そしてRackspaceだが、アドミンの仕事を楽にしてくれるから、ユーザーはとても多くなるだろう。しかしAWSにはバックアップやストレージ関連のパートナーがかなりいるから、AWSのこの市場への進出を喜ばない人たちもいるはずだ。彼らには、AWSのBackupよりも幅広い機能性(クロスリージョンやオフサイトバックアップなど)があることが多いのだから。

画像クレジット: TechCrunch