馬車が走る道に初めて自動車が登場したとき、馬はその技術の最初の犠牲者となった。ゆっくり走る自動車に襲われたわけではなく、驚いて逃げてしまったわけでもない。むしろ馬は、怪我に悩まされた。また、怯えた馬が通り道にあるものすべてを踏み荒らし、物や歩行者に損害や傷害を与えることもあった。

自動車がもっと速く走れるようになり台数も増えると、歩行者が走る自動車の直接の犠牲者になった。間もなく、交通規則、および製造物責任法と不法行為責任法が作られ、大虐殺を避けるための秩序がもたらされた。それでも、いまだに注意散漫で運転技術が未熟なドライバーは増加する一方であり、彼らが混雑した高速道路を、現実版のまったく笑えない「フロッガー」の舞台に変えている。

自律走行車に乗れば、ドライブのあらゆる恩恵がドライブせずに得られるようになる。自動運転を支持する人たちは、自律走行技術によって自動車はより安全になり、2050年までに事故発生頻度を90パーセント以上削減できると信じている。自動車事故の90パーセント以上が、ドライバーの運転ミスによるものだからだ。

たしかに、飲酒運転や不注意、その他のドライバーの行動に起因する死傷事故のニュースは後を絶たない。自律走行車なら、友だちにメッセージを送ったり、『ブラック・ミラー』を一気見したりしていてもオーケーだ。でも、本当にそうだろうか?それは、目の前に立っている歩行者は実際にはそこにいないと自律走行車が誤認しない限りにおいてのことだ。または、ゴミ収集トラックが引きずっているゴミを車線のラインと見間違えて、車ごとコンクリートブロックに突っ込まない限りにおいてだ。

他社に先んじて、完全な自動運転の実現を目の前にしている企業もあるが、運転環境での極限状況は改善されないままだ。つい最近も、アリゾナの暗い国道を自転車を押して渡ろうとしていた女性が自律走行車に跳ねられるという悲惨な事故があったばかりだ。車にはドライバーが乗っていて、事故にならないよう対処できたはずなのに、それをしなかった。積極的に奨励しないまでも、ドライバーが運転を手放せるようにすることが自律運転技術の本来の意義であるため、その車に乗っていた人の不注意を責めることはできない。

ほとんど必要とされないためドライバーが運転できなくなってしまうから「自律走行車のパラドックス」は危険だ。少なくとも当面の間、自律走行システムの信頼度が人間のドライバーとほぼ同じ98パーセントの安全率を上回るようになるまでは、緊急時や予想外の状況での人間のドライバーの補完を必要とするだろう。

この移行時期の間、そしてこの時期を過ぎてからも、事故の際に何が起きるのか、また誰がその責任を取るのか?自律運転技術が現れる前は、自動車事故は、ドライバーの過失とメーカーの製造者責任という2つ法理論のうちのいずれかが適用された。過失の法理論は、ドライバーの行動に責任を負わせ、ドライバーから、一般的には保険会社からだが、ハンドルを握っていた本人の行動に対する金銭的賠償を引き出そうとするものだ。製造者責任の法理論はその反対で、怪我の原因になったエアーバッグやイグニションスイッチやタイヤや、さらには自動車そのものなど、欠陥のある製品を製造し販売した企業に向けられるものだ。自律走行車の事故に現在の法理論を適用しようとすれば、数多くの問題が発生する。

人工知能(AI)、あるいは自動車を自律走行させるものなら何でも構わないのだが、それがカーブの路面が滑りやすくなっていることを検知または、それに応じて運転を補正できなかったとする。前を走る車から漏れた不凍液が路面を濡らしたようで、ハンドルを握る人間には認知できたものの、AIシステムにはほとんど見えなかった。もし、自律走行車に手動運転が優先される機能があり、それで事故が起きたなら、衝突を防ぐ操作をしなかったドライバーの責任が問われるのか?道路状況を検知したり、それに対処しなかった自動車のメーカーが責任を問われるのか?両方だとしたら、責任の割合はどうすべきか?

もし、通常の自動車だった場合、ドライバーに対する訴訟は、その人の行動が適切な注意義務基準に達していなかったことを証明できるかどうかにかかってくる。ハンドルから手を放していたなら、通常の自動車では過失行動とされることが多い。スマートフォンでメッセージを送っていて注意散漫になっていた場合もおそらく同じだ。しかし、自律走行車の自動運転機能は、本来の性質上、ドライバーが運転に注意を払わなくても、また運転に関わる必要性をなくすためのものだ。となれば、上記のような状況で、私たちは運転を引き継がなかったドライバーの責任を追及できるのだろうか?

従来型の自動車のメーカーも、法的責任はシステムや部品に欠陥がなかったかにかかってくる。状態のいい従来型の自動車で、サスペンションにもブレーキにもハンドルにも欠陥がなければ、上記のシナリオでも、メーカーが責任を問われることはまずないだろう。一方、人間の運転が優先される自律走行車のメーカーは、少なくとも責任の一部をドライバーに負わせようと試みる知れないが、そんなことを社会が許すだろうか?許すべきだろうか?ドライバーは、合理的な範囲で自律走行者に依存していたと主張するだろう。しかし、ドライバーの目には危険が目に見えていて、事故を防ぐための介入ができにも関わらず、メーカーが責任を負うべきなのだろうか?

その車が完全に自動化されていて、人間の介入が不可能であった場合は、結果は違ってくる。しかし、そんな車が現れるのは何年も先のことだ。

そうした自律走行者が市場に登場したとき、予期せず遭遇した滑りやすい路面を検知またはそれに対する補正に失敗したときは「欠陥車」とされるのか?または「欠陥車」と見なすべきなのか?もしそうなら、単に故障が発生したから欠陥車とされるのか、それとも、AIソフトウエアにエラーがあることを誰かが証明して見せなければならないのか?AIアルゴリズムは自身で進化することができ、膨大な距離と時間を費やして得たトレーニングデータに依存していることを考えると、どうしたらソフトウエアの中の「欠陥」を証明できるのだろうか?事故を起こした時点のアルゴリズムがオリジナルから大きくかけ離れていた場合、そしてその変化がAIアルゴリズムが自分で「教育」した結果であった場合、そのプログラマーやソフトウエアの提供業者に責任を負わせることが公正なのだろうか?

もうひとつの問題は「集団意識」だ。AIが学習する方法のひとつに、接続された他の複数のAIの集団的な体験を利用するものがある。これは、一時期Teslaが使用していた方法だ。もし、他のAIの誤ったデータがアップロードされ、それが事故に大きく関わっていたとしたら、どうだろう?

こうした問題の観点からすると、そして技術がますます人間の関与を減らす方向で発達すれば製造者責任の法理論を強化するよう法律も変化することになるだろう。おそらく、製造者責任は過失よりも厳しくなる。将来の自律走行車の価格が、研究開発と部品のコストだけでなく、事故のコストをカバーする「保険」を含めて決められるようになるとしても、突飛な話ではない。こうした進化は、人間のドライバーの役割が減るのに合わせて起こっていくだろう。しかし、自動車メーカーのAIシステムの学習プロセスを完全にコントロールする能力や、ましてや運転環境が同時に進化することはないだろう。

少なくとも、ある程度の人間の介在を必要とする移行期においては、責任に関する自動車メーカーの意見は分かれる。ボルボなどの一部のメーカーは、自動運転モードの最中に発生した事故に関しては全責任を負うと宣言している。しかし、テスラを始めとする他のメーカーは、ドライバーが若干の関与を要求される状況で発生した事故においては、たとえ自動運転モードであっても、ドライバーに責任を負わせようとしている。

例えば、かつてテスラでは、自律走行モードで他の車を追い越す機能を有効にするには、方向指示器を点灯させなければならなかった(テスラの新型車ではこの操作が不要になった)。ドライバーにこの操作を行わせる仕組みは、一見、大したことではないように感じられるが、そこには自動車メーカーが法的責任をドライバーに転嫁する意図がある。簡単な操作だが、車に追い越しを指示するだけでなく、その追い越しは安全に行えるという自らの判断によるものであり、その結果の如何に関わらず責任を負う、または負わなければいけないと、ドライバーに示唆するものでもある。

その基礎となる技術は、責任の所在を追求しようとすれば、さらなる複雑性を突きつけてくる。これまで暗に示してきたように、「機械学習」として特徴付けられるAIの側面は、無数の多様な入力データをもとに開発されていて、その振る舞いは多かれ少なかれ「ブラックボックス」化されている。厳格な数学的アルゴリズムと思われるため、本当に理解することは難しい。

言い換えるなら、私たちには、機械がどのように判断をしてその行動をとったのかを正確に知る手立てがないのかも知れないということだ。その場合、AIボックスが間違ったトレーニングを受けた、または現実の運転ではなくシミュレーター上で「訓練」されていたとしたら、AIボックスが極限的状況での対処を誤って事故につながった責任は、シミュレーターの開発者に負わされることにならないか?

AIのプログラミングやトレーニングの倫理の問題はどうだろう。最近の研究で、歩行者が有色人種だった場合、現在のAIシステムが彼らを認識できる能力は20パーセント低下することがわかった。これは、AIのトレーニングが多様性を踏まえていなかったためだ。他に説明があるだろうか?MITによる最近の調査では、衝突が避けられない極限状況において人の命を犠牲にするかどうかではなく、どの人の命を犠牲にするかの選択を迫られたとき、人は救うべき命をその上下関係で決めていることがわかった。この調査に参加した人たちは、動物よりも人の命を優先させるべきだと話している。少数の命よりも、大勢の命を救うべきであり、老人を犠牲にして若者を救うべきだと考えている。

興味深いことに、ベビーカーを押して交通法規を守って歩いている人を尊重するべきだとも考えられている。結論として、こうした倫理感に基づいて自律走行車がプログラムされた場合、交通の激しい道路をひとりで乱横断している人は自律走行者に跳ねられる確率が格段に高くなるということだ。この調査の道徳的序列では、猫、犬、犯罪者が保護対象としての最下層に位置する。だが、その人が犯罪者かそうでないかを車が判断できるのだろうか?刑務所の情報をリアルタイムで入手するのか?また、動物愛護活動家のハッカーが車のプログラムを、人より動物を尊重するように書き換えてしまったらどうなるのだろう?

MITのこの調査が信頼できるとすれば、こうした序列の意識や変動性が現に存在していることになる。それは、人間の潜在意識にしまい込まれているだけだ。機械の中ではない。次に道路を渡るとき、このことを考えてみてほしい。

【編集部注】

著者のLucas Dahlinは、Goodwin知的財産グループのアソシエート。複雑な知的財産問題を専門に取り扱い、特許と企業秘密に関する訴訟に豊富な経験を持つ。

Julius Jeffersonは、Goodwin知的財産訴訟グループのアソシエート。Goodwinに加わる以前は、デラウェア地区とテキサス西地区で判事の書記を務めていた。ロースクールに入学する以前は、Wyeth Pharmaceuticals(現Pfizer)の研究フェローとしてアルツハイマー病の治療法を研究していた。

Darryl M. Wooは、Goodwin知的財産訴訟グループの共同経営者。以前は法廷弁護士として特許訴訟やその他の複雑な技術関係の訴訟を専門に扱っていた。

[原文へ]

(翻訳:金井哲夫)

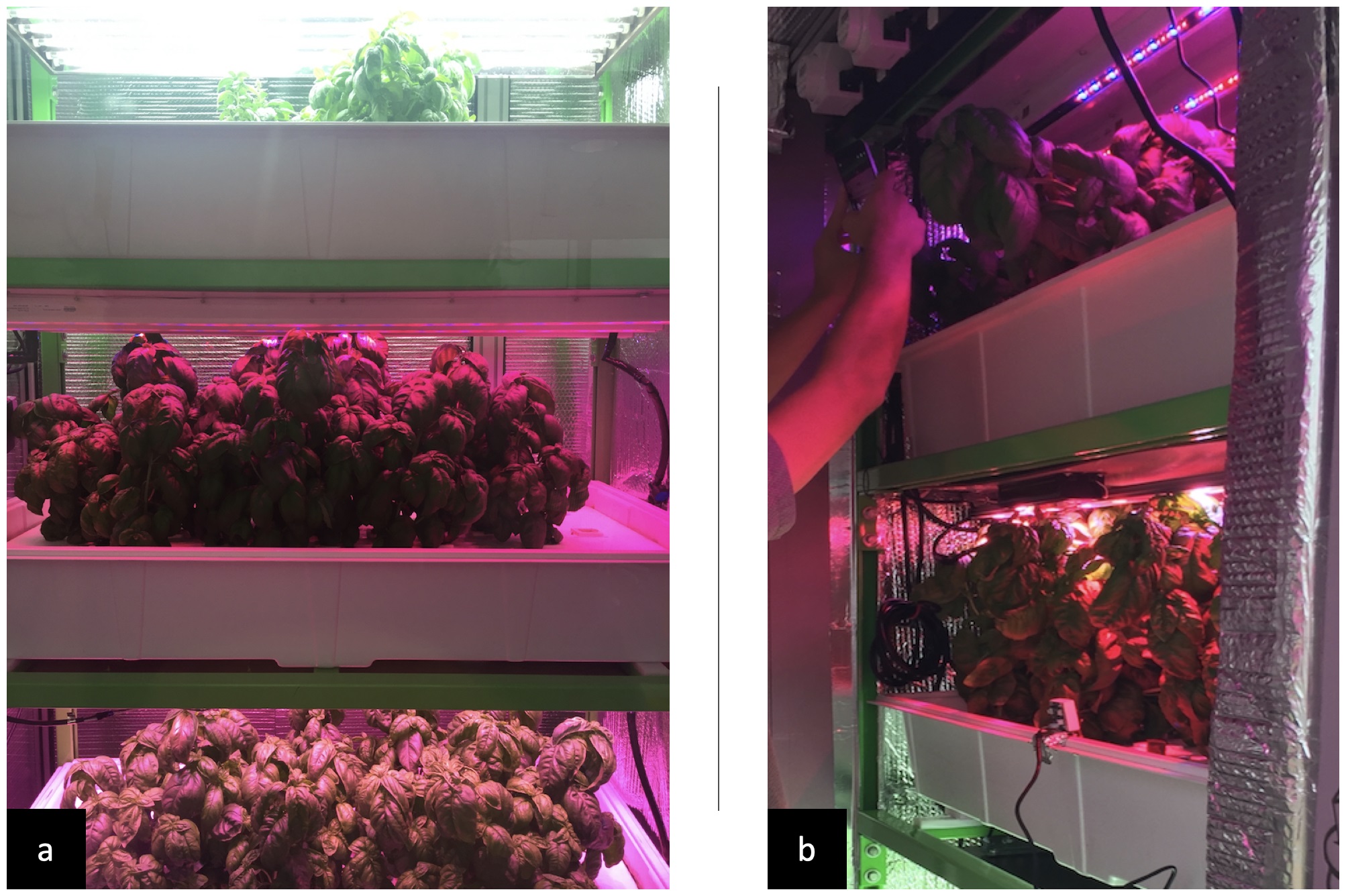

最初の9株の植物は、バジルが一般的に好むと思われる従来の知識を用いた手作業の露光計画に従って栽培が行われた。栽培された植物は収穫・分析された。次に単純なモデルを使用して、最初のラウンドの結果を考慮に入れ、類似はしているもののわずかに調整された露光計画が作成された。そして3回目にはデータからより洗練されたモデルが作成され、環境への変更を推奨する追加の機能も与えられた。

最初の9株の植物は、バジルが一般的に好むと思われる従来の知識を用いた手作業の露光計画に従って栽培が行われた。栽培された植物は収穫・分析された。次に単純なモデルを使用して、最初のラウンドの結果を考慮に入れ、類似はしているもののわずかに調整された露光計画が作成された。そして3回目にはデータからより洗練されたモデルが作成され、環境への変更を推奨する追加の機能も与えられた。