Alexaは近く過去に質問されたことを覚えているようになる。会話も自然になり、コマンドも常にAlexa!と始める必要はなくなるという。また必要とされるスキルを判断し、明示的に命令されなくても自動的にそのスキルを発見し起動する。Amazonではこれを手はじめに、年内に繰り返しAlexaの機能強化を行っていくという。Amazonのスマート・アシスタントはいっそうスマートになり、それぞれのユーザーのニーズにフィットし、さらに役立つようになる。

フランスのリヨンで開催されているWorld Wide Web Conferenceで今朝(米国時間4/26)のキーノートで 、Alexa Brainグループの責任者、Ruhi Sarikayaがこのニュースを発表した。

Sarikayaによれば、Alexa Brainグループの目的はAlexaがユーザーとの会話のコンテキストを認識し、記憶できるようするところにある。またすでに4万種類にも上るサードパーティー製のスキルから目的に応じて適切なものを発見し使用できるようにする。こうした改善によりユーザーはAlexaをさらに容易かつ効果的に利用することができるようになる。

当面アメリカのユーザー向けに公開される予定の記憶力の改良ではAlexaは質問された内容をすべて記憶し、必要に応じて後で利用できるようになる。

たとえば「Alexa、ショーンの誕生日は6月20日だということを覚えて」 と命じるとAlexaは「オーケー、ショーンの誕生日は6月20日です」などと答えるはずだ。ユーザーは重要な情報を覚えるという仕事をAlexaに肩代わりさせることができる。

物事を記憶できることはGoogle Assistantでもいちばん役立つ能力だ。そこでAlexaとしてはもどうしてもこの面で追いつく必要があった。

また近くAlexaはいっそう自然に会話できるようになる。Alexaが会話のコンテキストを記憶するコンテキスト・キャリーオーバーと呼ぶ能力を備えると、質問ないしコマンドに続くフォローアップのコマンド、質問をいちいちAlexa!という呼びかけで始めなくてもよくなる。

たとば、「Alexa、シアトルの天気を教えて」と命じてAlexaが答えた直後に「今週の週末は?」と尋ねるとAlexaはそれを理解する。

さらに質問のトピックを変えることもできる。「Alexa、ポートランドの天気を教えて」と命じた後、「そこまでどのくらい時間がかかる?」と尋ねることができる。

Sarikayaによれば、こうした能力は自然言語処理に高度な深層学習モデルを適用したもので、会話内容とそのコンテキストを「ドメインを超えて」維持でする。例のように「天気」と「交通」という異なるドメインの間でもユーザーの意図を一貫して把握できるわけだ。この能力を利用するためにはユーザーはフォローアップ・モードを有効にする必要がある。これによりデバイスは「Alexa!」という起動キーワードなしでも反応できるようになる。

この自然な会話能力がAlexaにやってくるのはアメリカ、イギリス、ドイツが最初となる。ただし「近く」とだけで正確な期日は明らかにされていない。

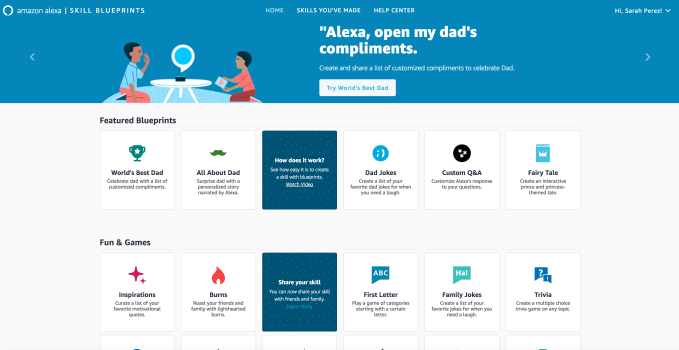

Alexaに近く導入されるアップデートにはスキルの自動起動がある。Alexaの能力を拡大するために多数のサードパーティー製の音声アプリが開発されている。クレジットカードのアカウント情報を参照する、ラジオでニュースを聞く、Uberに配車を依頼する、ゲームをプレイする等々だ。しかしAlexa Skillsストアには登録されたアプリの数が非常に多くなっているためユーザーが必要なスキルを発見するのが難しくなっている。

これに対応して、向こう数週間以内に、アメリカのユーザーは「Alexa、 [スキル名]をオープン」のように明示的に名称を指定しなくても必要なスキルを起動できるようになる。

AmazonではAlexaのスキルを容易に使用できるようにしようと年来努力を続けてきた。2016年にEchoから音声でAlexaのスキルを起動できるようにアップデートされた。昨年はある種の質問に限定されるものの、Alexaは対応するスキルを推薦できるようになった。今回リリースが予定されている新機能ではAlexaが自ら適切なスキルを探し出し、起動することができる。現在ベータ版がテストされている。

SarikayaはプレゼンでAlexaにシャツについた油のしみ抜き方法を訪ねた例を挙げている。

これに対してAlexaは「Tideという染み抜き製品があります」と答えた。これはProcter & Gambleが開発したスキルによるもので200種類以上の染みに対してそれぞれ対処方法を教える。

これまではユーザーが自分でTideのしみ抜きスキルを探して出してローンチするということは考えにくかった。しかしAlexaが「しみ抜き」というキーワードを理解してTideを発見、起動してくれることになれば利用の可能性ははるかにアップするだろう。

この能力はAmazonに新たな広告モデルを提供する可能性がある。 Googleにキーノート入札による広告システムのようにAlexaのキーワードを競争入札方式で販売することになるかもしれない。もしAlexaに対する質問に対するスキルの答えが特定のブランドやプロダクトを推薦する場合、有力な広告手段となる(もちろんフォローアップ・モードが有効な場合、「他には?」という質問で別の製品が推薦されるかもしれない)。

この新機能についてもローンチ期日は「近々」としか分からない。しかしSarikayaによれば、これらの新機能もAlaxaの強化の第一歩だという。【略】

「スキル発見、コンテキスト・キャリーオーバー、質問の記憶など、今回予定されている3つのアップデートはAmazonの技術陣によるAlexa改良のごく一部だ。われわれはAlexaをフリクションフリーで使えるようよう研究を重ねている。これは人間とコンピューターのインターフェイスを根本的に変革する何年もかかる道のりの一環だ。Amazonはまだ最初の一歩を踏み出したに過ぎない」とSarikayaは述べた。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)