現在のロボットの能力は驚異的レベルに達しているが、特定の分野を除いて活用は進んでいない。ここではロボットの物理的柔軟性ではなく、人間の頭の柔軟性が何より求められるところだ。この記事では新たな能力を獲得した3種類のロボット・テクノロジーを紹介する。最初のロボットは複雑、微妙な作業ができる手を備える。2番目は倒れても自力で起き上がれる。3番目は過去に一度も見たことがない視覚的指示に基づいて行動できる。

これらのロボットは別々の組織で独立に開発されたものだが、今日(米国時間1/16)、 Science誌のロボティクス特集号で一堂に会して紹介されている。テクノロジーとして興味深いだけでなく、それぞれにロボットが現実世界で活躍できる場面を拡大するものと思う。

マジック・ハンド…

それぞれの仕事にはそれに適したツールを使う必要がある。人間の腕の端には非常に万能性が高いツールが付属している。われわれは対象を指先でそっとつついたり、柔らかく持ち上げたりできる。この能力があるのでわれわれは対象の重さや硬さを知り、卵を割ったり、他の道具を使ったりできる。

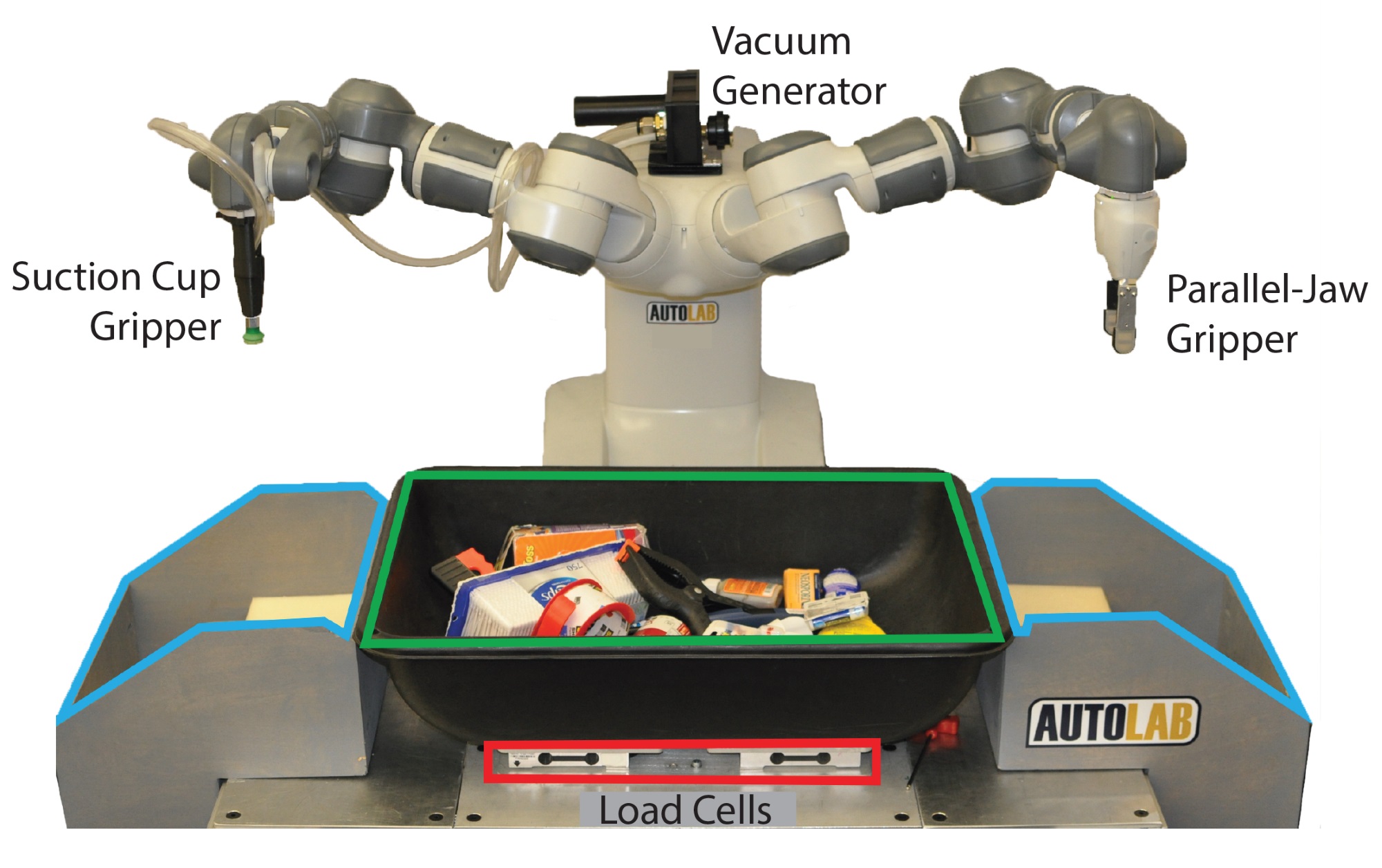

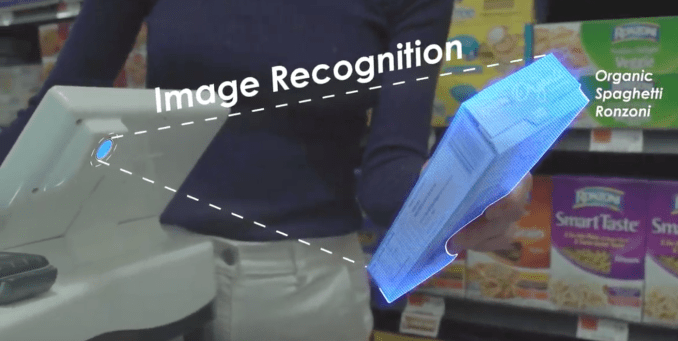

これまでのロボットの「手」にはこうしたことができる能力がなく、これがロボットの応用範囲を狭める大きな原因となってきた。カリフォルニア大学バークレー校で開発されたロボットはピンセット式に加えて真空吸引式で対象をつかむことができる手を備える。これによって対象の性質を認識し分類することが可能になる。

この両方の能力を備えたロボットは、ニューラルネットワークによりその場の試行錯誤でどちらか適した方式を選択できる(位置認識には3D画像認識が用いられている)。これによりロボットはこれまでに見たことがない対象に対しても適切に対処できる。.

下のGIFではロボットはぬいぐるみを吸引カップでつかもうとして失敗すると即座にピンセット式に切り替えてつまみ上げることに成功している。このシステムはロボットの対象物のハンドリング能力を飛躍的に拡大する。さまざまなアイテムが混在する倉庫でロボットと作動させる場合などを考えれば重要性がわかるだろう。

バークレー校でロボティクスを教えるKen Goldberg教授は、取材に対して「ニューラルネットワークにはブラックボックス的部分が残るため、Dex-Net 4.0ロボットがどのような基準で手を使い分けるのか完全に知ることはできない。しかし一定の傾向は認められる」とメールで答えている。

倒れても起き上がれるANYmal

すでに4脚ロボットはあらゆる地表条件で安定して歩行できる能力を備えている。しかもつまづいても(意地悪な人間に蹴られた場合でさえ)態勢を立て直すことができる。しかしひどく倒れた場合は起き上がることができなかった。

これはロボットの脚が直立した状態に適したメカニズムになっているためだ。しかしわれれわれも紹介したANYmalはスイスのチューリヒ工科大学(ETH Zurich)で開発されたロボットでさらに高い柔軟性を備えている(Continentalは宅配サービスへの利用を考えている)

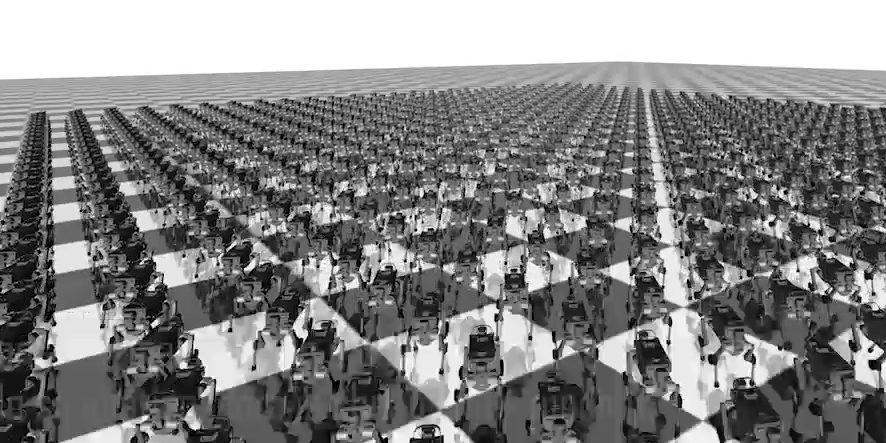

もちろんロボットの柔軟性が高くなればもっとも適したユースケースを決めるはそれだけ難しくなる。そこでどんな応用が効果があるかを決定するシミュレーション・システムを使う方法が提案されている。

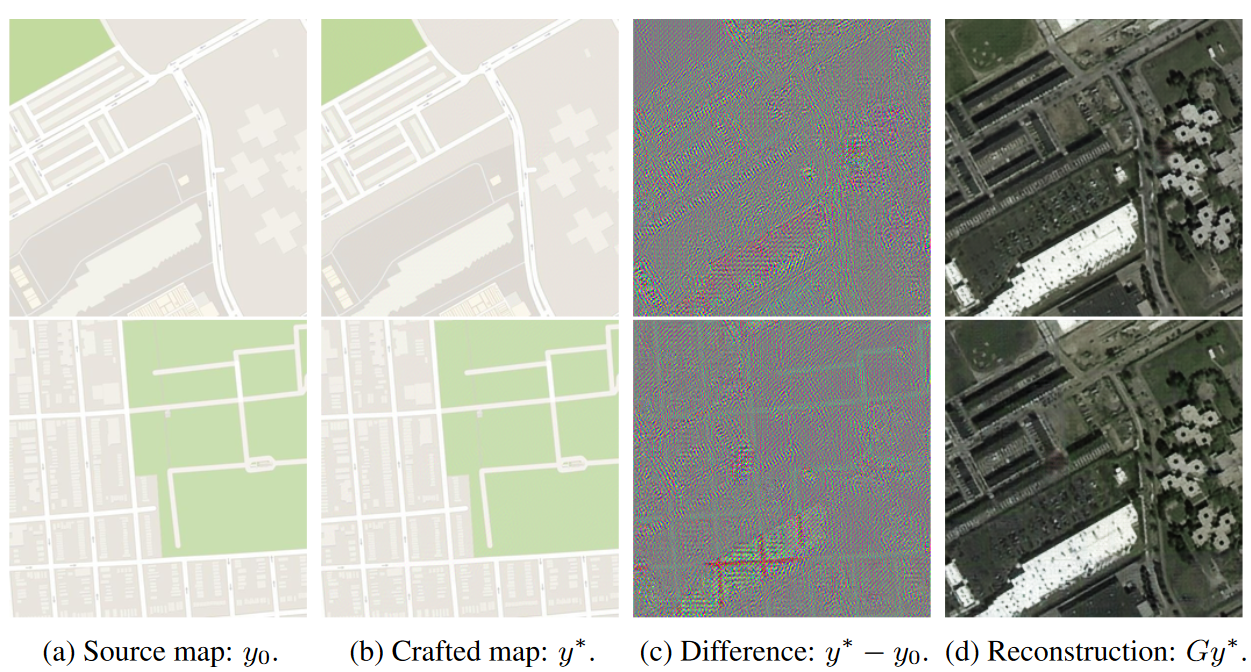

もちろんすべての状況をシミュレーションすることはできない。現在ある種の対象はシミュレーター内で正確に再現することが困難だ。しかしシミュレーターを使うことで今まで考えられなかった新しい適用分野が発見されることもあるし、効率化が大きく進むこともある。たとえば下の画像を見てみよう。

どんな倒れ方をした場合でも脚を自由に動かせる空間がありさえすればANYmalは同じ方法を用いて難なく立ち上がる。しかしこれは最初からこのようにアルゴリズムを組んだ結果ではない。シミュレーションを無数に繰り返し、そのつどアルゴリズムにフィードバックさせていくうちにこのような洗練された動作ができるようになったのだという。

イケアの家具を組立てられるようになる…?

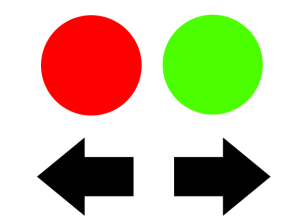

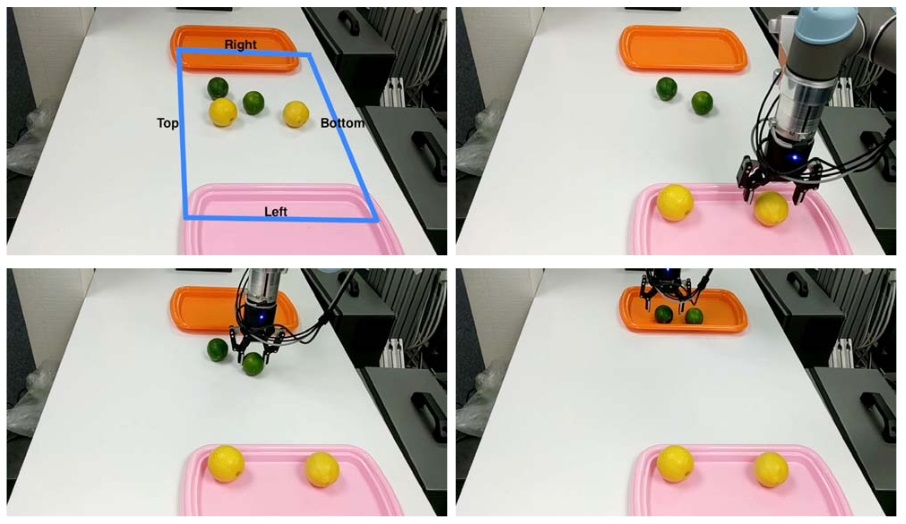

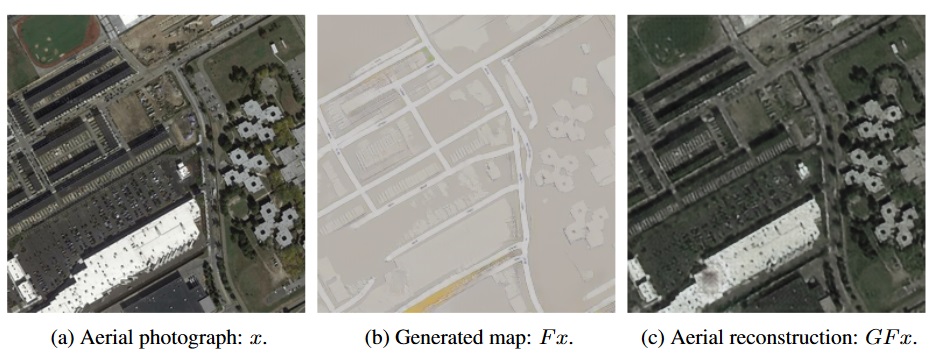

眼の前に3つのトレイが置かれているところを想像してみよう。左右のトレイは空だが中央のトレイには赤いボールと緑のボールがいくつか並べられている。そこで下の図のような紙を渡されたとしよう。

普通の知性を備えた人間ならこの紙を操作の指示として解釈を試みるだろう。赤丸の下に左向き矢印、緑の丸の下に右向き矢印がある。では赤いボールは左のトレイに、緑のボールは右のトレイに移せばよいと考えるのが普通だ。

われわれは普段何気なくこうした結論に達している。しかしこの種の直感的解釈には膨大な情報処理が行われている。紙に印刷された赤い丸が現実空間の赤いボールを意味しているとどうやったら判断できるのか? 形の類似だろうか? 矢印についてはだろうだろう? どうやって矢の向きを判断しているのか、またその向きがボールを移動するときの方向だと分かるのはなぜだろう? そもそも渡された紙が作業指示書だと判断できる理由は? 疑問は無数に出てくる。ロボットに初めて見る指示書を見せて動作を行わせるのがいかに困難か想像がつくと思う。

Vicarious AIのMiguel Lázaro-Gredilla のチームは「赤い丸、緑の丸」のようなできるだけ単純化した例を用いて、抽象的な指示でロボットを正しく作動させる研究に取り組んでいる。

もちろん実験はまだ初歩的な段階だ。しかしロボットに直感や常識をもたせることが可能であれば、やがて製品に付属する指示書を解読してイケアの家具を組み立てることだってできるはずだ。その段階に到達するまでにはまだかなりの期間が必要らしいが、それを言うならロボットが倒れたら最後起き上がれなかったのはそんなに昔のことではない。もちろん当時はロボットが対象物をつかむのに真空カップを使うかピンセットを使うかその場で判断することもできなかった。

ここで紹介したロボットのコンセプトやデモの詳細についてはScience Roboticsサイトで知ることができる。

〔原文へ〕