本日(現地時間8/23)WalmartとGoogleは、音声アシスタント「Google Assistant」を通じた音声ショッピングに関するパートナーシップを結んだと発表した。今後消費者は、WalmartのEasy ReorderサービスとGoogle Express(Googleの宅配サービス)を併用し、何十万種類もの商品をスマートスピーカーに話しかけるだけで購入できるようになる。

さらにこのパートナーシップを受け、GoogleはGoogle Expressの会費を廃止し、サイトに登録されている各小売店の最低購入金額さえ満たせば、商品を1〜3日間で無料配送すると決めた。

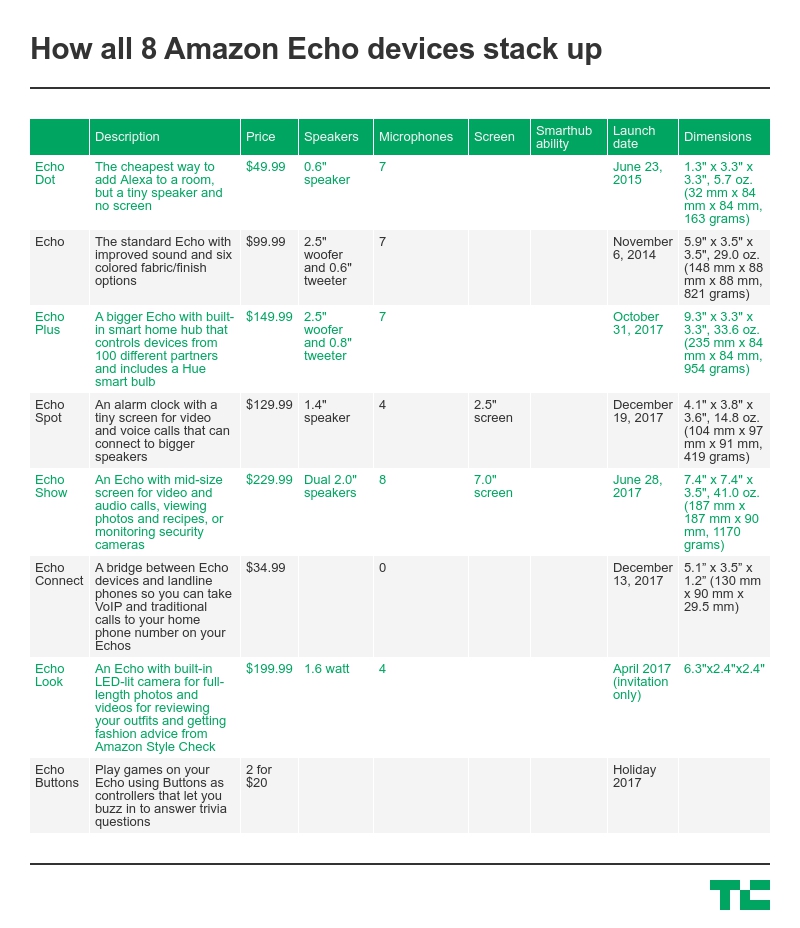

これまでは月額10ドル(年額95ドル)の会費が設定されていたGoogle Expressにとって、これはかなり大きな変化だ。現在のところ同サービスでは、TargetやCostco、Kohl’s、Bed Bath & Beyond、PetSmart、Staples、Toys R Us、Walgreensなど大手小売店から、ファッション、家庭用品、ハードウェア、パーソナル・ヘルスケア用品、スポーツ用品、化粧品といった幅広いカテゴリーの商品を購入できる。

しかしGoogleは、会費のせいでGoogle Expressのユーザー数が伸び悩んでおり、特に音声ショッピング普及の障害になっていると考えたのだ。

「メンバーシップ制がだんだんとサービスの障害になってきていた」とGoogle Express担当GMのBrian Elliottは語る。「モバイルユーザーに対して、4.99ドルの配送料を支払うかメンバーになるかというオプションを説明するのは簡単だが、それでもユーザーにはいくばくかの負担がかかってしまう。しかし、さらにそれを音声だけで伝えるとなると、かなり難しいということがわかった」

なおGoogle Expressの利用者数や、同サービスを通じた売上額について、Googleはコメントを控えている。

これまでWalmartはGoogle Expressには参加せず、自分たちでオンラインの注文を処理していた。今年に入ってからは、(Amazon Primeとは違い)35ドル以上の商品を購入した全顧客に対して、無料の2日間配送さえ行っていた。

しかしGooge Assistantとの連携で、Walmartは音声操作という自社にはないテクノロジーを利用できるようになった。

音声ショピングこそが小売業界の未来だと考える専門家もいる。例えばRBC Capital Marketsは、音声ショッピングからの売上やプラットフォーム収益によって、Alexaは2020年までに100億ドルもの収益をもたらすことになるだろうと予測している。

もしもそうだとすれば、Walmartもその波に乗らないわけにはいかない。

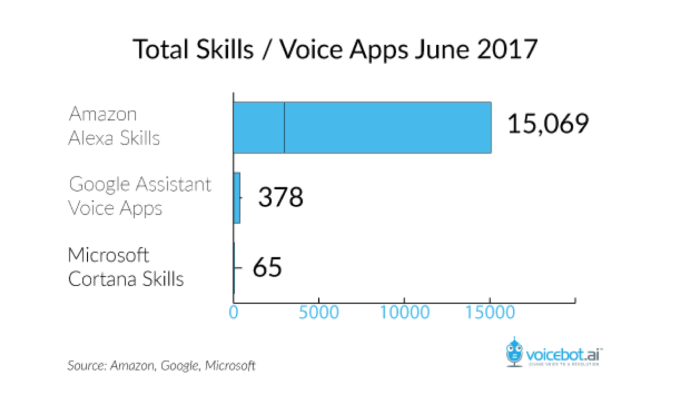

そしてスマートスピーカーの分野でAmazonと肩を並べる主要プレイヤーといえば、Googleしかいないのだ(AppleのHomePodはまだ出荷が始まっておらず、サードパーティーアプリのサポートに関する計画も発表されていない。またMicrosfotのCortanaを搭載したスピーカーも有力な対抗馬とは言えない)。

WalmartでEC部門のトップを務めるMarc Loreは、「(音声ショッピングは)未だ黎明期にある。しかし過去2年間でAI技術が発達し、今後の方向性が見え始めてきた」と音声ショッピングの野望について語った。

「将来的には音声認識テクノロジーの精度が桁違いに向上し、消費者のニーズを理解してそれに応えられるようにさえなるだろう。これによりショッピング・エクスペリエンスは大きな変化を遂げることになる」と彼は付け加えた。

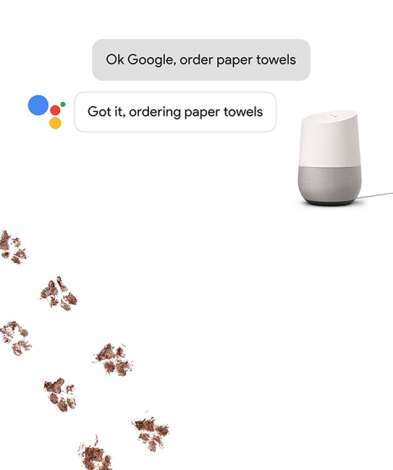

Google ExpressとGoogle Homeの連携は今年の2月から既にスタートしており、Walmart以外の小売店も音声ショッピングに対応している。

Google ExpressとGoogle Homeの連携は今年の2月から既にスタートしており、Walmart以外の小売店も音声ショッピングに対応している。

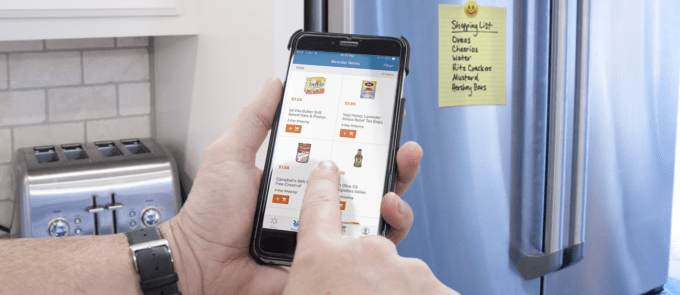

しかしEasy Reorderサービスのおかげで、Walmartでは他社よりも簡単に音声ショッピングを楽しめるようになっている。というのも、Easy Reorderはオンライン・オフライン両方の購入履歴をベースに、個々の利用者の好みを理解しているのだ。例えば、いつも使っているブランドや商品のサイズ、さらには直近の購入日や頻度までEasy Reorderには記録されている。

そのため、実際に商品を注文するときは、「OK、Google」からスタートし、「ピーナッツバターを注文して」や「ピーナッツバターを再度購入」「ピーナッツバターを買って」「Walmartからピーナッツバターを買って」といった感じでGoogle Homeに話しかけるだけで済む。

購入しようとしている商品が35ドル(無料配送のための最低金額)以上であれば、2日以内の配送を希望するかどうか聞かれ、35ドル未満であればWalmartのカートにその商品が自動的に追加される(カートへはGoogle HomeとGoogle Expressのアプリからアクセス可能)。そしてカート内の商品の合計額が35ドルを超えた時点で支払いを促されるという仕組みだ。

まずはEasy Reorderにフォーカスしたサービスが提供される予定だが、音声ショッピングの分野で今後Googleとさらに協力関係を深めていこうとしているWalmartは、Googleとのパートナーシップという側面を強調している。

来年からは生鮮食品の音声注文も受け付ける予定で、ユーザーは予め袋詰された商品を実店舗で受け取ったり、家まで配達してもらったりできるようになる(受け取りオプションはユーザーの居住地域によって異なる)とのこと。さらに、顧客の好みや購買習慣に関するデータが集まるにつれて、システムがさらにスマート化していく可能性もあるとWalmartのLoreは言う。

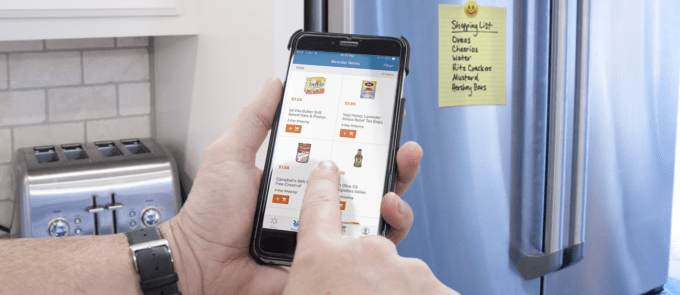

Walmartのモバイルアプリ内にあるEasy Reorderの画面

「音声サービスが普及するにつれて、更なるパーソナライゼーションが要求されるようになり、結果的に各消費者の求めるものがそのままオススメ商品として表示されるようになるだろう」と彼は話す。「まだまだ実現には時間がかかるが、その可能性には大いに期待している」

Google ExpressおよびGoogle HomeとWalmartの連携は9月末からスタート予定だ。

まずはGoogle Homeだけが対象になるが、Elliottはその他のGoogle Assistant搭載デバイスも順次Walmartでの買い物に使えるようになると語った。

しかし、スマートスピーカー市場におけるAmazon優位の現状を考慮すると、WalmartはAlexaとも連携しないと、かなり大きなのチャンスを逃すことになりそうだ。ある予測によれば、今年中にはAmazonがスマートスピーカー市場の70%を占め、2020年までに1億2800万台ものAlexaデバイスが稼働することになるとさえ言われている。

そこでLoreに、WalmartがAlexaとも連携する可能性があるか尋ねたところ、彼はただ「No」とだけ答えた。

[原文へ]

(翻訳:Atsushi Yukutake)