サーバーレス・コンピューティングというのは特に新しいコンセプトというわけではない。しかしテクノロジーの進歩によって興味ある地位を占めるまでに成長してきた。デベロッパーはサーバーレス・アーキテクチャの価値を認めるようになり、全く新しいスタートアップ・エコシステムが構築される可能性が出てきた。

もちろんサーバーレスといってもどこかにサーバーは存在する。しかしデベロッパーはイベントのトリガーをセットするだけでインフラに関してはすべてクラウド任せにできる。クラウドのベンダーはコンピューティングパワー、ストレージ、メモリー等々をデベロッパーが必要とするまさにその量だけ提供する。デベロッパーはインフラについて考える(あるいはそのためにコーディングする)必要がない。

なるほどこれは理想的な環境に思える。しかしあらゆる新しいテクノロジーに言えることだが、何かが解決されればその裏側で新しい課題が生じている。そしてこの新しい課題こそ野心的な起業家に道を開く。今後数年の間にサーバーレス・コンピューティングを助け、セキュリティーを確保するために必要なツール、ライブラリ、API、ダッシュボード、その他あらゆるユーティリティーの作成が大きなビジネスチャンスとなるはずだ。

抽象化のレイヤーを構築する

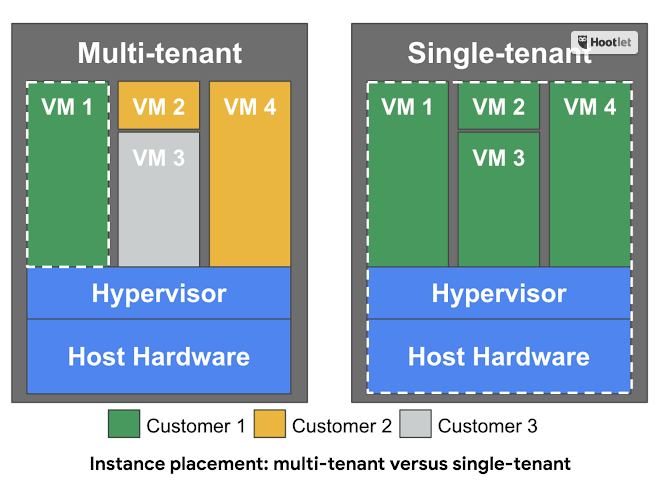

当初われわれはサーバーを物理的にまるごと所有していた。しかしこれは非常に能力の無駄が多かった。そこでバーチャルマシンが開発され、物理的には単一のサーバーが複数のバーチャルマシンに分割された。これは当時として驚くべきブレークスルーであり、VMware始め数多くのスタートアップが生まれた。またこのテクノロジーがクラウド・コンピューティングを可能にした。しかしこれはほんの手始めに過ぎなかった。

続いてコンテナが登場し、DockerとKubernetesという2つのオープンソース・プラットフォームによって大きな意味を持つ存在となった。 デベロッパーは一枚岩的な巨大システムを多数の独立した部分に分割して作動させることが可能になり、コンピューティングの効率が大きくアップした。そしてさらに最近ではサーバーレス、イベント・ドリブンなどと呼ばれるコンピューティングのパラダイムが登場した。これはインフラを抽象化し、ひとつのレイヤーとするコンセプトだ。

写真: shutterjack/Getty Images

プログラムを実行するためにはどこかにCPU、メモリー、ストレージが存在しなければならないのだから物理的にいえば「サーバーレス」ではない。しかしサーバーレス・コンピューティングはデベロッパーがサーバーを使うための手間を省く。現在大きなプログラムを動かそうとすれば、それを動かそうとするコンピューター(バーチャルマシンであれ物理的マシンであれ)とプログラムの各部分とを適切に結びつけるために膨大なコーディングが必要だ。サーバーレスの場合ならこれをクラウドのベンダーがすべて肩代わりしてくれる。

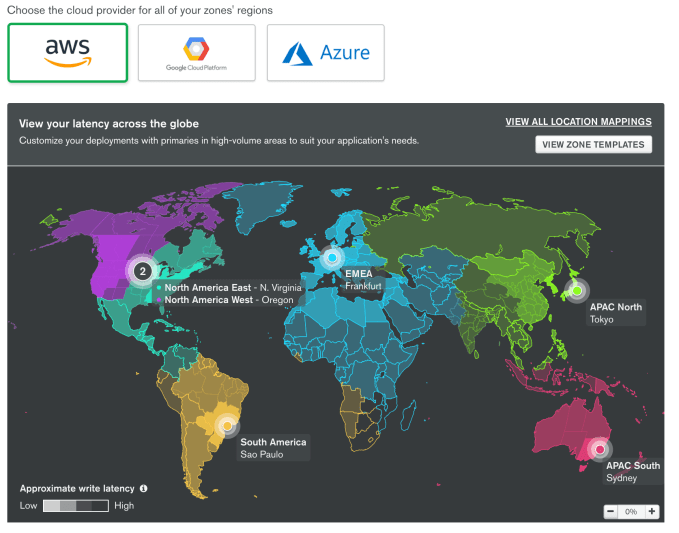

主要なクラウド・ベンダーはそれぞれサーバーレス・プロダクトを提供している。、AWS Lambda、Google Cloud Functions、Microsoft Azure Functionsなど、すべて似たようなアプローチを取っている。しかしいずれも目新しいコーディングの方法という以上の可能性を秘めている。サーバーレス・コンピューティングはプログラムとそれを作動させるインフラとの関係についてのわれわれの概念を一変させることになるだろう。

ただし、まだわれわれはそういった場所まで到達していない。サーバーレス・コンピューティングが一般的な現実となるまでには数多くの作業が必要だ。しかしこの分野には近い将来、多数のスタートアップを生むに足る巨大なポテンシャルがある。次の「ビッグな波」を探している投資家の注目を集めていることはもちろんだ。

参入障壁がさらに下がる

AWS Lambdaのジェネラル・マネージャー、Tim Wagnerは「サーバーレス・コンピューティングの最大のメリットはデベロッパーがサーバーを管理することに伴う負担をすべて取り除くところにある」と言う。「サーバーを利用するときに、プロビジョニング、デプロイング、パッチング、モニタリング等々、OSレベルでの煩わしい作業は必要なくなる」とWagnerは説明する。

Wagnerによれば、デベロッパーはプログラムの実際の機能の実現にコーディングの努力を集中できる。プログラマーがイベントや関数を定義すればクラウド・プロバイダーがそれを実行するために必要なインフラの容量を正確に見積もり、必要な作業をすべて引き受ける。これはプログラムがたった1行のコードに過ぎない場合でも同じだ。

Greylock Partnersでアーリーステージのスタートアップに投資を行っているパートナー、Sarah Guoはサーバーレス・コンピューティングはインフラの処理をプロバイダーに任せることによりデベロッパーを機能の開発に専念させる効果があると考えている。【略】

写真:Colin Anderson/Getty Images

調査によれば…

クラウド・コンピューティング企業のDigital Oceanは最近、4800人のIT専門職を対象とする調査を行った。これによれば、55%のITのプロが自分たちをデベロッパーだと考えていたが、サーバーレスについてどう考えるかという質問に移ると、約半数がコンセプトを十分に理解していないことが判明した。しかし81%の人々は重要性を認識しており、これについて今年さらに研究するつもりだと答えている。

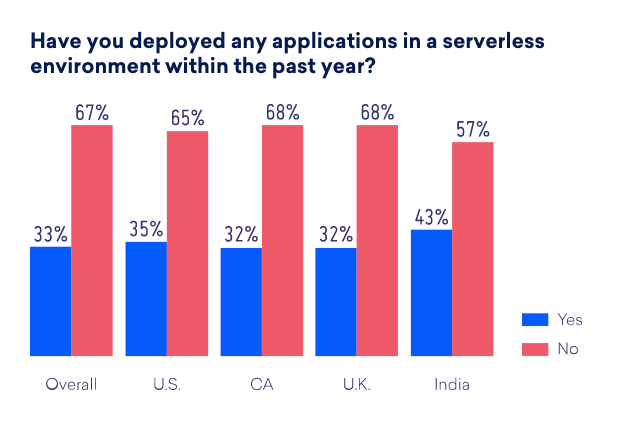

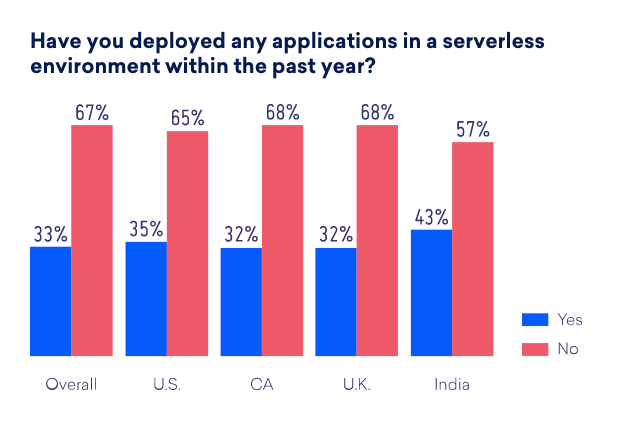

このような状況を考えれば、この1年間にサーバーレスでアプリケーションを開発したことがあるかという質問に3分の2が「ない」と答えたのは驚くにあたらない。この率は世界各国ともほぼ同一だった(インドだけがサーバーレスの採用で43%と他地域よりやや高い率を示している)。

グラフ: Digital Ocean

Digital Oceanの調査では、サーバーレス・モデルを利用しているユーザーの中ではAWSが他を大きく引きはなしたトップだった。回答者の58%がAWS Lambdaをツールとして使っていると回答している。Google Cloud Functionsが23%、Microsoft Azure Functionsが10%で続いている。

サーバーレスを採用することに抵抗がある層はその理由としてツールの欠如を挙げている点は興味深い。Digital Oceanのレポートは「サーバーレス・モデルでデベロッパーが直面するもっとも大きな困難の一つはモニタリングとデバッギングだ」と述べている。つまりサーバーレスの可視性を高めるツールの開発ができればスタートアップにとっては大きなチャンスとなる。

エコシステムを創造する

インフラをカバーする抽象化レイヤーは同時に別のニーズを生み出す。これには当初から予測できるものと、実際にプログラミンするなかで浮上する予想外のニーズとがある。現在まだツールが不足していることはサーバーレスの普及を妨げる要素ではあるが、必要は発明の母という言葉のとおり、あらたなツールを生み出す強力な要因ともなる。

これがGrelockのGuoが投資家として重視する点だ。「デベロッパーがサーバーレス開発にアクセスしやすくなるよう、さまざまな側面を改善していかねばならない。ここに大きなチャンスがある。ユースケースの拡大と同時に、可視性やセキュリティーの改善が重要な課題となる。これらの問題はインフラのコントロールをベンダーなど外部に預ける場合に非常に重要性を持ってくる点だ」という。

写真: shylendrahoode/Getty Images

Accelのジェネラル・パートナー、 Ping Liもサーバーレス化は投資家にとって大きなチャンスだ考えている。「デベロッパーがアプリケーションを開発する手法にシフトが起きれば、それを助けるためのツール・セットの開発に大きなチャンスが生まれるというのが現実だ」Liは述べている。

Liはまたチャンスは大きいがサーバーレス化がメインストリームになるためにはこの手法を採用するデベロッパーの数が臨界量を超える必要があるみている。「サーバーレスには強い関心をもって注視している。将来のアプリケーション開発で中心的な位置を占めることになると思う。しかし現在はまだごく初期段階にあることも事実だと言いたい」という。

Madrona Venturesのマネージング・ディレクター、 S. Somasgearはサーバーレスはインフラまわりの煩雑さを大いに軽減すると同時に新しい課題を生み出し、これがスタートアップにとってのチャンスとなると主張する。「この問題は複雑だ。インフラストラクチャーを抽象化したレイヤーを構築し、このレイヤーを使えばインフラに煩わされることがないとデベロッパーに利用を勧めたとする。しかしデベロッパーが本当にそのレイヤーを使いこなせるようになるためには数多くのツールが提供されなければならない。それは開発ツールかもしれないし、デバッギング、デプロイメント、モニタリングのツールかもしれない。サーバーレスの世界でアプリケーションを開発するデベロッパーに実際に何が起きているのか正確に知らせるツールが必要だ」という

ツール整備を超えて

可視性の確保も重要な課題となるだろうが、可能性はそこにとどまらない。TwilioやStripeのような会社が提供しているのは通信や決済代行サービスについて深い知識がなくてもAPIを通じたライブラリの呼び出しや利用などでこうした機能が利用できるようにするサービスだが、サーバーレスの世界でも同種のニーズは大きいはずだ。

企業はサーバーレス・コンピューティングの採用によってさまざまな問題を解決する新たな方法を見出しつつある。今後、このアプローチは勢いを増し、それと共にツールも拡充されていくだろう。

サーバーレスはまだ初期の段階にあるが、Guoも言っているとおり、デベロッパーの仕事はインフラを稼働させることではない。これはやむを得ずやっているに過ぎない。「面白くなってくると思う。エコシステムはまだきわめて初期の段階にある。それでも大きな可能性があることは明白だ。そのためには必要なツールが整備され、プログラマーがサーバーレス方式で開発を行うことに勢いがつけば、その周囲にスタートアップのエコシステムが形成されていくはずだ」とGuoは述べている。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)