【編集部注】著者のAdriana Stanは、W magazineの広報担当ディレクターであり、メディア、文化、テクノロジーに関する著作も行っている。彼女はまた、Interesting People in Interesting Times(興味深い時代の興味深い人びと)イベントシリーズとポッドキャストの共同創業者だ。またもうひとりの著者Mihai Botarelは、RXM Creativeの共同創業者であり、社会とテクノロジーに関する著作を行っている。

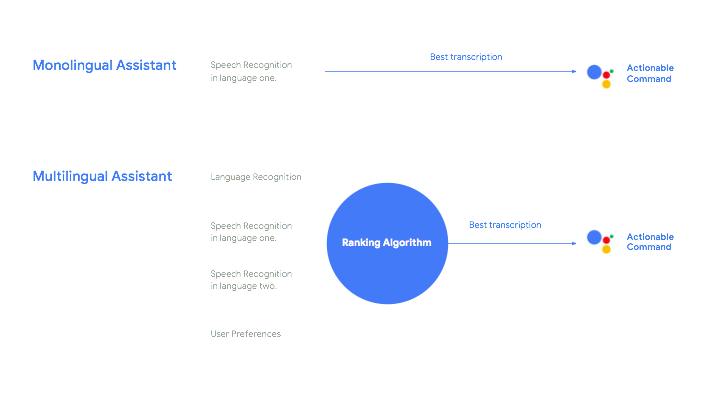

Facebookは私たちの情報へのアクセス方法を決め、 Twitterは世論を左右し、Tinderはデートの意思決定に影響を与える。私たちの選択作業を助けるために、私たち自身が開発したアルゴリズムが、現在の私たちの生活のすべての側面を積極的に動かしているのだ。

しかし、ニュースを探す方法から、周囲の人びととつながる方法に至るまで、すべてのことに対してアルゴリズムへの依存を深めるようになるにつれて、私たちは自分自身の振る舞い方を自動化しているのではないだろうか?人間の思考はアルゴリズムのプロセスを模倣し始めているのだろうか?そして、ケンブリッジ・アナリティックによる大失敗は、アルゴリズムが私たちの集団的思考に入り込んできたときに、何がやって来るのか、そして何が起きるのかに関する警告なのだろうか?

このようになることは想定されていなかった。製品、人物、そして常に溢れる驚くべき量の情報からの選択作業に圧倒された私たちは、取り巻く世界をより良く、より早く、より簡単に生きていくために、プログラムを行ってきたのだ。明確なパラメータと一連の単純なルールを使用することで、アルゴリズムは複雑な問題を理解することを助ける。彼らは私たちのデジタルコンパニオンであり、 あらゆる局面で生じる現実的な課題を解決し、意思決定の方法を最適化してくれる。近所で最高のレストランは何処だろう?Googleがそれを知っている。目的地にはどう行けば良いのか?Apple Mapが役に立つ。最新のトランプスキャンダルは何だろう?Facebookを読めば分かるかもしれないし、分からないかもしれない。

私たちのあらゆる必要性と欲望を予測できるように、コードとアルゴリズムが、私たちの好きなもの、嫌いなもの、嗜好などに関して、よく知っているなんて、素敵なことではないだろうか?このおかげで、私たちは見ているものに対して考え込んで時間を浪費する必要はないのだ:ただ自分の意見を強化するのに最適な記事を読み、個人的な基準に見合う人物とデートを行い、お馴染みのお楽しみの中に我を忘れることができる。私たちはいつでも自由であると想像して欲しい、本当に大切なことに集中することができるのだ:注意深いデジタルペルソナを調整し、自分自身のアイデンティをInstagramに投影する。

私たちの思考が機械によって決定されると最初に述べたのはカール・マルクスだった。この考えはEllen Ullmanによる1997年の本”Close to the Machine“の中で言及されているものだが、今日私たちが取り組んでいる問題の多くを予測していいる。インターネットの発明から始まり、私たちの生活を楽にするために開発してきたアルゴリズムは、最終的には私たちの振る舞い方をプログラミングするようになってしまった。

以下で、3つのアルゴリズムプロセスと、それらが人間の思考に侵入して私たちの行動をハイジャックするやり方を紹介して行く。

1. 製品比較:オンラインショッピングからデートまで

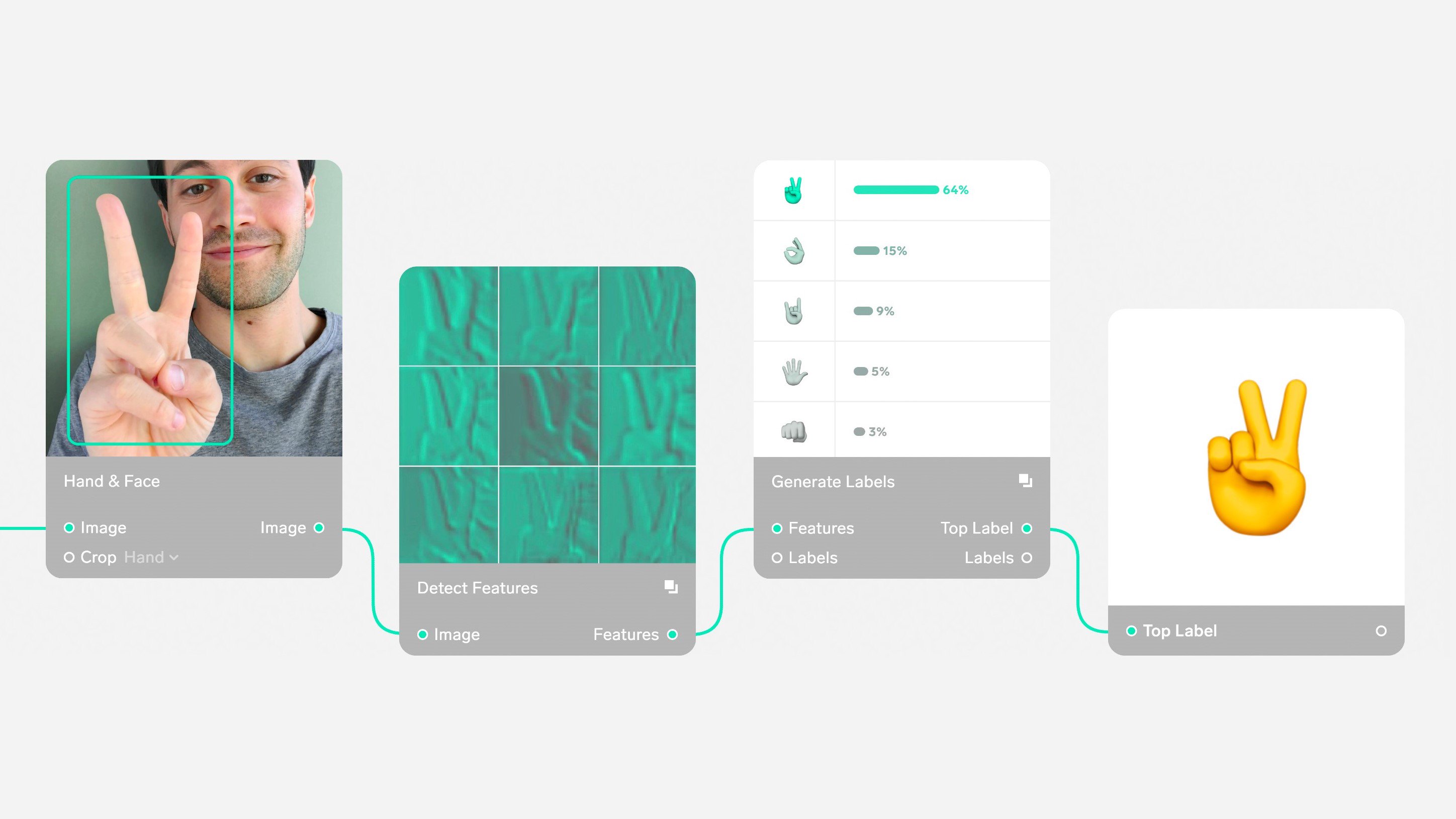

Amazonのアルゴリズムを使えば、製品をブラウズして比較し、後で選ぶために保存し、最終的に購入することができる。しかし、電子商取引の体験を向上させるためのツールとして始まったそれは、いまや当初のものを遥かに超えたものとなっている。私たちはこのアルゴリズムを内面化し、それを私たちの生活における他の領域にも適用している ―― 例えば人間関係など。

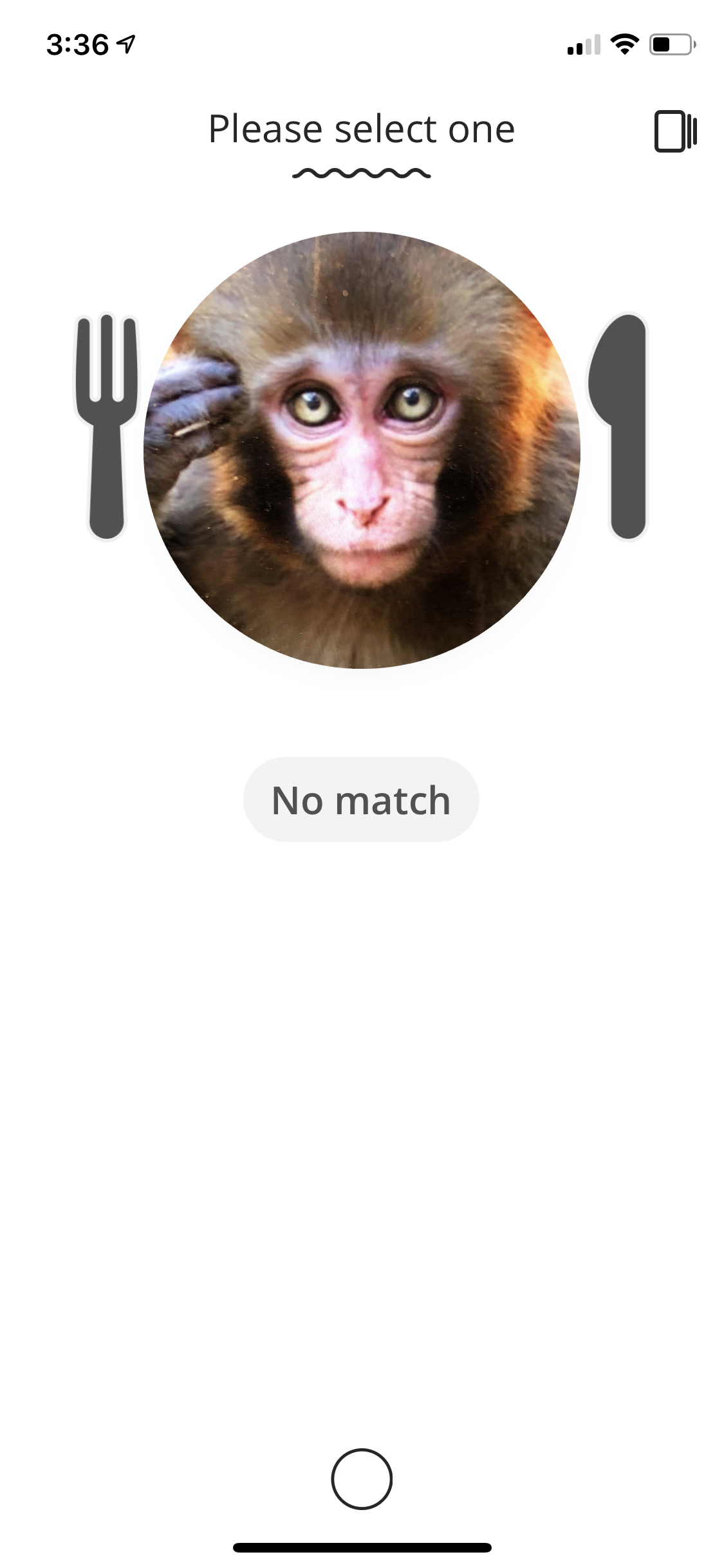

現代のデートは、オンラインショッピングによく似ている。ソーシャルプラットフォームやアプリによって支えられ、私たちは無限の選択肢をブラウズし、その特徴を比較して、自分の欲望を満たし詳細な個人の嗜好に完全に適合するものを選択する。あるいは、電子商取引の世界やデジタルデートの世界に浸透する選択肢の幻想を彷徨い(さまよい)、永遠に判断を先延ばしにして「後で見る」に保存し続けることもできる。

オンラインでは、世界は無限の製品供給源となり、今や人間に関しても同じことになりつつあるのだ。「ウェブではこれまでにないほどの種類の商品やサービスにアクセスすることが可能です、そこから最も気に入ったものを選択することができるのです」とUllmanはLife in Codeの中で説明している。「選択することで幸せがやって来るという考え方がある。空っぽで、幻で、惨めさを連れてくる選択に満たされた海だ」。

私たちは皆、自分のニーズは完全にユニークなものであると考えることが好きだ。そして自分の欲望に完璧にマッチするものを見出すという約束がもたらす、誘惑と喜びの感覚は確かに存在する。

ショッピングや出会いを問わず、私たちは常に検索、評価、比較するようにプログラムされている。アルゴリズムによって駆動され、より大きな意味で、ウェブデザインとコードによって、私たちは常により多くの選択肢を探している。Ullmanの言葉を借りれば「あなたは特別だ、あなたのニーズはユニークだ、そしてアルゴリズムはあなたのユニークなニーズと欲望に完全に合致するものを見つけるのに役立つ」という考えを、ウェブは強化しているのだ。

一言で言えば、私たちの生活の方法が、インターネットに向き合う方法を真似ているのだ。アルゴリズムは簡便な手段だ、厄介な人間生活…絡み合った人間関係と可能なマッチングに対して2つのうちのどちらかを行わせてくれるからだ:そのことに対処する明快でアルゴリズミックなフレームワークの適用、もしくはアルゴリズム自身に選択そのものも任せてしまうやり方。私たちは、自分自身の言葉でテクノロジーを使うのではなく、アルゴリズムに適応し付き合うことを強制されている。

このことは、もともとは単純なデジタル行動から始まった、また別の実世界現象へとつながる:製品と経験の格付けだ。

2. 人間の数値化:評価とレビュー

他の善意のアルゴリズムと同様に、これはあなただけを念頭に置いて、あなただけのために設計されている。あなたのフィードバックを利用することで、あなたのニーズに的確に応えることができ、あなたのためだけにターゲットを絞ったお勧めを提供し、これまでに好んでいたものをより多く提示することで、何も考えずに消費を続けることができる。

Uberの乗車から、Postmateの配送、Handyの清掃まで、およそ全ての実生活でのやりとりが、1から5のスケールでデジタルにスコアリングされる。

社会として、これほどまでに、私たちがどのように認知され、どのように行動し、他の人々の期待との差異を気にする時代はかつてなかった。私たちは突如、Airbnbホストのデザイン趣味や清潔さのような主観的なものを、定量化することができるようになった。そして、それを私たちが差し迫って行う感覚は信じられないほどだ。Uberを降りるか降りないかのうちに、神経的に5つ星を付け、パッセンジャーレーティングを上げるために多額のチップをはずむといった具合。そうすれば、見返りに素早くレビューを受けられる!そして至福の喜びで満たされるという流れだ。

おそらく、あなたはそのことをディストピアであるBlack Mirrorのシナリオめいていると考えるかもしれないし、(風刺の効いたコメディ番組である)Portlandiaのいちエピソードのようなものだと感じるかもしれない。しかし、私たちはデジタルスコアが私たちの生活の中のすべての意味を同時に置き換えて動かす世界から、さほど遠く離れているわけではないのだ。

私たちは他の人との交流の方法を自動化してきた。私たちは、無限の自己改善のサイクルの中で、そうした相互作用を絶えず測定しては最適化しているのだ。それはアルゴリズムから始まったものの、いまや後天的な習性となっている。

Jaron Lainierが”Close to the Machine”の前書きに書いたように「私たちは自分たちのアイデアを使ってプログラムを作成したが、そのプログラムを使った暮らしを続けるうちに…(中略)…それらを自然に埋め込まれた事実だと受け容れるようになった」のだ。

なぜなら、技術は抽象的でしばしば捕らえどころのない、望ましい性質を定量化できるからだ。アルゴリズムを通して、信頼はレーティングとレビューに、人気は「いいね!」に、社会的認知度はフォロワーに変換されていく。アルゴリズムは、ある意味ボードリヤールの予見した世界を生み出したのだ、そこではそれぞれのレーティングが対象としている実際の物を完全に置き換えてしまう。そしてそこでは、デジタルレビューの方が実際の実体験よりも、よりリアルで確かに有意義なもののような気がしてしまうのだ。

実生活の複雑さと混乱に向き合って、アルゴリズムは私たちがそれを単純化する手助けをする。社会的なやりとりから厄介事を取り除き、同様に様々な意見や実生活におけるフィードバックからもたらされる不安も無くして、全てをレーティングボックスのなかにきちんと収めるのだ。

しかし、私たちが自分の思考の一部として、プログラミング言語、コード、そしてアルゴリズムを取り入れていくとき、人間の本性と人工知能は一体化して行くのだろうか?これまでの私たちは、AIを私たちの力があまり及ばない外的な力と考えてきた。もしAIの最も直接的な脅威が、ロボットが世界を支配するということよりも、テクノロジーが私たちの意識と主観に埋め込まれてしまうことだとしたらどうだろう?

スマートフォンが私たちの身体の感覚の延長となったように、アルゴリズムは私たちの思考の延長に成りつつあるのだ(マーシャル・マクルーハンが生きていたら、おそらくそう言うだろう)。しかし、それらが私たちを人間たらしめる性質を置き換えて行くとき、私たちは何をするのだろうか?

そして、Lainierが問いかけるように「コンピューターが人間の言語を、どんどん仲介するようになるにつれて、言語そのものは変わり始めるのだろうか?」。

画像:antoniokhr/iStock

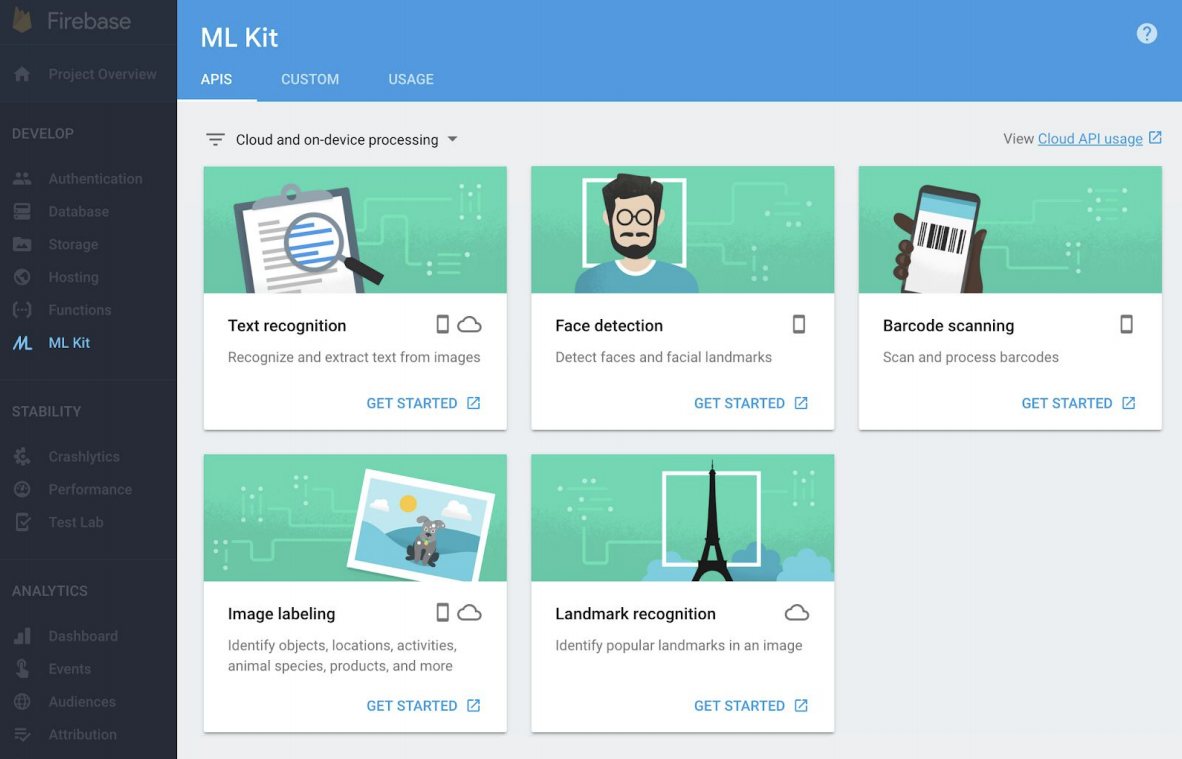

3. 言語の自動化:キーワードとバズワード

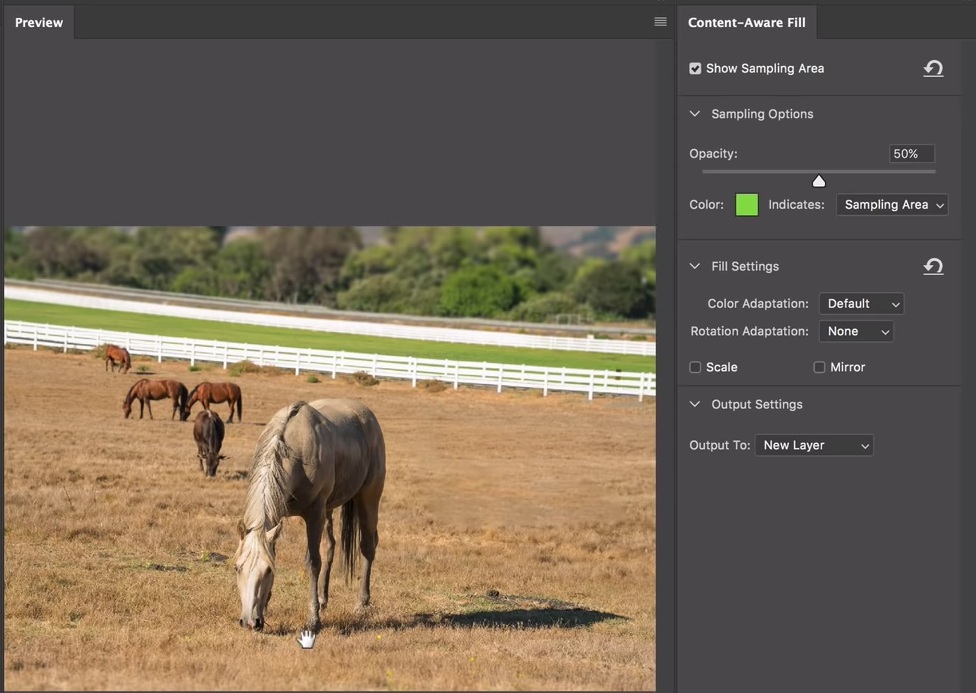

Googleはキーワードに基づいて検索結果をインデックス化する。SEOは特定の戦術に基づいて、ウェブサイトを検索結果のトップに浮上させる。これを達成するために、アルゴリズムに取り組み、どうすれば上手くいくのかを探り、Googleの目にとまるようなキーワードをウェブサイトにまぶすのだ。

しかし、Googleのアルゴリズムとよく似て、私たちの心は、情報をキーワード、繰り返し、および素早いヒントに基づいて優先付けている。

それはテクノロジーに関して構築した戦略として始まったが、いまや見出しを書く方法から、ツイートで「エンゲージメント」を生み出すやり方、そしてビジネスや日々の生活の中で自分自身を表現する方法に至るまで、私たちが行うことすべてに浸透を始めている。

メディアの世界とスタートアップシーンの両方を支配する、バズワードの流行を考えて欲しい。そこに出現するいくつかのトップスタートアップを素早く眺めてみれば、人びとの注意 ―― そして投資家の資金 ―― を引きつけるための最善な方法は、「AI」「暗号」あるいは「ブロックチェーン」といういう言葉を会社の売り文句に加えることだということがわかる。

企業は、キーワードを通して世界に発信していることに基いて、評価されている。プレゼンテーションの場がより多くのバズワードで埋められるほど、煙に巻かれた投資家がそこに投資をしてくれる可能性が高まる。同様に、バズワードを含む見出しの方がクリックされる可能性が遥かに高いので、バズワードの方が実際の内容よりも勝るようになりはじめる。(派手な見出しでクリックを誘う手段である)クリックベイトはそれを示す1つの例だ。

私たちはどこに向かうのだろう?

技術は私たちにあからさまなパターンを与えている。例えば、オンラインショッピングは溢れる選択肢の中を進んでいくための簡単な方法を提供している。よって私たちは改めて考える必要はない ―― 私たちはただ、アルゴリズムが最善のやり方を知っていると仮定して操作しているだけだ。私たちはそれらがどのように働いているのかを本当に理解しているわけではない。コードは隠蔽されているので、私たちはそれを見ることはできず、アルゴリズムはただ結果とソリューションを魔法のように提示するだけだ。UllmanはLife in Codeで次のように警告している「私たちのために、複雑さが隠されて扱われることを許容するのなら、最低限私たちが何を手放しているのかに注意を払うべきです。私たちは用意された部品の利用者になるという危険性を犯しています…(中略)…私たちが本質的に理解していないメカニズムを、相手にしているのです。全てが期待通りに働いている限りは、こうした『無知』も許容されるでしょう。しかし、何かが壊れたり、間違ったり、根本的な変化を必要とするときには、私たち自身の創造物を前にして、為す術もなく立ち尽くす以外に何ができるのでしょう?」。

トランプ時代の、フェイクニュース、誤報、ソーシャルメディアのターゲティングの始まりだ。

さて、そうだとしたら、批判的思考を奨励し、プログラミングにもっと関心を寄せ、旧き良き時代の論争と異議をどのように取り戻せば良いのだろうか?意見の相違を醸成し、繁栄させ、私たち自身の見解に挑戦させるようにするために、私たちは何ができるのだろうか?

私たちが、テクノロジーが生み出す気を散らす泡の中で行動するとき、そしてソーシャルメディアフィードが、自分と同様の考えを持つ人で構成されているとき、社会が変わることは期待できるのだろうか?起きることと言えば、アルゴリズムが私たちに促すように、結局行動してしまうことだ。これを打ち破るには現状に疑問を呈し、事実を分析して、自分自身の結論に達することが必要だ。しかし、そうしたことに割ける時間を持つものはいない。こうして私たちはFacebookマシンの歯車と化し、プロパガンダの影響を受け、おめでたいことに働いているアルゴリズムを意識することもない ―― そしてそれは私たちの思考プロセスの中に組み込まれているのだ。

自分自身の意志決定に対するプログラマーやアーキテクトではなく、アルゴリズムのユーザーとしての私たちは、自分自身の知性を人工的なものにしてしまう。Douglas Rushkoffが言っているようにこれは「プログラムするのかそれともプログラミングされるのか」の問題なのだ。もしケンブリッジ・アナリティカの事件と2016年の米国選挙から学んだものがあるとすれば、世論をリバース・エンジニアリングにかけて、結果に影響を与え、そしてデータ、ターゲット、そしてボットが誤った合意の感覚に導く世界を作り出すことは、驚くほど簡単だということだ。

さらに厄介なのは、私たちがとても信頼しているアルゴリズム ―― 私たちの生活に深く織り込まれ、私たちの最も個人的な選択に影響を与えている ―― は、私たちの思考プロセスへの浸透をやめない。それどころか、ますます大きく重要なものとなっている。もし私たちが、アルゴリズムのユーザーではなく、プログラマーとしての役割を取り戻さなければ、最終的にはアルゴリズムが私たちの社会の未来の形を作り上げていくことになるだろう。

[原文へ]

(翻訳:sako)

<

<