今日(米国時間2/27)、GoogleからClipsが登場した。これはGoogleによれば「スマート・カメラ」だ。セキュリティーカメラでもないし、アクションカメラでもない。そういう用途ならすでに多数の製品が市場に出ている。シンプルで親しみやすい外見の内部にはきわめて高度かつ洗練されたテクノロジーが詰め込まれている。Clipsは見たところInstagramのアイコンのようなデバイスだが、妖精が魔法の杖を一振りして自ら撮影する現実のデバイスに生まれ変わらせたとでも言おうか。まったく新しいカテゴリーのカメラだ。

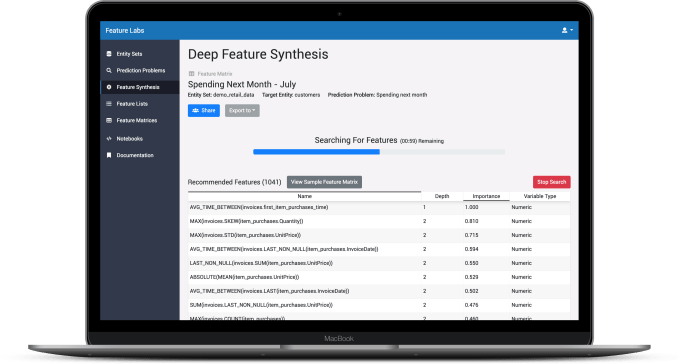

このカメラが最初に紹介されたのはPixel 2が発表された昨年のプレスイベントだ。このときGoogleは「設定したら後は忘れていい」ようなお手軽デバイスだとしていたが、現実の製品は非常に高度なものだ。Clipsは日常生活の中で、普通なら見逃され、したがって撮影されることもない瞬間を捉えるためのカメラだ。人工知能と機械学習を組み合わせたシステムが人物やペットを個別に認識し、記録すべき瞬間を判断する。

AIとMLのコンビネーションはすべてオンボードで、つまりカメラ内で作動する。データがGoogleのクラウドに送られることはない。これにより処理がリアルタイムとなる上にプライバシーも守られる。撮影された内容はユーザーが転送しないかぎりカメラの外に出ることはない。

これは小さな子どもの両親には特に興味あるプロダクトだろう。始終カメラやスマートフォンを手にしていなくてもClipsが子どもたちのかわいい瞬間を記録してくれる。ただしその価格は249ドルだ。

レンズは固定焦点

Clipsをできるだけシンプルなものにしようと大変な努力が払われたようだ。その結果、写真のようなミニマリスト的デザインとなった。サイズは1辺5センチの正方形で、レンズは固定焦点だ。レンズ部分をひねるとオンになる。本体に内蔵された3つのライトが光って撮影中であることを示す。Googleによれば、これは周囲の人々に「これはカメラであり撮影中だ」ということを知らせるためのデザインだという。なるほどこの筐体はカメラのマンガのようなデザインだから始めて見たら本物のカメラだと気づかない人もいるだろう。

レンズの下にはタッチセンサー式のボタンが内蔵されている。これはこのデバイスで唯一のボタンでシャッターの役割だ。おそらくベータ版をテストしているときにユーザーからの要望で後付けしたのだろう。このシステムは機械学習で自動的に撮影すべき瞬間を決定するというのがセールスポイントだが、ときには人間が介入したくなることもあるはずだ。

本体底部にはUSB-Cポートが1つありバッテリーを充電できる。システムをリセットするためのピンホールも設けられている。本体裏側にはGのロゴ以外はなにもない。液晶モニターもファインダーもない。これは操作をシンプルにすると同時にバッテリー駆動時間を伸ばすためだという。

Clipsを設置する位置やアングルはユーザーが直感的に決める。固定焦点レンズなのであまり多彩なことはできない。Googleは撮影対象から1メールから2.5メートル程度となる位置を推奨している。Clips専用のアプリ、Live Previewを使えば、カメラが何を写しているか確認することができる。もちろんClipsは水平な場所に置くほうがよい。

すべてはリバーに流れる

Clipsの使い方はシンプル過ぎるほどシンプルだ。デフォールトで7秒の動画が撮影される。Googleはこれをclipと呼んでいる。今は無くなってしまったが、TwitterのVineを使ったことがあるだろうか? あれと同じようなものだ。Apple Live PhotosやGoogle自身のMotion Photosにも似ている。

キャプチャーされたビデオはまず静止画として一列にリバー表示される。静止画をスクロールすると動画になり7秒が再生される。

タップすれば静止画もビデオも編集可能だ。Clipは一連の静止画として記録されているのでどの瞬間でも編集できる。Photoオプションを利用して気に入った1枚を選び、jpeg画像にして保存することが可能だ。ビデオについてはトリミングして長さを調整するオプションがビルトインされている。

ML―機械学習

Clipsではときおり右上隅でアイコンが点滅する。これは「Clipsのおすすめ」を意味し、システムが「よく登場する人物やペット」を認識したというサインだ。この機能を使いたい場合はデバイスをGoogleフォトに接続し、顔認識情報を取得する必要がある。

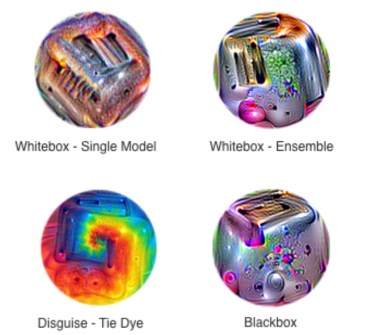

Clipsはそのままでも人物の顔を素早く認識できるが、テストしてみたところでは当たり外れが激しかった。現在のところClipsのMLは人間、犬、ネコを認識するようトレーニングされているという。

ついでに言えば、ビデオでわかるとおりClipsはウサギもきちんと認識する。搭載AIの機能はあまりに複雑でGoogleの開発チームもなぜウサギをうまく認識できるのかはっきりした説明はできないようだ。たとえばこの機械学習は「4つ足で立つ」という特徴を探すようトレーニングされているが、ウサギはあまりそういう姿勢を取らず、後足を畳んで座っていることが多い。しかしGoogleの人工知能はこういう障害を乗り越えた。Clipsでペットのウサギを撮りたいユーザーには朗報だ。

完璧な1枚

Clipsはここぞという瞬間をなかなかうまく捉えてくれる。もちろん完璧というわけにはいかない。完璧な1枚を選ぶにはやはり人間の介入が必要だ。Clipsは膨大な枚数の写真を撮影するが、ユーザーが友達などに公開するのはほんの一部だろう。

デバイスの内蔵ストレージは16GBあるので1080ピクセルで7秒間のビデオなら相当多数が記録できる。ビデオを削除して場所を空ける必要が出てくるのはだいぶ先だ。バッテリーは連続3時間の撮影ができる。動きを認識しない時間が続くと自動的にスリープモードに移行する。

1080ピクセルのビデオからの静止画は普通のスマートフォンのカメラで撮影した写真程度の画質だ。ということは暗い場所は苦手で、彩度が下がって全体にグレーになり、動く対象はぼやける。彩度やホワイトバランスはカメラが自動的に設定する。専用アプリからでも設定の変更はできないが、この程度のカメラの場合、人間が操作できるようにすると、Googleが狙っている操作のシンプルさに反するし、かえって画質を下げることになる可能性が高い。

価格は安くはない…?

以前私はセキュリティーカメラを家に設置したことがあったが、 結局アラートの通知を切ってしまった。間違いアラートが多すぎたからだ。たとえ私が地球の裏側にいても、家でウサギが動くたびにアラート送られてくるのがうるさすぎた(その後メーカーは人間と動物を識別する機能を付け加えた)。

Clipsが試みているのはその反対のシステムで、テクノロジーによって興味ある瞬間を自動的に記録しようとしている。人間がスマートフォンやアクションカメラなどのテクノロジーによって縛られないようにすることを目指すテクノロジーだ。いくぶん奇妙であり野心的な目標なのでメインストリームでユーザーを見つけるまでにはしばらくかかるかもしれない。

上で触れたように小さい子どもの両親は大きくなりすぎないうちに、かわいい写真をできるだけたくさん撮っておきたいだろう。犬、、ネコ、ウサギのオーナーにも魅力的なデバイスだ。Clipsを利用すればソーシャルメディアで人気が出そうな写真を簡単に大量に撮れる。ただしそのための価格は249ドルとなる。

〔日本版〕日本のGoogleストアにはまだ情報がない。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)

【以上】