Uberが今日の2018 Uber Open Summitで、同社がLinux Foundationにゴールド会員として加盟し、オープンソースのツールの利用と寄与貢献にコミットしていくことを発表した。

UberのCTO Thuan PhamにとってLinux Foundationは、同社がオープンソースのプロジェクトを育(はぐく)み開発していくための場所だ。“オープンソースの技術はUberの中核的サービスの多くを、そのバックボーンとして支えている。会社の成熟とともに、これらのソリューションはますます重要になっている”、と彼はLFへの加盟を発表するブログ記事で述べている。

意外なのは同社が参加したことでなく、それまでに要した年月の長さだ。Uberはかなり前から、その中核的ツールにオープンソースを多用していることで知られていたし、同社の資料によると、これまで320あまりのオープンソースプロジェクトとリポジトリに関わり、1500名のコントリビューターが70000あまりのコミットに関わっている。

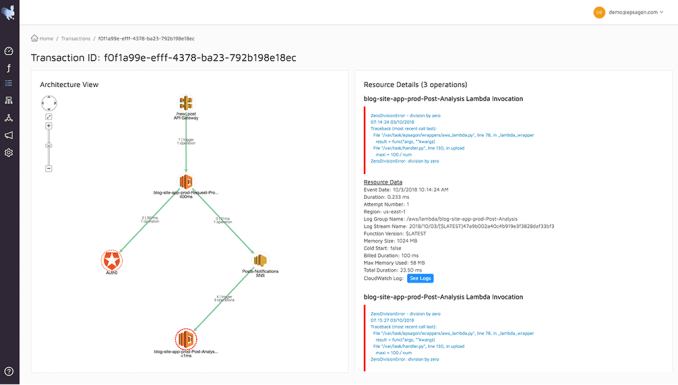

Uberのスポークスパーソンは次のように語った: “Uberは何年も前から、オープンソースによる共有的ソフトウェア開発とコミュニティのコラボレーションに有意義な投資をしてきた。その中には人気の高いオープンソースプロジェクト、分散トレーシングシステムのJaegerへのコントリビューションもある。また2017年にはLinux Foundation傘下のCloud Native Computing Foundationに加盟している”。

Linux Foundationの事務局長Jim Zemlinも、Uberの加盟を喜んでいる。声明文に曰く: “彼らの専門的な技能や知識は、これからクラウドネイティブ技術やディープラーニング、データ視覚化など今日のビジネスにとって重要な技術の、オープンなソリューションを進めて行かなければならないわれわれのプロジェクトにとって、きわめて有益である”。

Linux Foundationは数多くのオープンソースプロジェクトがその傘下にある支援組織で、Uberのような企業がオープンソースのプロジェクトをコミュニティに寄与貢献しメンテナンスしていくための、組織構造を提供している。そしてその傘の下には、Cloud Native Computing Foundation, Cloud Foundry Foundation, The Hyperledger Foundation, そしてLinuxオペレーティングシステムなどの専門的組織が並んでいる。

これらのオープンソースプロジェクトをベースとして、コントリビューターの企業やデベロッパーコミュニティが改良やフォークを重ね、自分たちのビジネスに活かしていく。Uberのような企業はこれらの技術を使って自分のバックエンドシステムを動かし、サービス本体は売らないけどオープンソースのオープン性を利用して自社の将来の要求も満たしていく。その際はコントリビューターとして貢献することになり、取るだけでなく与える側に回る。