ソラコムがステルスで取り組んでいた新規プラットフォーム事業の詳細を明らかにした。ソラコムは、元AWSのエバンジェリスト玉川憲氏が2015年3月にAWSを退職して設立したスタートアップ企業で、創業直後に7億円というシードラウンドとしては大型の資金調達が注目を集めた。TechCrunch Japanは発表直前にソラコムに話を聞いてきたので詳しくお伝えしたい。

提供を開始したSIMカードを手にするソラコム創業者で代表の玉川憲氏

ソラコムが取り組むのは、IoT向けの格安MVNOサービス「SORACOM Air」だ。これだけ書くと、何だまたもう1つ別のSIMカード提供会社か登場したのかと思うかもしれないが、2つの点で注目だ。

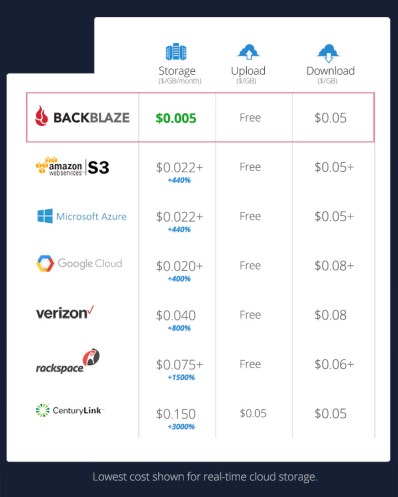

1つは、利用用途によっては月額利用料が300円で済むという衝撃的な安さ。これだけでもIoTや業務用スマホ・タブレットの全く新しい市場を切り開く可能性がある。

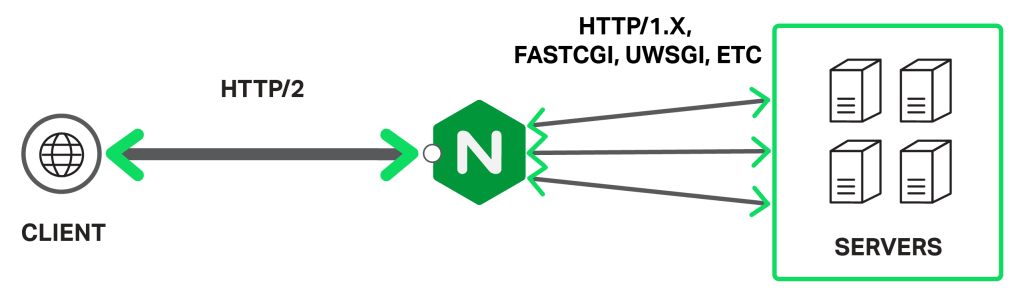

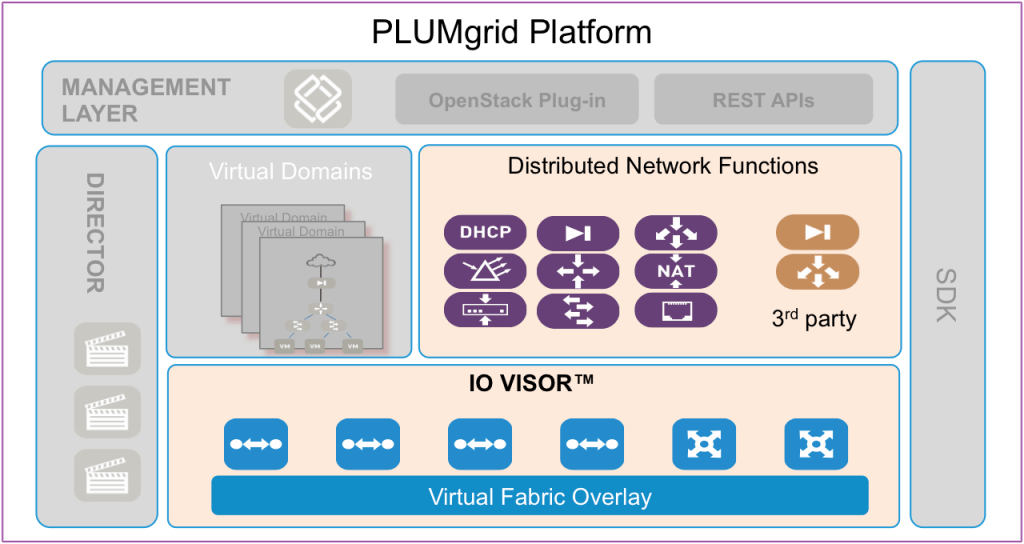

さらにもう1点、ソラコムの新プラットフォームが注目すべき理由は、基地局だけ既存キャリアのシステムを流用していて、残りをソフトウェアで実装している点だ。通信キャリアはもちろん、従来のMVNO事業者は、パケット交換、帯域制御、顧客管理、課金など、キャリア向けの専用機器を利用していた。ソラコムでは、この部分をAWSのクラウド上に展開したソフトウェアで置き換えてしまった。

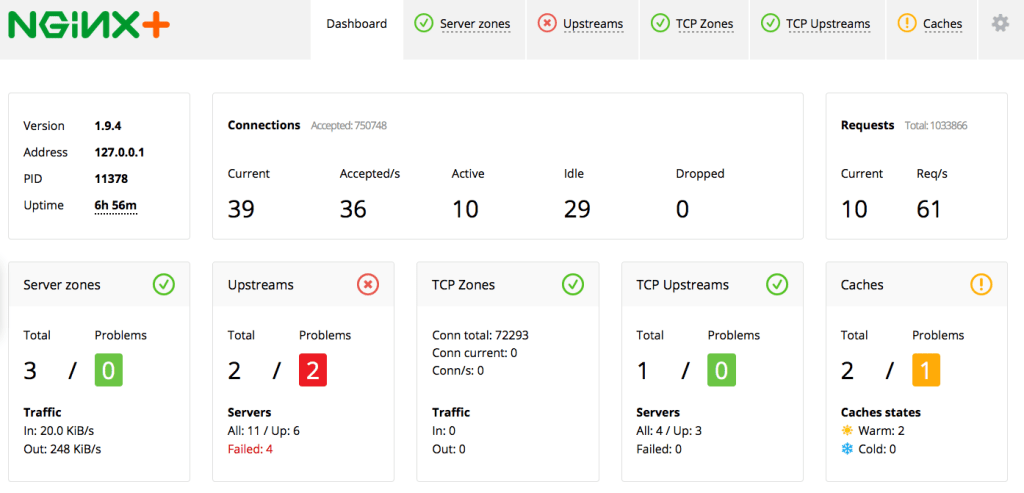

これは単に運用コストの削減に繋がるだけでなく、高い柔軟性とスケーラビリティーを確保できるということだ。例えば、SIMカードを搭載したデバイス、もしくはそのデバイスを管理するサービス側からソラコムのAPIを叩いて通信速度をダイナミックに変更できたりする。これは、ちょうどAmazon EC2でインスタンスをソフトウェア的に切り替えるような話だ。暗号化通信もクラウドの豊富なコンピューティングリソースを使うことでソフトウェア的に簡単に実現できてしまう。AWSでサーバーがプログラマブルになったように、ソラコムは通信サービスをプログラマブルにしてしまうということだ。

IoTで未解決だった「通信とセキュリティー」問題を解決する

ソラコムの狙いと、今後のビジネスモデルの話は、創業者である玉川憲氏の経歴に重ねて説明すると分かりやすいかもしれない。

WatchPad

玉川氏は東京大学大学院機械情報工学科修士卒で、日本IBMの基礎研究所でキャリアをスタートしている。2000年ごろ、IBMで「WatchPad」と名付けられた今で言うスマートウォッチを作っていたそうだ。製品化には至らなかったものの、Linux搭載で腕に巻きつけられる超小型コンピューターとして当事非常に大きな注目を集めた。

「2000年にIBMの基礎研でWatchPadを作っていたのですが、その頃からIoTの課題って変わってないなと思っています。1つはバッテリーが持たないこと。10年かかって2倍にもなっていませんよね。10年で100倍速くなっているコンピューターとは違います。もう1つはネット接続。近距離無線は進化しているものの、まだまだネット接続が難しいのが現状です」

「もう1つ未解決なのはセキュリティーです。デバイスで暗号化をすると小型化や低コスト化ができません」

ソラコムでは、通信とセキュリティーについての回答を用意したという。

近距離通信としてはBluetoothが普及しているし、家庭内のWPANとしてZ-WaveやThread、Weave、ZigBeeなどの規格もある。しかし、これらはスマホやハブといったアップストリームにぶら下がった端末までの接続のためのもので、ネット接続ではない。一方、Wi-Fiは小型デバイスにとっては難しい。玉川氏によれば、これまでモバイル通信は、おもにヒト向け。「IoT向けのモバイル通信を作りたい」と考えて立ち上げたのがソラコムだという。

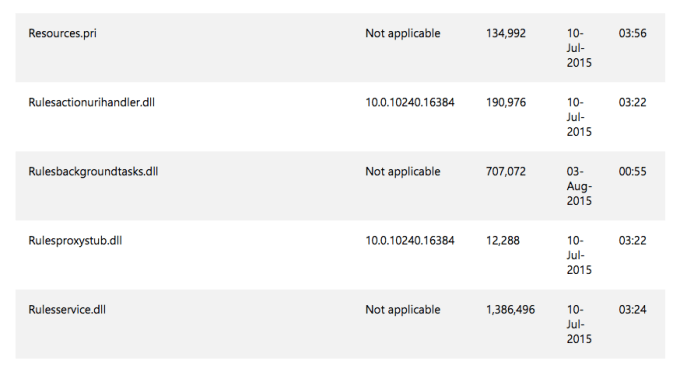

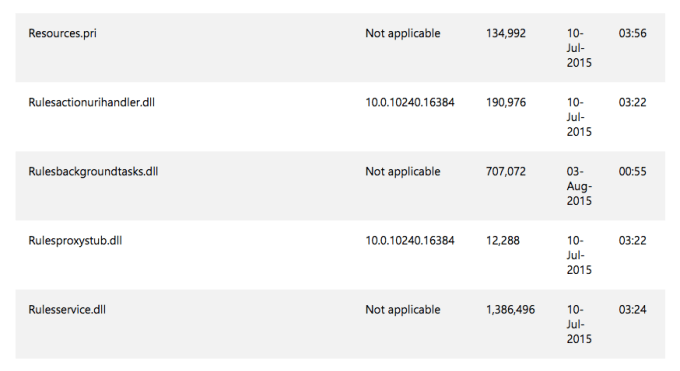

従来のMVNOと違って専用機材ではなく、クラウド上に各機能を実装

モバイル向け通信に参入するといっても、「全国に設置した基地局だけで1兆円ぐらいのアセット。パケット交換や帯域制御、顧客管理、課金といった部分で数千億円規模の投資。さらにISPも入れて、この3つをやって初めて通信キャリアなわけですが、われわれは、そうはなれません」という。

「一方、MVNOといえば、楽天やイオン、DMMが参入しています。これは(1契約あたり)2000円で仕入れて2500円で売るというビジネスで、ブランドや販売網があればできますが、これもわれわれにはできないし、テクノロジーのビジネスでもありません。われわれがやるのは基地局だけをレイヤー2接続の契約で利用して、残りはクラウドネイティブで提供するというモデルです」

従来のMVNOの接続では、キャリアが持つ基地局からパケットが飛んでくるゲートウェイに続けて、MVNO事業者が利用者認証や課金管理、利用者ごとのポリシー適用のための機材などをそれぞれ用意する必要があった。ここはエリクソンなど専用ベンダーが提供するハードウェアの世界。ここの機能群をAWSのクラウド上にソフトウェアで実装したのがSORACOM Airで、クラウドの特徴であるスケーラビリティーの高さがメリットだ。玉川氏は「人口の10倍とか100倍のデバイスが繋がってきても対応できるような、IoTに特化したバーチャルキャリア」と、そのポテンシャルを説明する。

スケーラビリティーは上限のほうだけなく、小さい単位から即利用できるという点にも当てはまる。例えばデバイスとサービスを統合したソリューションを展開する企業が通信部分が足りていないようなケース。

「従来のMVNOだとSIMカード2000枚以上、500万円以上からと言われたような話が、SORACOM Airなら1枚から利用できる。誰でも通信キャリアになれるというモデルで、自在に値付けしてビジネスができます」

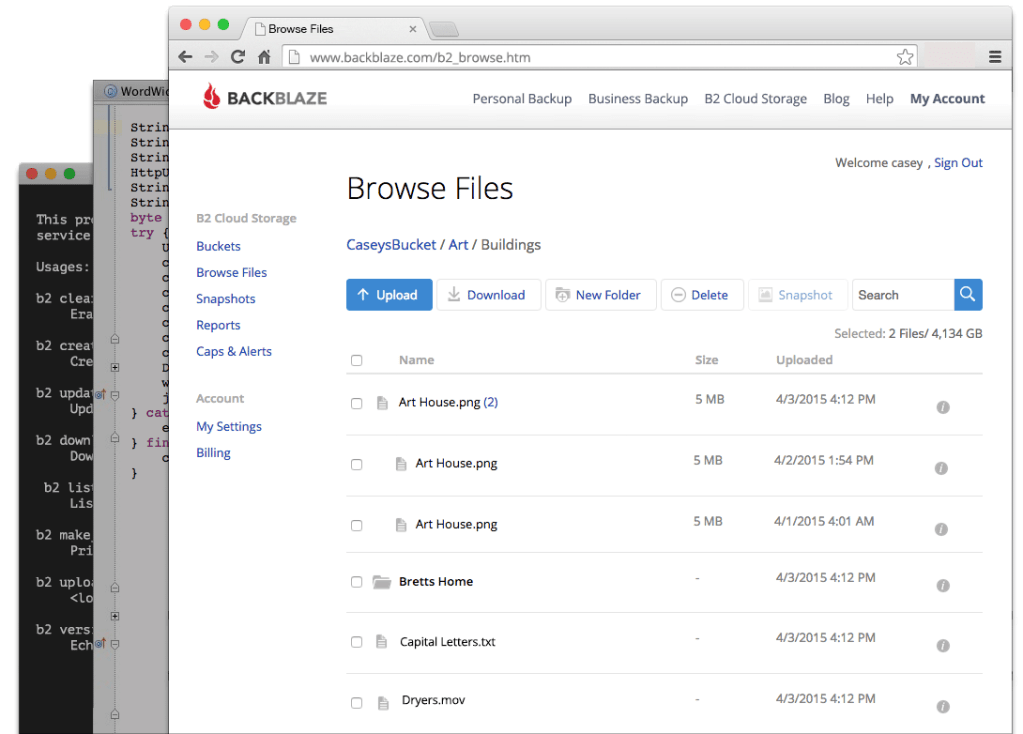

クラウド上に実装された通信管理機能には、AWSクラウドと同様にWebコンソールからでも、APIからでも操作可能で、複数SIMを一括操作するようなことができる。各端末からでもサービス側からでもAPIを通して、各SIMの通信状態の監視や休止・再開、速度変更といったことができる。

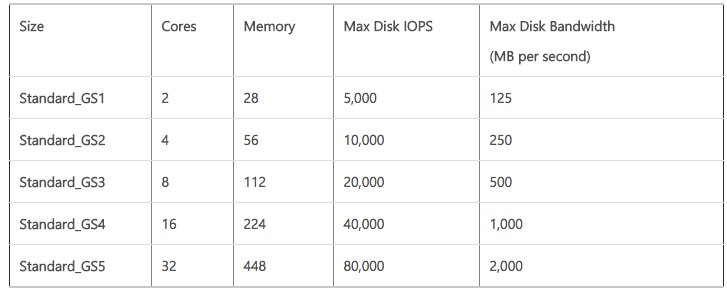

SORACOM AirのSIMカードは20枚で1万1600円(1枚580円)など。月額基本料金は300円で、32kpbsだと1MBあたり上り0.2円、512kbpsで1MBが0.24円。上り・下りで料金が違ったり、夜間割引も適用されるなど明朗会計だ。料金設定はAmazon EC2のインスタンスサイズを選ぶようなイメージだ。将来的にはニーズに応じて料金を変動させる「スポットインスタンス」のようなことも、アイデアとしては検討しているそうだ。以下がSORACOM Airの価格表。s1.minimumとかs1.fastとか、何だか見慣れた命名規則だ。

SORACOM Beamで暗号化やルーティングなど高度な処理をクラウドにオフロード

IoTで未解決だった問題として、玉川氏はセキュリティーを挙げていた。これについてはクラウドで潤沢なリソースを使った「SORACOM Beam」というサービスで解決可能だという。SORACOM Beamはデバイスとサービスを繋ぐ通信経路を暗号化したり、ルーティングするサービスだ。

セキュアな通信を行うには暗号化が必要だが、小型デバイスに暗号化処理をやらせるのは重たい。ただ、もともとキャリアのパケット網はゲートウェイ部分まではセキュアなので、ソラコムにパケットが入ってきてインターネット側のシステム(サーバー)へと繋ぐ部分を暗号化すれば良いだけだ。そこで、

・HTTP→HTTPS

・MQTT→MQTTS

・TCP→SSL

という変換をソラコムのクラウド上で行うことで、重たく面倒な処理はデバイスではなくクラウドで済ませることができる。実際、車いす開発のWHILLは、バッテリーをできるだけ使わずにセキュアに見守りシステムを作ることを検討していて、こういうケースだと「TCP→SORACOM Beam→HTTP」とすることで、デバイス側の負荷をオフロードできるのだという。タイムスタンプやSIMのIDもソラコム側で分かるし、カスタムヘッダを付けてHTTPSで送ることもできる。そして、これがまた重要だと思うのだけど、こうした設定はすべて、デバイスの設定に触れることなくAPIで変更ができる。出荷したIoTデバイスに触れることなく、サービス改善や新規サービス開発が可能ということだ。

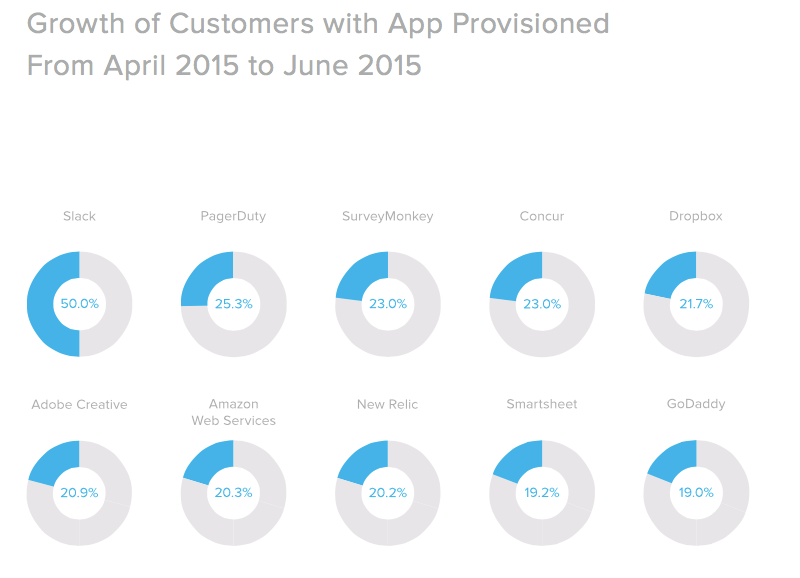

ソラコムでは今回、デバイスやソリューション、インテグレーションのサービスを提供するパートナープログラム(Soracom Partner Space)を発表している。現時点では、以下のような企業がテストしているそうだ。

・内田洋行:IoT百葉箱

・リクルートライフスタイル:無料POSレジアプリ「Airレジ」にSORACOM Air搭載、イベント会場で1カ月だけ臨時店舗運営

・フォトシンス:スマートロックのAkerunで応用、カギを開けるときには低速、ファームウェアのアップロード時には転送速度をアップ

・フレームワークス:物流システムにおける動態管理システム。トラックにスマホを搭載してGPSデータだけを利用。業務時間のみの小容量の通信

・キヤノン:事務機器でSORACOM Airの実証実験

・東急ハンズ:業務システムのバックアップ回線として利用

・Global Mobility Service:フィリピンでクルマにSORACOM Airを搭載。割賦未払いの利用者のクルマを遠隔地から停止

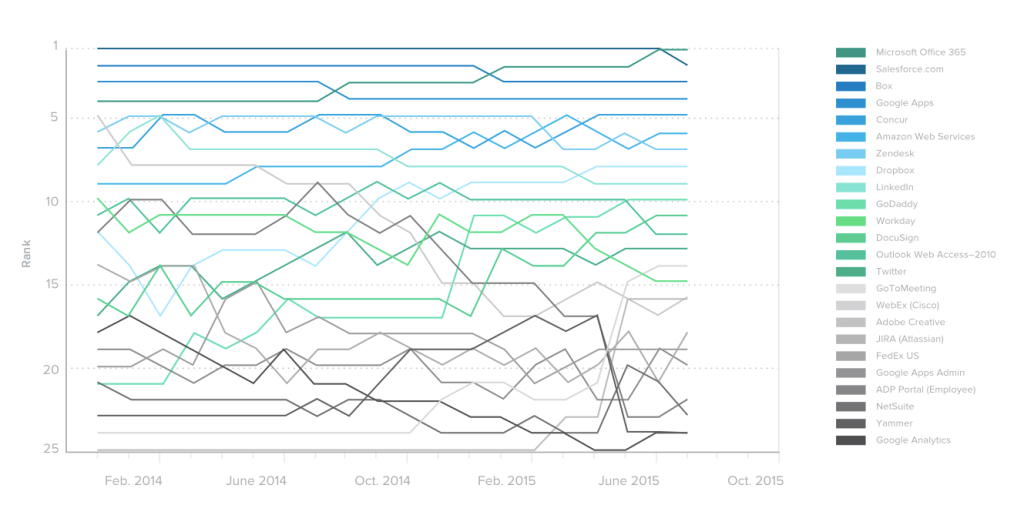

いろいろな実験的取り組みがベータ期間中にも出てきているが、ソラコムの新サービスは、Amazon S3が出てきたときと似ているかもしれない。S3のリリース初期には開発者だけではなく、個人利用で使ってしまうパワーユーザー層にもアピールしたものだ。SORACOM Airも1枚880円からAmazonで購入できるので、何かのアプリが出てきて個人ユーザーが使うような事例も出てきそうだ。

Amazon同様に継続的な値下げ努力とイノベーションで競合に勝つ

ステルス期間は別として、ローンチしてしまえばアイデアは自明だし、ソフトウェアの話なので誰でも実装できるのではないだろうか。競合が出てきたときに、ソラコムではどうやって戦っていくのだろうか。

「ソラコムは、モバイルとクラウドが融合した初めての形と思っています。単純な通信ではなく、暗号化したり、認証したりという付加価値があます。新機能や新サービスも開発していきます。まだ2つ3つは温めているアイデアがありますし、実際にお客さんと話している中でニーズが見えてくる面もあります」

「これはAWSが出てきたときと似てるなと思っています。AWSはクラウドです。当事は、うちもクラウドですといってプライベートクラウドみたいなのが、たくさん出てきましたよね。でも、その多くはあくまでもサーバー仮想化の話であって、AWSがやっているようなクラウドネイティブではありませんでした。ハードウェアを仮想化して、物理サーバー上に仮想マシンを複数設置しましたという程度にすぎなくて。もちろん仮想化は仮想化で価値はあるんですけど、瞬時に使えて、いつでもやめられて、いくらでもスケールできるというクラウドとは違いますよね」

「もしソラコムが取り組む市場が良い市場だとしたら、今後は競合がたくさん入ってくるはずです。でも正しいアプローチでやれる企業は少ないと思うんです。いつでも始められて、いつでも利用をやめられて、APIが備わっていて、自動化ができてという。そういうことを質実剛健にやっていけるような企業は少ない」

「われわれも運用コストに少しだけ利益をのせて回していくのですが、Amazonみたいな薄利多売モデルで、どんどん価格を下げていきます。Amazonにいた私からすると当たり前のことですけど、ふつうはそうじゃありません。多くの企業は大きな利益を取っていくので、同じアプローチを取る会社が多いとは思っていません」

「かつてAWSがでてきて、その結果、InstagramやDropbox、Pinterest、Airbnb、Uberといったサービスが出てきたみたいに、ソラコムのようなプラットフォームによって、きっと面白いIoTが出てくるんじゃないかなと思います」