マウンテンビューの野外コンサートホール、Shoreline Amphitheatreで開催中のデベロッパー・カンファレンス、Google I/Oで、Googleマップの新バージョンが発表された。アップデートはこの夏に実施される予定だ。もちろんナビ機能は維持されるが、次世代マップではこれに加えて多数の便利な探索機能が追加される。

Googleマップのシニア・プロダクトマネージャー、Sophia Linは私の取材に答えて次のように語った。

1年ほど前に Googleマップに何を望むかユーザーにアンケートしたことがある。どうしたらもっと役に立てるだろうか、どんな新機能があったら便利だと思うかと尋ねた。

その中で圧倒的に多い答えが、『自分がいる場所についての情報をもっと詳しく知りたい』というものだった。それによって次にどちらに向かったらいいかを決められるという。そこで私たちはどうしたらその方向でユーザーの手助けができるか研究を始めた。

Googleマップの最大の機能はもちろん「行きたいところへ行くことを助ける」点だ。最近、Googleはマップにありとあらゆる機能を追加しているが、多くのユーザーに利用されているとは言えない。私はLinからマップの探索機能を利用しているユーザーのパーセンテージを聞き出すことはできなかったが、今回の新機能は機械学習の適用によりマップを大幅にスマート化しようとするもののようだ。

もちろん GoogleのことなのでAIを利用したユーザー別の個人化もいっそう進歩する。

新しいマップではFor youという専用タブが新設される。簡単に言えば、ユーザーに対し各種の推薦や情報の提供を行うニュースフィード的な仕組みだ。ただし「フォロー」する相手は人間ではなく、ある地域(お気に入りの町、観光地、訪問を予定して場所等々)だ。フォローしている地域で何かが起きて、Googleがそのニュースがユーザーの関心に合致すると判断すると配信されるのはソーシャルネットワークの場合と同様だ。たとえばその地域であるレストランの人気が高まっているとか、有名コーヒーショップのチェーン店がオープンしたなどという情報を教えてくれる。

Linによれば、これまで地域で何か新しいことを発見するのは運任せの面が大きかった。「たまたま道を歩いていて何かを見つけるということはある。しかしたいていの場合はそういう幸運には恵まれない。店が開いてから半年もたって気がつくということも多い。私たちは個人が発信す情報をる匿名化して処理し、ユーザーが関心を持ちそうな地域で何が起きているのかどんなトレンドなのかなのかをリアルタイムで把握できる」という。

アルゴリズムによって収集された情報は「フーディー・リスト」や「今週のトレンド」いったスタイルに整理され、ユーザーにどこに行ったらいいかを教えてくれる。Linによれば、フーディー・リストは匿名化された情報に基づくコホート分析により人々の短期的集散の状況を観察して得られるという。.ある店に新しく人が集まり始めたとすれば、、こうした動きは将来のトレンドの予兆となっていることが多い。一方、トレンド・リストはもっと長期の訪問者の増減を観察する。たとえば夏になるとアイスクリーム・パーラーを訪問する人口が増える、などだ。

Googleマップのニュースフィードではローカルニュースも分析の対象とする。

LinはFor youが目指しているのは大量の情報を集めることではなく「適切な情報をそれに興味を持つ人に適切なタイミングで配信する」ことだと強調した。

For youフィードにはAIテクノロジーをベースにした各種の高度な探索機能が実装される。たとえばマップはミシュランの星つきレストランのリストを作れる。またユーザーのいる場所、時間帯に応じて、たとえば「ファッショナブルなブランチ・スポット」を提案したりする。

新しいマップに予定されているもう一つの大きなアップデートはYour Matchだ。もしレストランその他を訪問する際に星つき口コミを調べたことがあればどの程度の情報が含まれるのか分かると思う。これに対して、新しいYour Matchは個人別の情報を加味してカスタマイズされた評価を示す。これにはユーザーの現在位置からの距離やユーザー自身の好みなどが反映される。

Googleマップにおけるユーザーの好みはマップの利用履歴の他に Googleマップの設定からマニュアルで入力もできるようになるはずだ。ただしユーザーと好みが似た人々によるある場所の評価は個別ユーザーにおけるカスタマイズには反映されないというのは興味ある点だ。

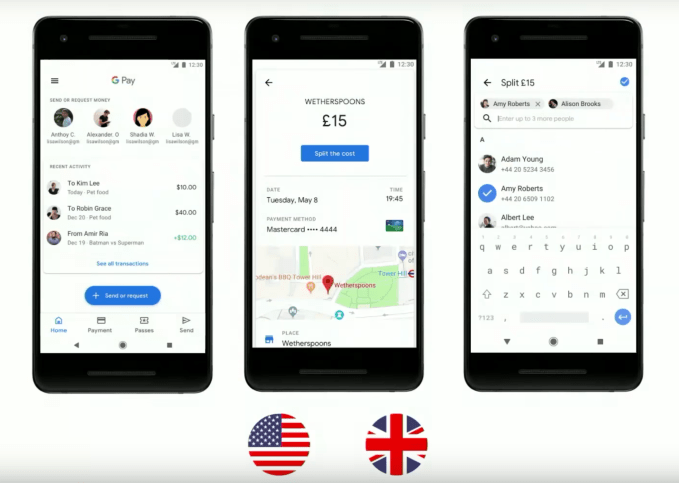

3番目の大きなアップデートではグループ・プランニングだ。デモを見た印象では、チームのツールとしてなかなかうまく作動していた。これはあるグループに対して簡単に提案や推薦ができる機能だ。グループというものの恋人とのディナーという場合でもよい。リストにある場所を長押しするとGoogleマップにチャットアプリのようなバブル形式のチャットヘッドが現れる。チャットヘッドはユーザーが他の場所を見てまわる間も表示が続く。候補先リストの作成を終えるとユーザーはリストを友達のグループなり恋人なりと共有できる。他のメンバーは自分の好みの場所を選んで投票すればよい。

Googleは新しいマップを夏の終わり頃に一般向けにリリースする予定だ。iOS版、Android版双方が準備されているが、どちらが先になるかはまだ決まっていない。当面新機能はすべてウェブ版ではなくモバイル・アプリ向けとなる。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)