500 Startupsと多くのエンジェル投資家が支援している、まだステルス状態の顔認識スタートアップTrueface.aiが、IFTTTとの統合により、デベロッパーたちが同社の技術をいろいろ試せるようにしている。

CEOのShaun Mooreによると、IFTTTとの統合により初めて、同社の顔認識技術が、複雑なコードを理解する必要なく、多くの人が利用できるようになる、という。

同社は最初、ハードウェアとソフトウェアのベンダーだったが、2017年にハードウェアの取り扱いをやめて、ソフトウェアにフォーカスするようになった。

“われわれ自身がもっと幅広いアプローチを取ることによって、ハードウェアのデベロッパーが自分のやりたいことをできるようになる、と考えた”、とMooreは語る。

Trueface.aiが今集中しているデジタルの認識確認技術は、たとえば誰かが銀行の口座を開こうとするときの本人確認や、公証事務のデジタル化などに応用できる。しかも、“本人性や所有権の確認をリモートでできるようになる”。

その目標は、顔認識技術を誰でも使えるようにすることだ。そしてそのための第一歩が、IFTTTの統合だ。それによってデベロッパーやメイカーたちの知名度を上げることができる、とMooreは考えている。

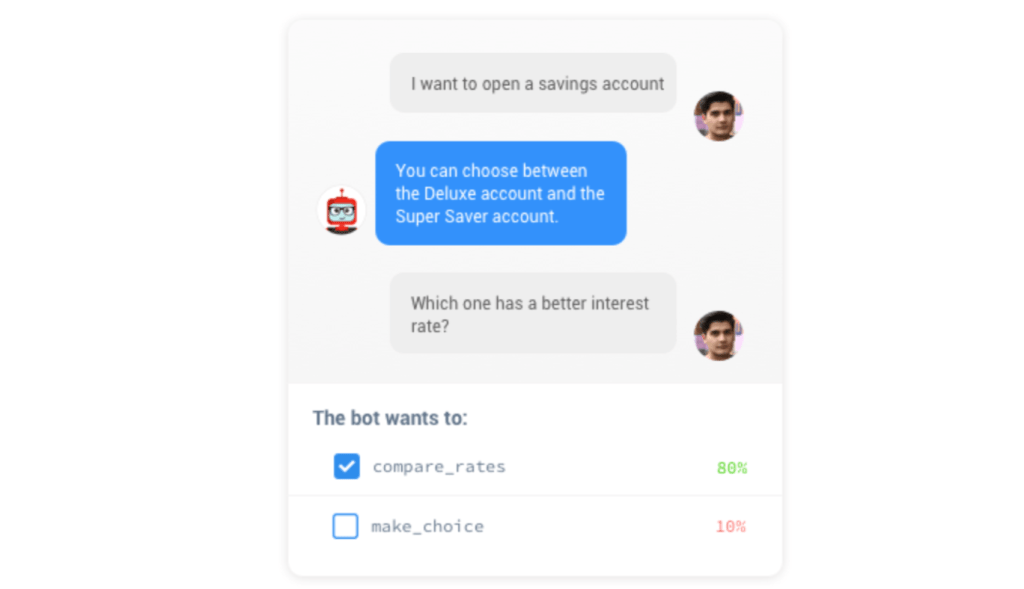

“これ(IFTTTの統合)は、一般的にサードパーティがうちの技術を利用するときの、ひとつの形だと思う。たとえばスマートロックのLockitronがあれば、Truefaceが来客の顔を認識し、その判定に基づいてIFTTTがドアをアンロックする”。

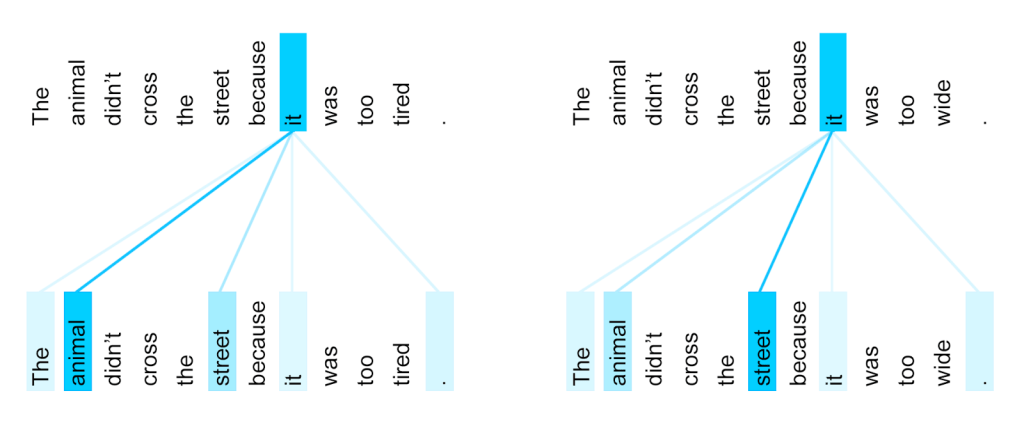

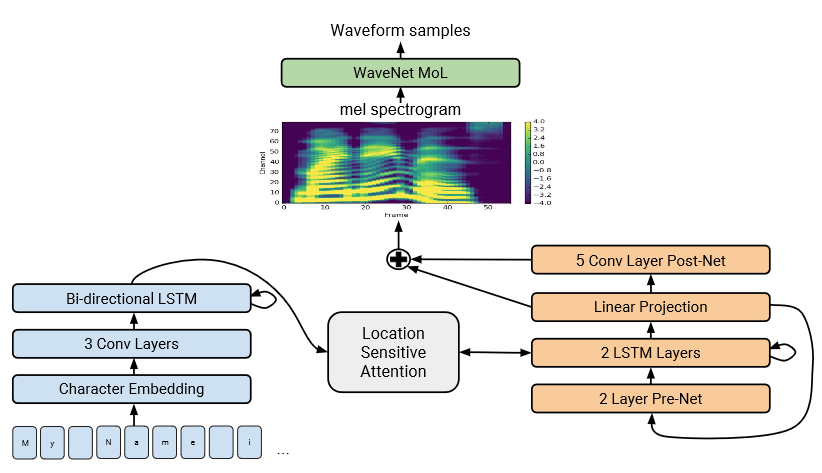

その顔認識に使われる技術は、今やおなじみのディープラーニングだ。ソフトウェア専門で行く、と決める前のTrueface.aiは、本誌TechCrunchのニューヨークオフィスにやってきて、その前身的技術であるChuiをデモしたことがある(下のビデオ)。

その機械学習のモデルは、数百万もの顔の画像で訓練され、そしてユースケースによっては、人間の顔の数学的表現を生成することもできる(これを数学用語で埋め込み(mbedding)と言う)。

埋め込みを保存しておくと、他のモデルが本人性の推断に利用できる。同社のモデルは、生きた本人でなく、本人の顔写真でシステムを騙そうとしても騙せないようにできている。スマホのロック画面なんか、もうだめだからね。

IFTTTの統合とともに同社は、そのIDVerifyプロダクトによって同社の技術にユーザーを慣れさせようとしている。

すでに同社の技術は150か国以上の本人性証明ドキュメントと互換性があり、それらをTrueface.aiのWebアプリケーションやモバイルアプリケーションで利用できる。

Mooreは曰く、“何かを自分で作ることの好きな人たちも、うちの技術の立派なユーザーだ、と考えているよ”。

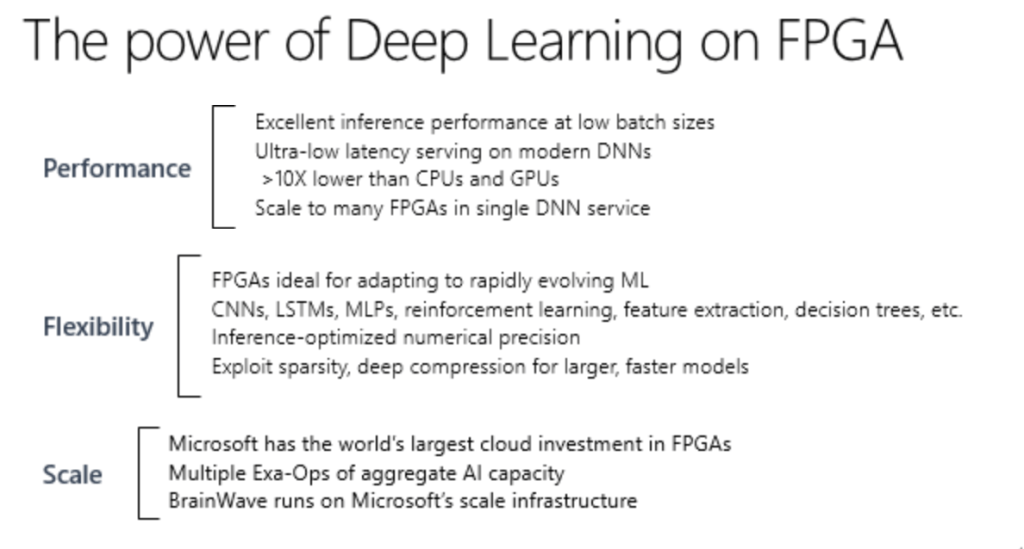

LeapMindは、高い処理能力や高電力を前提としたこれまでのディープラーニング(深層学習)とは違い、小さなコンピューティングリソースでも動くような計算処理を圧縮した独自モデルの開発を行うスタートアップだ。

LeapMindは、高い処理能力や高電力を前提としたこれまでのディープラーニング(深層学習)とは違い、小さなコンピューティングリソースでも動くような計算処理を圧縮した独自モデルの開発を行うスタートアップだ。

LeepMindは今回調達した資金を利用して、「ソフトウェアとハードウェアの両領域におけるソリューションの研究開発、またそれに伴う世界中からの優秀な従業員の雇用、さらには海外を含めた事業開発/営業基盤の拡大に充当する予定」だとしている。

LeepMindは今回調達した資金を利用して、「ソフトウェアとハードウェアの両領域におけるソリューションの研究開発、またそれに伴う世界中からの優秀な従業員の雇用、さらには海外を含めた事業開発/営業基盤の拡大に充当する予定」だとしている。