Microsoft(マイクロソフト)の新しいレポートによれば、音声アシスタントのユーザーの41%がデバイスが常時聞き取り状態にあることに関連してプライバシーやデータ保護の信頼性に不安を抱いているという。

Google、Amazon、Apple、 Samsung、Microsoftなどの有力企業が揃って消費者向け音声アシスタントデバイスのメインストリーム化に務めている現在、こうしたデバイスのデータ収集方法について懸念を抱くのは正しい態度だ。

しかし多くの消費者がこの点について正しい知識を持っていないように思える。Amazonのエンジニアが世界のユーザーがAlexaに入力した音声コマンドをモニターしているというBloomberg(ブルームバーグ)の最近の報道は消費者に懸念を抱かせた。しかもこうした人工知能を利用したスマートデバイスはメーカーやその外注企業の社員がモニターできるだけなく、入手した個人情報を違法に利用し、刑事事件にまで発展した例さえあった。電源がオンになっているかぎり聞き耳を立ているスマートスピーカーは笑いごとではすまないような重大なプライバシーの侵害を起こす可能性が充分ある。

米国時間4月25日、BloombergはAmazonのAlexaチームによるプライバシー侵害の危険性に関して次のように新たな報道を行った。

レポートによれば、Alexaが聞き取った音声データにアクセス可能なAmazon社員はデバイスの位置情報、場合によっては正確な住所も得られるという。これは音声データに緯度経度の座標が付属しているためだ。音声クリップをGoogleマップにペーストして簡単にデータが得られた場所を知ることができる。 Bloombergは「こうした位置情報を含むデータにアクセスできるAmazon社員の人数は不明」だとしている。

これは歴然たるプライバシーの侵害であり、我々がAmazon Echo、ひいては同種の音声アシスタントに対して抱く不信感を実証するものだ。

音声アシスタントのユーザーはバックエンド処理にどれほど人間が関与している正確に知ることはできない。しかしMicrosoftのレポートを読めば、デジタルアシスタント利用している消費者はデバイスが持つプライバシーの侵害やデータの不正利用などの危険性について強い不安を抱いていることがわかる。

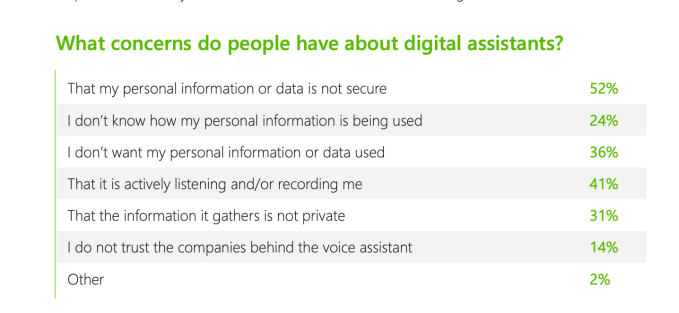

例えば、Microsoftの調査対象の52%は入力された情報のセキュリティーに不安を感じている。24%は情報がどのよう利用されているのかわからないと考え、36%はどんな目的だろうと個人情報を一切利用して欲しくないと考えている。

こうした数字はデジタルアシスタントには個人情報の収集と利用から永続的にオプトアウトできる分かりやすい仕組みが必須だということを示している。 つまり1回クリックするだけで「デバイスが収集した個人情報が外に出ることはなく、かつ人間がアクセスすることはない」ように設定できなくてはいけない。

41%のユーザーは音声アシスタントがユーザーの音声に聞き耳を立て録音していることに不安を感じている。31%は収集された情報にプライバシーは保証されていないと考えている。

さらに14%はプライバシーやセキュリティーの点で音声アシスタント・サービスを信用していない。つまりAmazon、Google、その他の企業はこの点で信用されていないわけだ。Microsoftのレポートはこう警告している。

新しいテクノロジーデバイスに関する消費者からのフィードバックに不安に真剣に対応することはデベロッパーに課せられた責務だ。消費者が安心してデバイスと音声で対話できる未来を実現するために必要な信頼の基礎を今すぐ築き始めねばならない。

調査はプライバシーに関して音声アシスタントに消費者が不信感を抱いているものの、全員が音声アシスタントの利用に拒否反応を持っているわけではないことも示している。たとえばEchoに音声でAmazonの商品を注文する際、商品配送するために役立つなら住所データを利用するのは構わないと考えるユーザーも多い。確実にメリットがあるなら住所以外でも個人情報を提供していいと答えたユーザーも存在する。

消費者は全体としてはキーボードやタッチスクリーンより音声入力を好んでいる。音声アシスタントの普及はま だ初期段階だが、 57%のユーザーが(プライバシーなどの懸念はあるにせよ)、音声をお気に入りの入力方法だとしている。また37%は他の入力方法と併用して音声入力も用いると答えた。

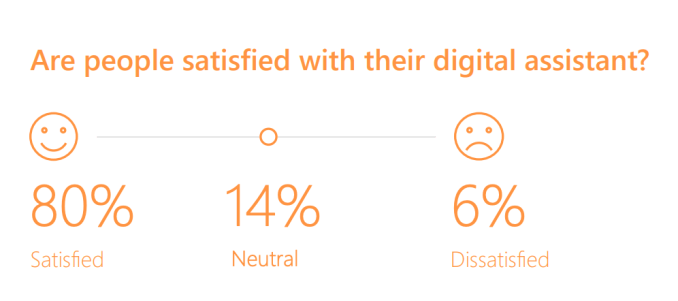

「どちらかといえば」から「大いに」まで程度はさまざまだが、80%のユーザーがデジタルアシスタントに満足しており、「週に1度以上使う」ユーザーは66%、「毎日使う」は19%だった(これには音声以外のスマートアシスタント全般を含む)。

こうした高い満足度をみれば、音声を含むデジタルアシスタントが市場から消えるということは考えにくい。いかしプライバシーの侵害や不正利用の可能性は普及の大きな妨げになるだろうし、あるプロダクトの信頼性が高ければ、信頼性の低いブランドからの乗り換えを促すことも考えられる。

もしAmazonなどが社員が消費者の音声情報にアクセスすることを厳格に制限できず、Appleがリリースした製品がそれと同等の価格でプライバシーが良好に守られるとするなら、ここでもAppleが大きなシェアを得ることになるかもしれない。

音声アシスタントと音声認識テクノロジーのトレンドを含むMicrosoftのレポートの全文はこちら。

[原文へ]

(翻訳:滑川海彦@Facebook)