今日(米国時間12/11)、Googleは新しい写真アプリ3種類をリリースした。これはGoogleが実行中のモバイル写真テクノロジーを改革する「アプスペリメント」(アプリ+エクスペリメント、のつもらしい)の一環だという。アプリはAppleのApp StoreとGoogle Playの双方または一方で公開されている。 Google Researchブログの記事によれば 、同社は今後もユーザーの声を聞きながらさらにモバイル写真における実験的機能のテストを進めていくという。

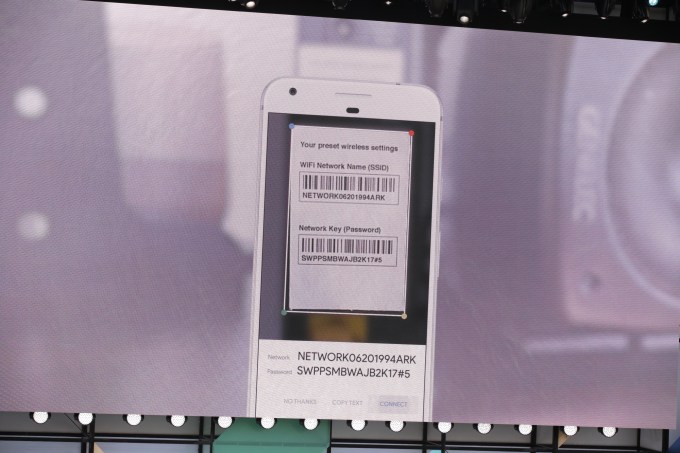

発表されたアプリはGoogleが開発中の対象認識や人物の分類に関するアルゴリズムをテストするためのもので、画像の適切なエンコード/デコードを効率化するテクノロジーを含むという。

今回リリースされた3本のアプリはそれぞれStoryboard、Selfissimo!、Scrubbiesと呼ばれる。

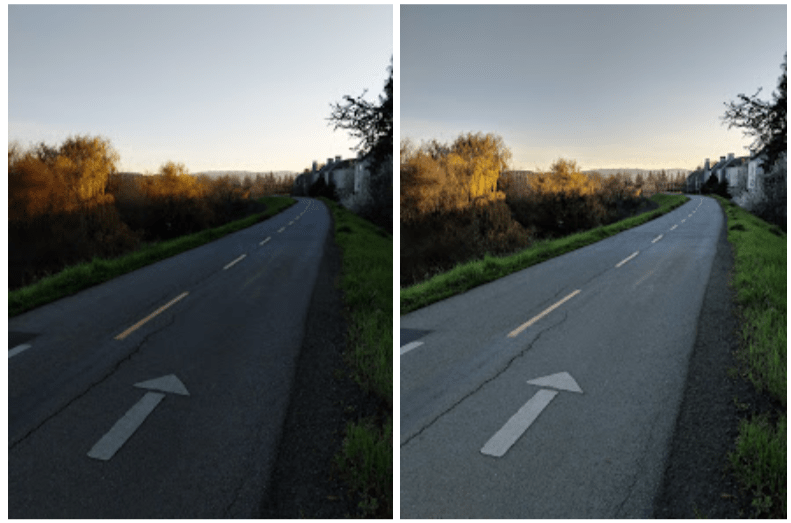

Storyboardはその名のとおり、ビデオクリップを1ページの絵コンテにまとめる。レイアウトはコミックのスタイルだ。写真をコンピューターで解析し、コミック・スタイルのイラストを作成するという手法はAIを利用した写真編集アプリ、Prismaの登場とともにポピュラーになった。Prisma社はその後ターゲットをB2B分野にシフトしているが、写真アプリは現在もApp Storeの「写真とビデオ」ジャンルでトップ150位以内にランクインしている。

ただこの分野への関心は現在やや薄れているか感がある。今回のGoogleのアプリのように、創造性をビデオの分野にもたらすことはこの分野の復活のきっかけになるかもしれない。

Storyboardは写真とアートの融合というテクノロジーをビデオに拡張したものだ。1枚の写真からコミック風のイラストを作成する代わりにビデオクリップから重要なフレームを抽出して一連のイラストを作成し、絵コンテに仕上げる。ビジュアルのスタイルは6種類から選べるという。.

Storyboardは今のところAndroid版のみだ。

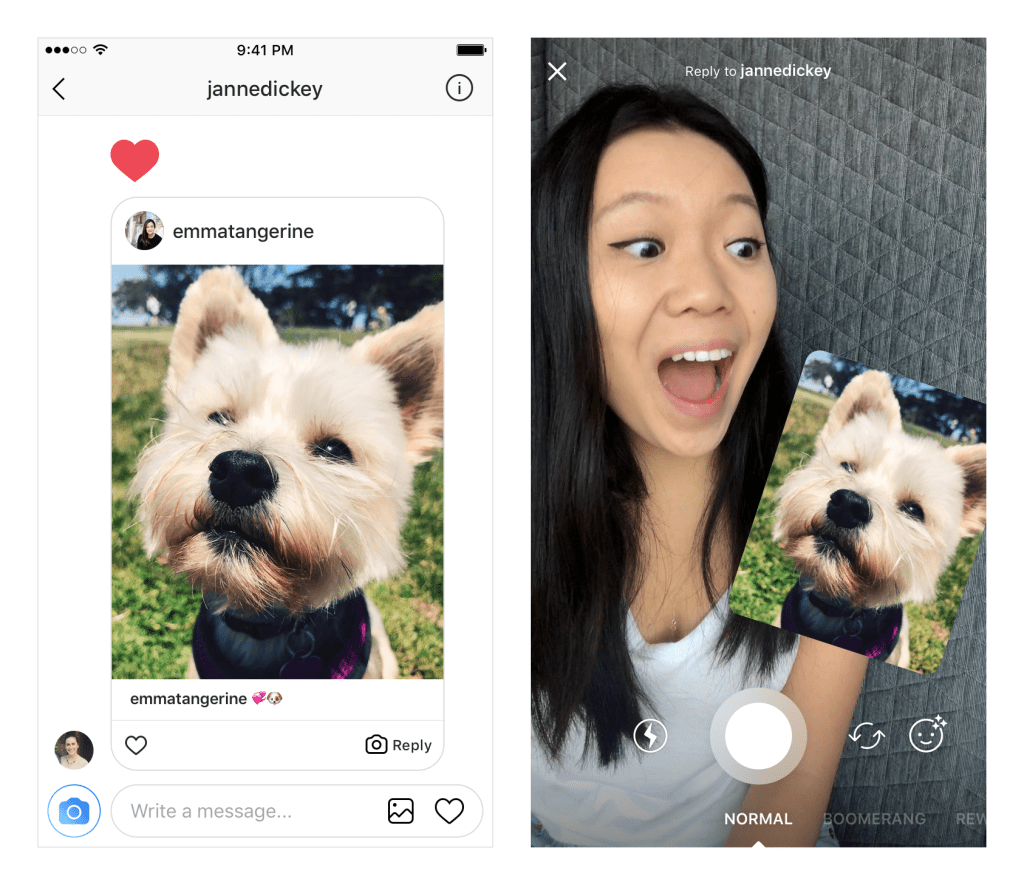

2番目のアプリ、Selfissimo!は新しいタイプのセルフィー写真を作成する。

Selfissimo!を起動してセルフィーを撮ると、ユーザーが動きを止めるたびにシャッターが切られる。つまり一連のポーズを撮影した白黒写真のベタ焼きができあがる。ユーザーが静止してポーズを取ると自動的に撮影が行われるわけだ(しかし…モノクロだけというのはしょぼい。カラー写真も撮れるようにして欲しい)。

Selfissimo!はiOS版とAndroid版の双方が提供される。

3番目のアプリ、Scrubbiesはビデオの新しいコントロールだ。 このアプリを使うとビデオ再生のスピードや再生方向の逆転を直感的に操作し、短いループビデオを作成できる。再生が循環するループビデオを作成するアプリにはInstagramのBoomerangなどがあるが、Scrubbiesはこれと違い、既存のビデオクリップから直接ループビデオを作成できる。いわばCDやビニールレコードからリミックスを作るのと同じような感覚だ。Googleはこれを「ビデオをDJのようにスクラッチする」と表現している。1本の指でスワイプすると通常の再生が行われるが、2本の指を使うとその部分がキャプチャーされ、後で友達に公開することができる。

ScrubbiesはiOS版のみだ。

Googleは以前にも写真分野で実験的アプリを発表してきた。

GoogleのエンジニアはMotion StillsでiOSのライブビデオの手ブレ防止を試みている。またAndroidビデオにさまざまな効果を与えるアプリも提供してきた。こうしたアプリで実験されたテクノロジーの一部はその後、Google Photosアプリの機能として取り込まれている。

今回リリースされたアプリが好評なら、その機能はやがて主流のGoogle Photosにも採用される可能性があるわけだ。

今回発表された3つのアプリは新しい写真テクノロジーの実験、「アプスペリメント」アプリの一環で、Googleでは「今後同種のアプリが多数お目見えするはず」だとしている。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)