オンデマンド倉庫(実際のピックアップとデリバリーを行ってくれる荷物保管サービス)のスタートアップOmniは、お気に入りのアイテムに、クローゼット内のスペースを占めることなく簡単にアクセスできるようにするサービスだ。しかし、同社は今、そうしたアイテムを友人たちや、ローカルコミュニティのなかで共有できるようにするための、大きな一歩を踏み出そうとしている。

Omniだけがオンデマンド倉庫マーケットのプレイヤーではない。Clutter 、MakeSpace、Troveといった企業も、こうしたサービスをオンラインで提供している。しかし、Omniが他の倉庫スタートアップと差別化を図ろうとしている点は、アイテムレベルの分類と、ユーザーの持ち物への個別のアクセスの提供だ。

あなたが持ち物をOmniに保管すると、それは単に倉庫のどこかの埃を被った箱やケースの中にしまい込まれるのではない。同社は、ユーザーはモバイルアプリで管理できるように、受け取ったアイテムをそれぞれ写真をとり、識別タグを付け、カテゴリーに分け、在庫として保管する。ユーザーは、少なくとも2時間前に同社に通知すれば、いつでも倉庫からアイテムを取り出すことが可能だ。

このことで、週末にサーフィンや自転車やゴルフを楽しみたいOmniのユーザーは、スポーツ用具を不要な間は倉庫に預けておき、必要なときに取り出すことが可能になる。しかし、今や同社は、ある程度以上のアイテムを集めることができたので、今度はアイテムを預けているユーザーたちに、それらを友人たちやローカルコミュニティの中で、共有して使えるようにさせたいと思っている。

「私たちが立ち上げようとしているのは、アイテムのオーナーが、その持ち物を友人たちやローカルコミュニティに対して共有できる機能です」こう語るのはOmniのプロダクトVPであるRyan Delkである。立ち上げ以来18ヶ月で10万点以上の品物を集めたOmniにとって、これはもともと計画されていた内容なのだ。

「私たちは倉庫業という姿を、トロイの木馬のような見せかけの姿として位置付けていました」とDelkは私に語った。彼によれば、Omniが今回のサービスを実現できたのは「すべてがアイテムレベルで起こる」からだ。

振り返ってみれば、その計画はおそらく明らかだったはずだ。結局のところ、なぜわざわざ倉庫保管用のアイテムをピックアップして、個別にタグをつけカテゴリーに分け、品物のクラウドデータベースに登録するといった手間をかけていたのだろうか?もちろんユーザーが個別のアイテムに対して何かをすることができるようにだ。

Omniではユーザーは1ヶ月あたり、小物なら50セント、大きい品物はら3ドルで保管することができる。またユーザーがどれほど素早く在庫中の品物にアクセスしたいかによって、ピックアップとデリバリーの費用が変化する。本当に急ぐ(3時間以下)場合でない限り、品物のピックアップは無料だ。反対にアイテムを配達して貰う際には、翌日配達で3ドル、2時間以内の配達を指定すると20ドルが必要となる。

ビジネスの経済性を考えると、Omniで保管するものは、地元のセルフ保管倉庫で使っているような、箱に放り込んでお終いという種類のものではない。Omniでは独自の分類に基づき、商品の29%は「家庭用品と工具」に分類され、25%がアパレルに、そしてスポーツやレクリエーションが全商品の13%を占めていると語る。

-

request-flow.png

-

item-availability.png

-

accept-flow.png

-

search-flow.png

-

friend-management.png

これら3つのカテゴリーだけで、Omniユーザーが手持ちの電動工具を隣人に使わせたり、友人にイベント用ドレスを貸したり、キャンプその他のアウトドア用品を共有したりという用途が想像可能だろう。

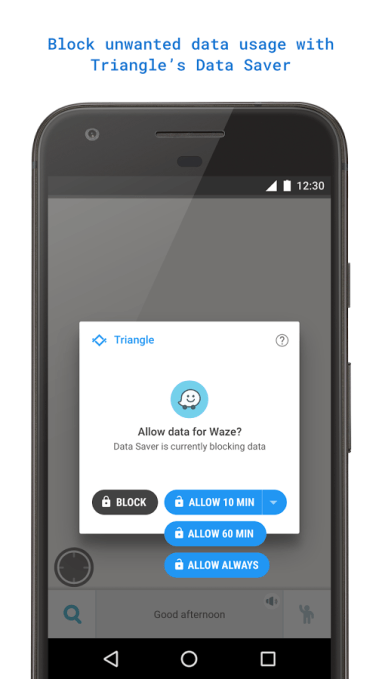

Omniは既にこのコンセプトを、ベイエリアの限られた数のベータユーザーに対してテストしており、これから一般公開をしようとしているところだ。ユーザーが保管したすべてのアイテムは、デフォルトではプライベートになるが、もし友人たちと共有したり、コミュニティで利用可能にしたいと思った時には、今や簡単にそれを行うことができる。

もしここまで読んで、まだ先も読むつもりなら神の祝福を。このサービスがこの先狙っているところを次に説明したい。Omniは単純な「借り入れ」と「貸し出し」からこのサービスを開始する。しかし考えてみて欲しい…ここからユーザーが普段使っていないものをレンタルしてお金を稼ぐまではほんの1歩に過ぎない。そうなったらOmniはそこから手数料を抜けば良い。

実際Delkは、友人や隣人からアイテムを借りるときにピアツーピアのVenmoまたはPayPal支払いを使ってシステムに取り込み、すでにこのようなことを行っているユーザーがいることを認めている。そして同社が、既にプラットフォーム上で起こっているこうした商取引の一部を、どれほど取り込みたいと思っているかを想像することもできるだろう。

とはいえ、それはいつの日かやってくる別のアップデートの話だ。Omniは、こうしたものが人びとが本当に求めているものであることを、証明していかなければならない。そして時間と支持だけがそれを証明する。また数ヶ月後に戻ってきて、その時このシステムがどのように運営されているかをチェックしてみたい。

[ 原文へ ]

(翻訳:Sako)