元裁判官であり家族法の教育者でもある人物が、テクノロジー起業家とチームを組んで、あるアプリを開発した。離婚した親同士がその共同養育(コペアレンティング)上の問題点や、コミュニケーション、共有カレンダーその他の意思決定を一つのプラットフォームの上で解決できるようにすることが願いだ。coParenterという名のこのアプリは、競合他社のものよりも包括的であることを目指しているが、AI技術を活用し、難度の高い状況にはオンデマンドで人間による対応を行うことも組み合わせている。

coParenterのアイデアは、共同創業者であるシェリル・A・エルスワース氏の個人的経験と、自分自身も離婚を経験した起業家であるジョナサン・ヴァーク氏から生み出された。

エルスワース氏はカリフォルニア州リバーサイド郡の上位裁判所の裁判長を20年務め、家族法の教育者として10年のキャリアを持っている。こうした歳月の中で、彼女は多くの家庭が、現在の法体系の中でどのように破壊されたかに直接触れてきたのだ。

「私は無数の家族たちが、家族法制度の中で苦労を重ねるうちに、ばらばらになっていった様子を目撃したのです。家族がいかに簡単な意見の相違で争うのかを見て来ました。例えば彼らの子供は、どの学校に行くべきか、どの医者にかかるべきなのか、そしてどのような食事を与えられるべきなのかなどなど、そうした問題は本来家庭に属するべき問題であって、法廷にはふさわしくないのです」と彼女は語る。

エルスワース氏はまた、法廷で訴えられた意見の不一致の8割が、法の介入など必要とはしないものだったことを指摘している。

法曹職のキャリアが終わりに近付くにつれて、彼女は法体系がこうした状況に対応できるように作られていないことを認識しはじめたのである。

そんなとき彼女が出会ったのが、かつてはShazamの戦略パートナシップ担当上級役員であり、現在はcoParenterのCEOを務めるジョナサン・ヴァーク氏である。ヴァーク氏はちょうど離婚したばかりであり、共同養育プロセスをより苦痛の少ないものにするために、どのように技術を使うことができるかについてのアイデアを温めていたところだったのだ。彼は既に、長年の友人であり連続企業家のエリック・ワイス氏(現COO)に、システム構築の協力を仰いでいた。しかし、彼はまた、法的専門知識を持った人物も必要としていた。

これがcoParenterの生まれた経緯である。

CTOのニールス・ハンセン氏によって開発されたこのアプリは、共同養育プロセスの様々な側面のために開発された、他のアプリたちと共存する形で存在している。

そうした他のアプリとして名前が挙げられるものは、OurFamilyWizard、Talking Parents、AppClose、そしてDivvito Messengerなどの、コミュニケーションを文書化するように設計されたアプリ;Custody Connection、Custody X Exchange、そしてAlimentorなどの、カレンダー共有アプリ;そして各種の機能を組み合わせたWeParent、2houses、SmartCoparent、そしてFayrなどのアプリである。

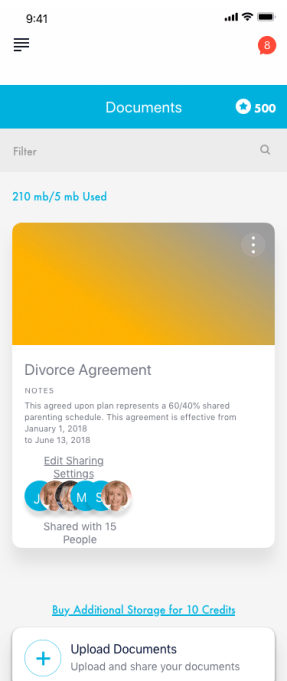

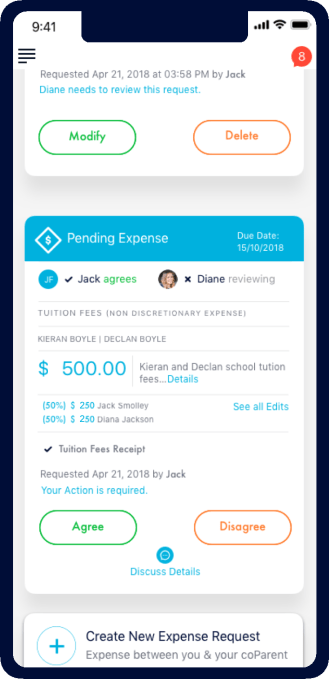

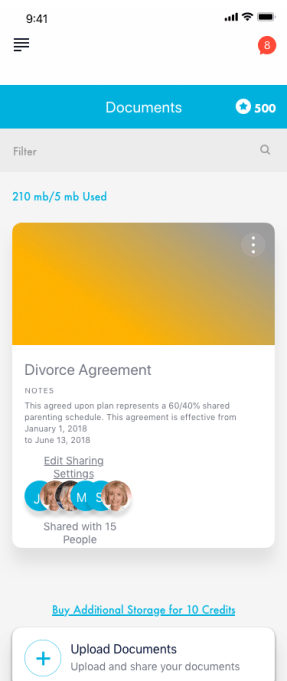

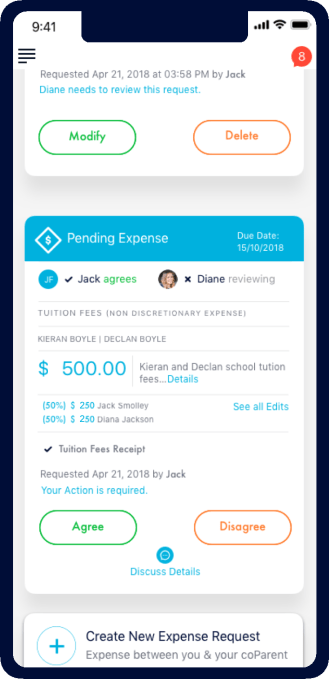

だがcoParenterのチームは、彼らのアプリは共同養育のためのあらゆる側面をカバーすると主張している。例えばコミュニケーション、ドキュメンテーション、カレンダーとスケジュールの共有、送迎記録のための位置情報ベースツール、経費の追跡と返金、スケジュール変更依頼、そして例えば散髪、食事、小遣い、メディアの利用などの細々とした日常的な親の意思決定を支援するツールなどだ。

またcoParenterは「ひとりモード」も提供することが特徴だ。つまりもう一方の親が同じことをすることを拒んだ場合でも、このアプリを使うことができるということだ。これは多くのライバルアプリに欠けている重要な機能である。

しかし最大の差別化要因は、coParenterがあなたのポケットの中に一種の調停者を置くやり方である。

アプリはお互いの会話を丁重なものに保つために、AI、機械学習、そして感情分析技術を使うことから始まる。この技術は、激しい会話がエスカレートすることを防ぐために、呪うような言葉、炎上を招くフレーズ、攻撃的な呼び名の利用に対して介入を行う。

もし会話が良くない方向に進む場合には、アプリは利用者(親)に対して、本当にその言葉を使いたいかどうかを問いかける警告メッセージをポップアップ表示する。そのことによって少し立ち止まり考える時間を与える(他のソーシャルメディアプラットフォームたちが、こんな機能を提供してくれてさえいれば!)。

もし両親がより多くの支援を必要とするときには、彼らは弁護士に連絡する代わりに、アプリを使うことを選ぶことができる。

同社はプロフェッショナルへのオンデマンドアクセスを、月ごと(月額12.99ドル、20クレジット。2回分の調停に十分な額)あるいは年ごと(年額119.99、240クレジット)のサブスクリプションで提供している。どちらの親も、年額199.99ドルでサブスクリプションを行うことができ、それぞれ240クレジットを受け取ることができる。

「これに比べますと、弁護士にたった一つの申し立てを依頼するだけでも、通常は平均250ドルから最高500ドルを支払う必要があります」とエルスワース氏は語る。

ここで相談できるプロフェッショナルたちは、調停者ではないが、それぞれの専門分野で資格を保有する人たちである。多くは家族法の弁護士、セラピスト、ソーシャルワーカー、または紛争解決の長い経歴を持つ退職した判事だ。エルスワースはプロフェッショナルたちが、親たちに適切なガイダンスを与えているかを監督する。

親とプロフェッショナルの間のやりとりはすべて機密扱いとされており、証拠扱いされるような発言として扱われることはない、なぜなら目標は法廷の外にとどまることだからだ。ただし、両親が最終的に法廷に紛争を持ち込んだ場合には、アプリのあらゆる場所に保存された履歴や文書を、法廷で使用することができる。

このアプリは1年近くベータ版として用いられてきたが、今年1月に正式に開始された。これまでに、coParenterは、すでに4000以上の紛争の解決を助け、2000人以上の共同養育親がスケジューリングのためにアプリを使用していると主張している。実際、もめている親たちの81%が、全ての課題を、プロの調停者や法律専門家の力を借りることなくアプリの中で解決していると同社は述べている。

CoParenterはiOSとAndroidの両方で利用可能である。

[原文へ]

(翻訳:sako)

米国時間3月18日、NVIDIA GTC 2019で、同社は驚きの画像作成機能を発表した。それは、GAN(Generative Adversarial Network=敵対的生成ネットワーク)を利用したもので、このソフトウェアのユーザーは、ほんの数クリックで写真のようにリアルな画像をスケッチすることができる。数本の線を、あっという間に麗しい山頂の夕日に変えてしまうのだ。これこそAI世代のMS Paintだ。

米国時間3月18日、NVIDIA GTC 2019で、同社は驚きの画像作成機能を発表した。それは、GAN(Generative Adversarial Network=敵対的生成ネットワーク)を利用したもので、このソフトウェアのユーザーは、ほんの数クリックで写真のようにリアルな画像をスケッチすることができる。数本の線を、あっという間に麗しい山頂の夕日に変えてしまうのだ。これこそAI世代のMS Paintだ。

恋愛・婚活マッチングサービスに興味はあっても、登録するのが面倒、どんな写真を投稿していいかわからないといったユーザーは多いはず。「

恋愛・婚活マッチングサービスに興味はあっても、登録するのが面倒、どんな写真を投稿していいかわからないといったユーザーは多いはず。「

この研究のペーパーの共著者Grant Hamilton博士が、

この研究のペーパーの共著者Grant Hamilton博士が、 赤外線画像(左)と関心領域を高輝度にするニューラルネットワークの出力

赤外線画像(左)と関心領域を高輝度にするニューラルネットワークの出力