機械学習アプリケーションのためのデータセットを作り、管理し、メンテナンスするLabelboxが、新たな投資ラウンドで1000万ドルを調達した。

そのリード投資家Gradient Venturesは、GoogleのAI専門のベンチャーファンドだ。これに、前からの投資家Kleiner Perkins、First Round Capital、エンジェル投資家のSumon Sadhuが参加した。

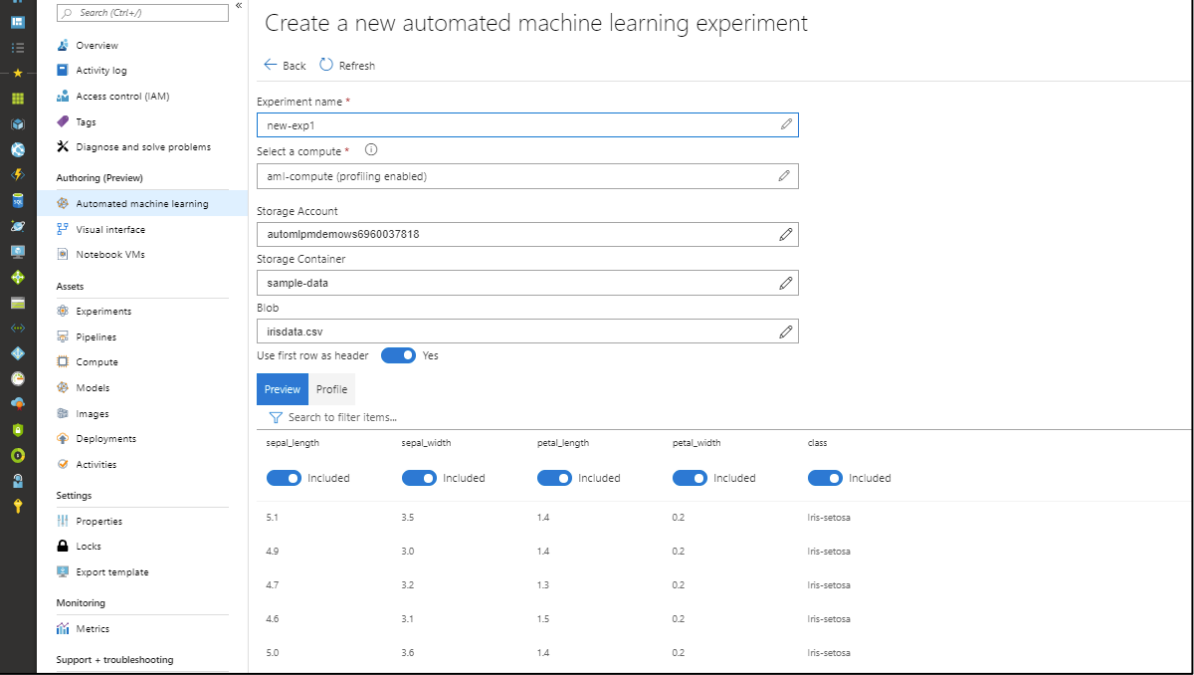

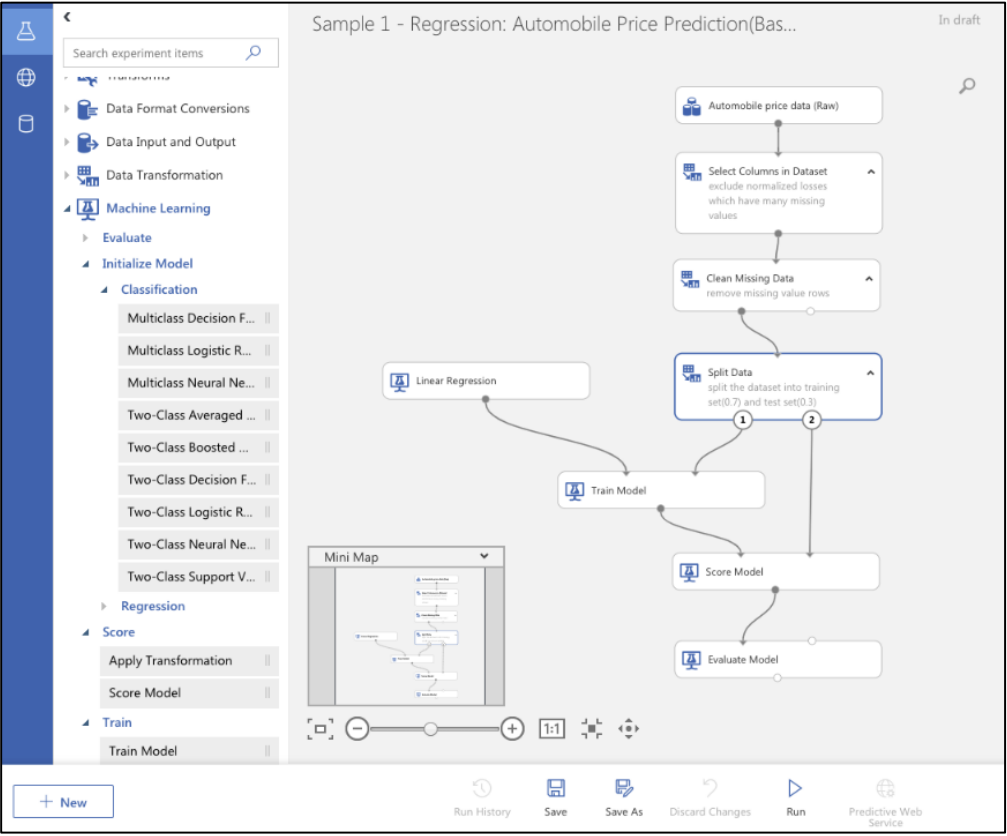

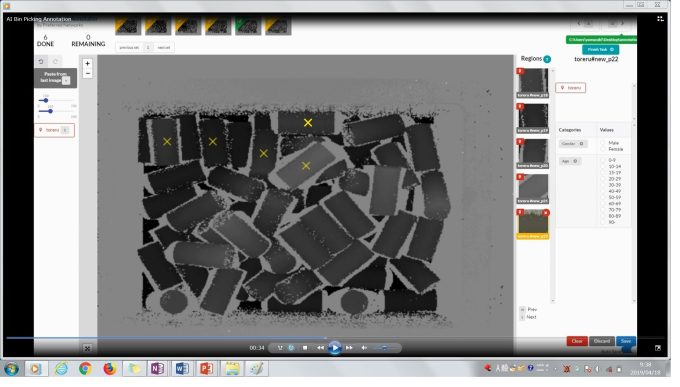

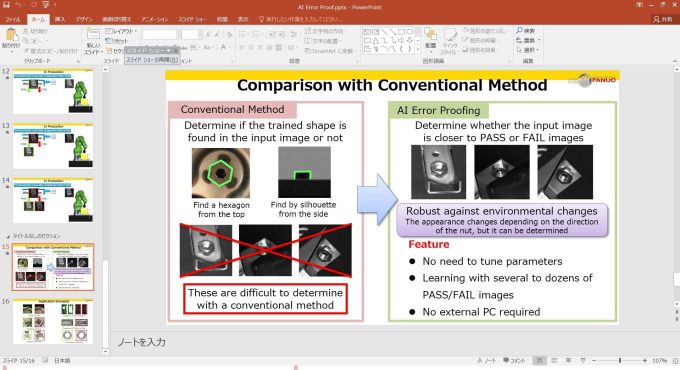

Labelboxは、データのラベリングをアウトソーシングする過程を管理し、企業や団体に彼らが集めるデータを管理し、データのクォリティーを確保するためのツールキットを提供する。同社CEO Manu Sharma氏はそう説明してくれた。

CEOのSharmaとCTOのDan Rasmuson、そしてCOOのBrian RiegerらLabelboxのファウンダーたちにとっては、彼らが開発したツールは前に社員として勤めていたDroneDeployやPlanet Labs、Boeingなどで必要性を痛感していたサービスの実現だ。

今回得た資金は、社員を現在の11名から22名に増やして営業とマーケティングのチームを作ることに充てたい、という。

Labelboxの現在の顧客はおよそ50社で、課金は彼らがアップロードするデータの量と利用するサービスの種類に基づいて行われる、名前を挙げてもよい顧客は、FLIR Systems、Lytx、Airbus、Genius Sports、KeepTruckinなどだ。

Labelboxが昨年ステルスを脱したとき本誌も報じたように、同社のツールキットは誰でも無料で使える。利用量が一定の閾値を超えたときのみ、課金される。たとえばLytxは、ドライブレコーダーDriveCamのためにLabelboxを利用している。すでに50万台のトラックにインストールされているそのカメラはAIを使って危険運転を検出するので、その能力は訓練によってアップする。またメディアと出版の大手企業Conde Nastは、ランウェイ上のファッションを同社のコンテンツアーカイブにあるファッションと関連付けるためにLabelboxを利用している。

Sharma氏が声明文の中で言っている。「Labelboxはモデルの開発時間を大幅に減らし、データサイエンティストたちが自力ですばらしい機械学習アプリケーションを作れるようになる。新たな資金でデータラベリングのインフラストラクチャをさらに強化して、機械学習のチームに強力なオートメーションとコラボレーションとエンタープライズ級の機能を提供していきたい」。

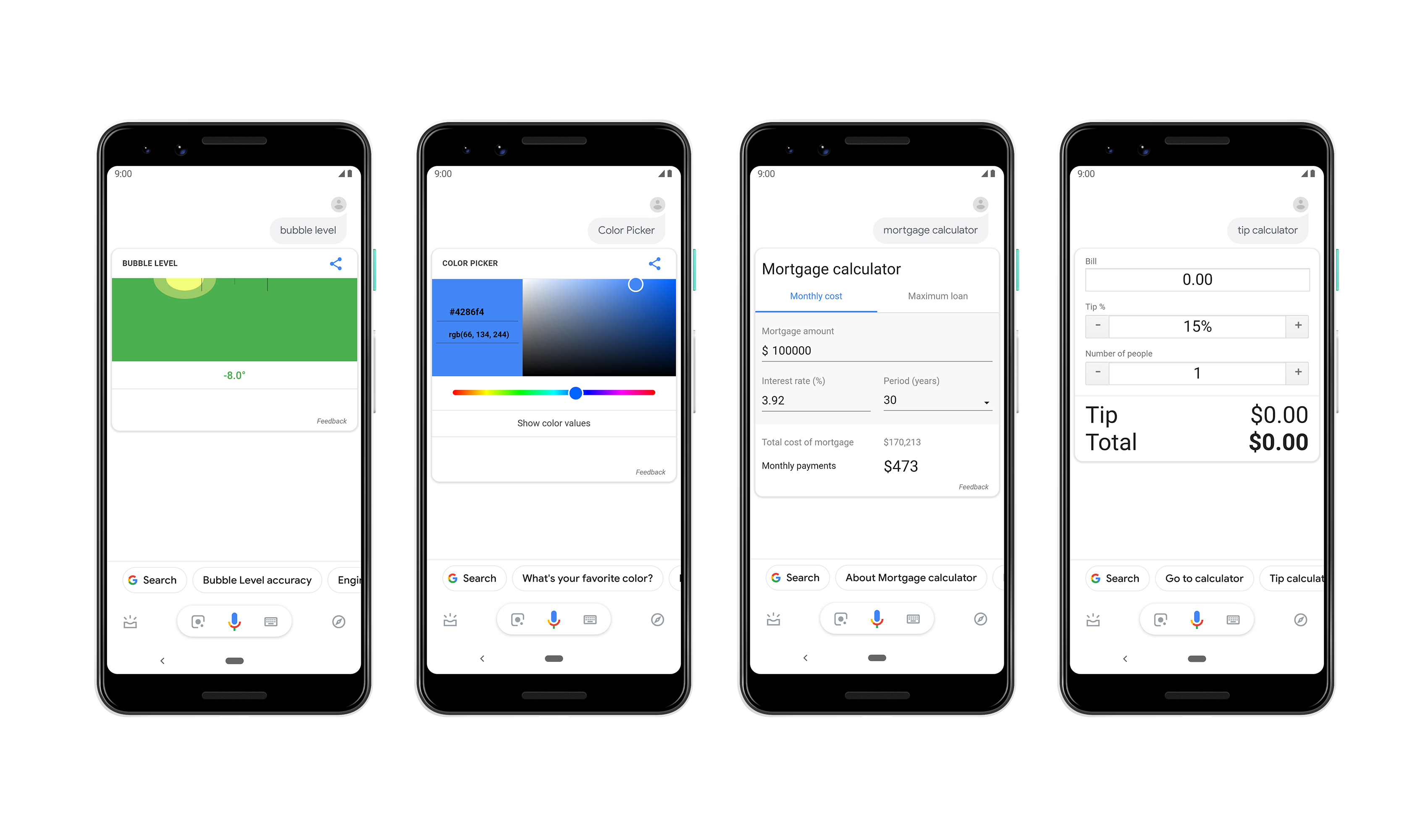

Gradient Venturesはこの技術に投資したいと思うほどの関心を持ち、機械学習のツールの開発をグローバルにサポートしていける同社の能力に将来性を見出している。

Gradient VenturesのファウンダーでマネージングパートナーのAnna Patterson氏はこう言っている。「Labelboxは機械学習を製造業、運輸交通業、ヘルスケアなどさまざまな分野にわたって産業化していける位置にいる。そうすることによって同社は、AIのポテンシャルを全世界の企業に向けて開放するだろう」。

[原文へ]

(翻訳:iwatani(a.k.a. hiwa)