今や、最新のソフトウェアの開発、展開、管理の方法を主導していくために、オープンソースプロジェクトがこれまで以上に大きな役割を果たすようになっている。例えばコンテナのためにはKubernetesがあり、エンタープライズ規模のインフラ運用のためにはOpenStackがあるといった具合だ。しかしここ数年の間に、Cluod Foundryという名のまた別のプラットフォームが、企業が内外のサービスを開発する方法を変えてきた。

Cloud Foundryは「サービスとしてのプラットフォーム」(PaaS)に分類されるもので、OpenStackのような「サービスとしてのインフラストラクチャ」(IaaS)とは区別される。Cloud Foundryが目指しているのは、インフラストラクチャを運用するという厄介な作業やデータベースのようなより高度なサービスを抽象化して、開発者にアプリケーションを書くための単一のプラットフォームを提供することだ。

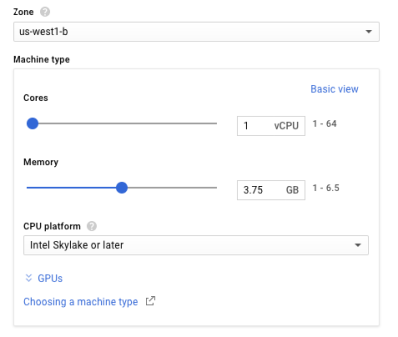

ここでの前提は、Cloud Foundryの下にあるものを、開発者が気にする必要はないということだ。たとえばそれはオンプレミスのOpenStackクラウドかもしれないし、AWS、Google Cloud Platform、IBM Bluemix、Azureなどのパブリッククラウドかもしれない。これは、企業がアプリケーションをあるクラウドから別のクラウドに移動させる(または複数のクラウドを同時に使用する)能力を得ることを意味する。もちろんその際に、それぞれのクラウド特質に合わせてコードを改変する必要はない。Cloud Foundry FoundationのCTOであるChip Childersによれば、プロジェクトの目標は開発者を幸せに(そして生産的に)することだ。

Cloud Foundryの歴史は、当初の開発者VMwareが最初のバージョンをリリースした2011年に始まるが、2015年以降はLinux Foundationの助けを借りてプロジェクトを推進している(CFとLFとの提携が行われたのは正確には2014年12月)。その提携以前にもプロジェクトは成功していたものの、以降は真に独自の成功を収めて来ている。Fortune 500社の半分が現在、何らかの形でCloud Foundryを利用している。

企業の変化はゆっくりで、しばしば沢山の古いソフトウェアを維持しなければならないために、完全に移行した例はまだ多くないが、現在多くの企業が新しいソフトウェアの全てをCloud Foundryの上に構築している最中だ。最大手のユーザーでも、Cloud Foundryで実行しているアプリケーションはおそらく10%程度に過ぎないが、将来はこのプラトッフォームに賭けられている。

「多くの人たちがその方向に集中しています」と、Cloud Foundry財団のエグゼクティブエディタであるAbby Kearnsは語った。「多くの企業にとって、デジタルトランスフォーメーションはまだ初期段階ですが、企業の変革には通常7〜8年かかると考えられていますし、その中には更に時間がかかるものもあるでしょう」。

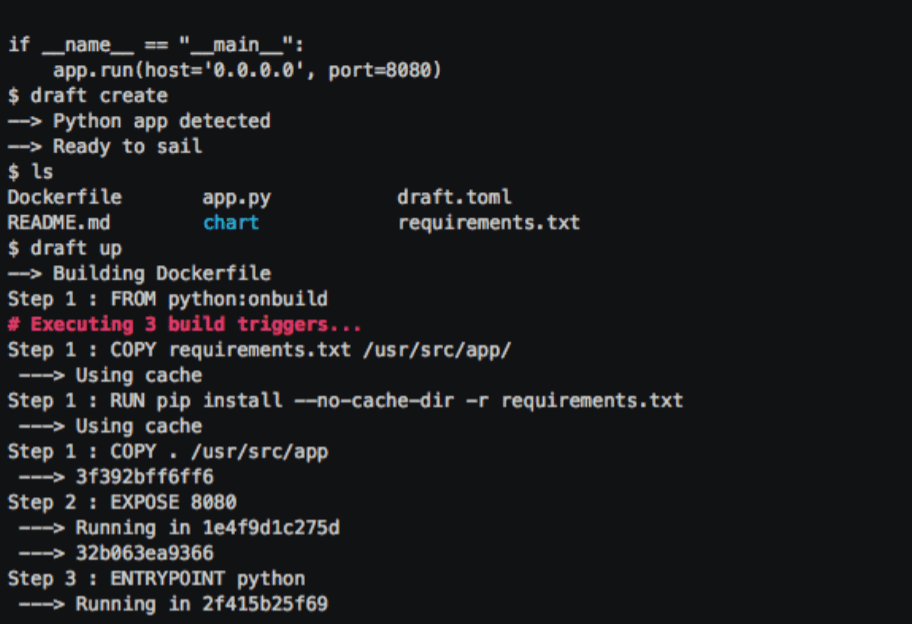

会社の従業員たちによる切り替えを簡単にするために、Cloud Foundryでは従業員たち自らがが選択した言語で記述することが可能だ。「Cloud Foundryの目標は、開発者の手に多くの自由を戻し、自ら開発が可能になるようにすることです。そのためには邪魔になるものを減らして行きますが、同時に十分なガードレールも与えます」。

さらに、財団は現在、そのプラットフォームとクラウドネイティブ開発パターンの両方を、一般的に利用する開発者を養成する認定プログラムを提供している。

先週、Cloud Foundryは年次開発者会議を主催したが、その講演者の顔ぶれは、Allstate and Liberty Mutualから、Ford、Home Depot、Google、Microsoft、SAP、IBM、そして独自のサービスを現在これらの企業に提供している多くのスタートアップたちに及んだ。これらの企業はすべてCloud Foundry財団のメンバーであり、Google、Microsoft、IBM、SAP、VMware、Cisco、DellEMC、Pivotalといった顔ぶれがこのプロジェクトを構築するためにここに集まっているのは時代を象徴している。

MicrosoftとGoogleが参加するこのラインナップに、明らかに欠落しているのはAWSクラウドのAmazonだ。彼らがすぐに参加してくるとは思わない。しかしながら、ユーザーたちはすでにAWS上にCloud Foundryをデプロイしはじめているため、プラットフォームの進化に対して意見を言うことも大きな関心事になることだろう。

Childersが強調したように、このプロジェクトはオープンソースが主眼というよりも、共同の研究開発を狙ったものである。このことがプロジェクトの哲学を他のオープンソースプロジェクトとは少し異なるものとしている(ガバナンスモデルも他のLinux Foundationプロジェクトとは少し異なる)が、最終的な結果はとても似通ったものとなっている。

将来については、Childersは、財団は明らかに製品会社ではないため、そのロードマップはメンバーやさまざまなサブプロジェクトに非常に依存していると語る。全体の取り組みに関わる商用ベンダーたちはそれぞれのロードマップを持っているので、このプロジェクトが何処へ向かうのかを正確に予測することは困難だ。

例えば、現在エンタープライズ分野で囁かれる、多くの構想段階の概念の1つとして、サーバーレスコンピューティングがある。Cloud Foundry財団は、まだこの騒ぎには跳び乗っていない。Childersはその理由を、今年は企業たちが実際にそれに手をつけようとしていないためだと述べているが、やがてプロジェクトが実際に取り組むときが来るかもしれないことは認めている。「私たちは、エコシステムにイノベーションを導入したくなる、微妙な地点にいるのです」とChilders。「それを素直に押し出して『これには意味がある、世間には沢山の選択肢があるが、私たちはリリースするプラットフォームの全体の中にこれを取り込むことが正しいことだと考えている』と言える場合もあるでしょう。しかし私たちはそれが正しい答えだと言い切る準備はできていません。[…]私たちは目新しいものに飛びつくことはしません」。

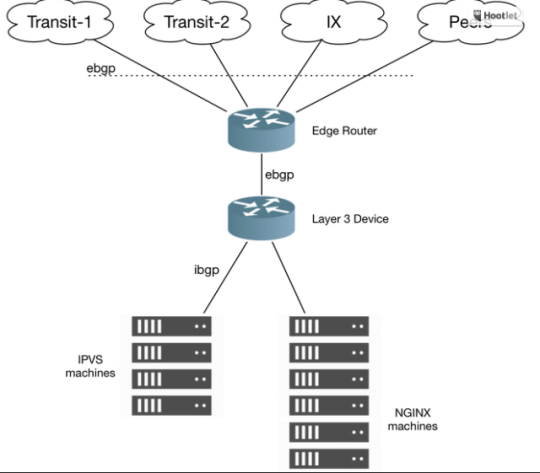

プロジェクトが積極的に検討しているのはユニカーネルだ。これは特に、DockerがUnikernel Systemsを買収したことで、ゆっくりと再浮上してきたコンセプトだ。またグループは、Cloud Foundryが、ネットワークのエッジ部分にさらに多くのコンピューティングパワーをもたらすためにどのように役割を果たすことができるかも検討している(コンピューティングをクラウドへ何年も集中してきた動きを思えば、興味深い転換だ)。

「イノベーションは難しいことです。私たちは、コミュニティとして、こうした問題に取り組んでいきます」とChilders。「実を結ぶこともあれば、そうでないときもあるでしょう」。Cloud Foundryは安定したコアを手に入れたため、この先の数ヶ月から数年の間にこうした探求の結果をより多く目にすることになるだろう。特に企業たちはただクラウドを一般的に活用するだけでなく、複数のクラウドベンダーからの最高のサービスを同時に活用できるようにしたいと願っているからだ。

[ 原文へ ]

(翻訳:Sako)