オンライン労働市場は、インターネットが登場した頃からずっと存在してきた。仕事を募集し、労働者を選択し、結果を確認し、支払いを行う。労働サービスを仲介する何十もの企業があり、こうした市場の台頭が、アメリカ人労働者の3分の1をフリーランサーへと促した大きな要因になっている。

簡単な作業のために個人労働者を見つけることは、現在オンラインでは一般的だが、複雑な作業を解決するためのチームを見つけて組織することは、また別の話だ。さまざまなスキルセット、タスク間の複雑な関係、プロジェクトに関わる組織内の記憶などが、インターネット上でのチームビルディングを、研究者たちやスタートアップたちにとって難しい課題にしている。

ニューヨークに拠点を置くB12は、フラッシュチーム(flash team)と呼ばれるコンセプトに関わる研究を用いて、同社の基盤技術であるOrchestraをオープンソースプロジェクトとして公開しつつ、チームベースの労働マーケットの課題を解決しようとしている。CEOのNitesh BantaとCTOのAdam Marcusの独創から生まれた同社は、Webサイト制作と管理を第一の軸として運営されている。

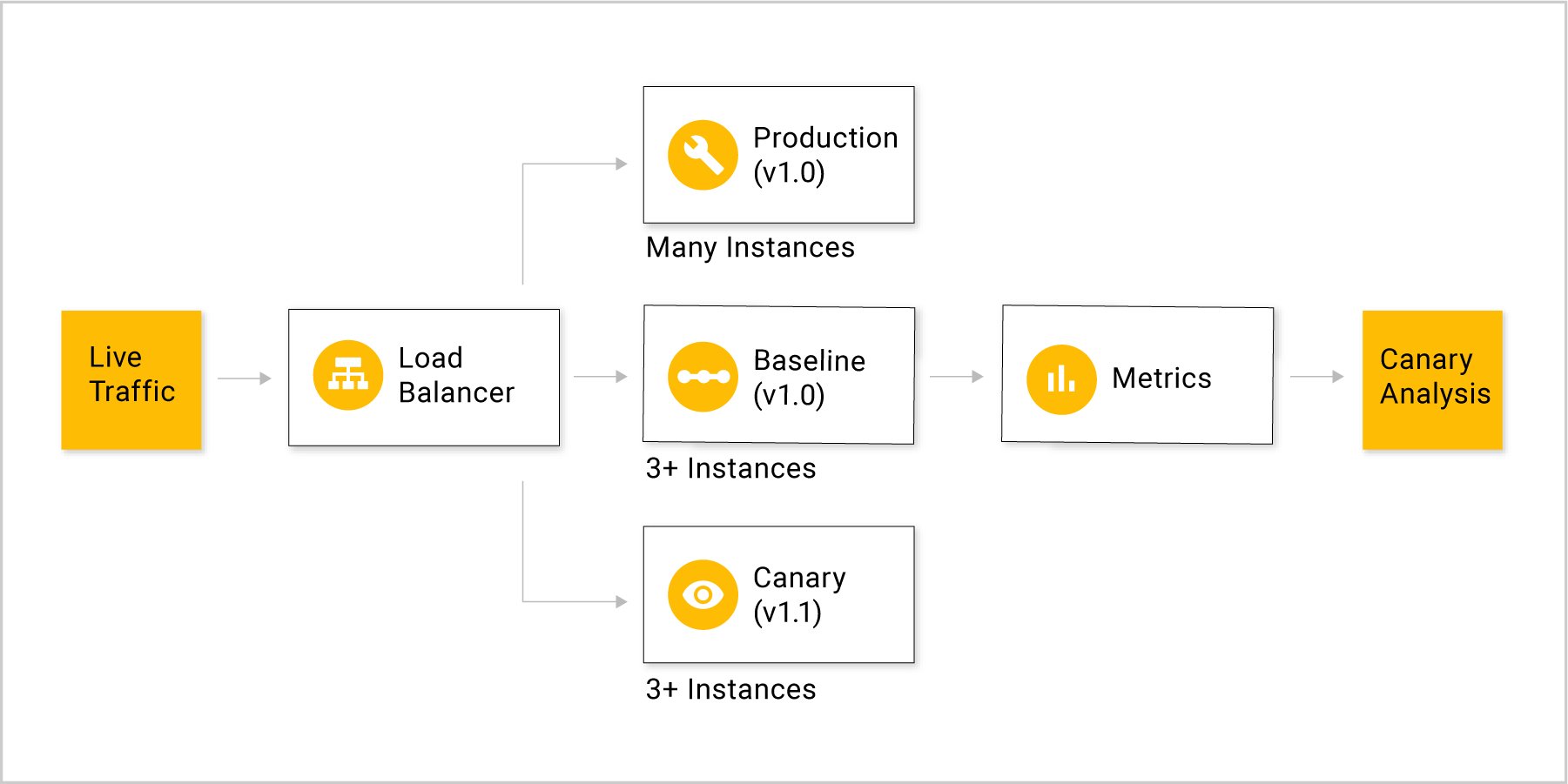

フラッシュチームの概念は、もともとスタンフォードHCIグループの、コンピュータサイエンス研究者のグループの研究に由来したものだ。2014年に出されたオリジナルの論文の目標は、アルゴリズムを使ったチームビルディングで、その中には専門家の評価、補完するスキルセットを持つチームの構成、そして仕事が満足の行く結果を生み出すことを保証するための組織的な振舞の扱いなどが含まれている。

たとえば、新しい家を建てることを考えてみよう。この場合、設計を行う建築家、構造を評価するエンジニア、それを建築する作業員たちが必要だ。これらは専門家の仕事である。建築家が自分のやっていることを正確に知っていなければ、プロジェクト全体に災厄が起こる可能性がある。また複雑さに加えて、仕事は線形なものではない。たとえばキッチンの完全な設計が完了する前でも、家の基礎工事は開始することができる。

フラッシュチームの中心にはいくつかの洞察がある。第1に、深い経験を持つ専門家が、専門分野での経験が少ない他の専門家たちを評価する必要があるということ。そのため、数多くのプロジェクトを経験した熟練建築家が、新しい建築家の腕を評価するための、最良の候補者となる。Marcusは「プラットフォーム上で全てをレビューすることはできませんが、行き当たりばったりではなく、どの部分に専門家の目を活用できるかを、分析して決定することができます」と説明する。

2番目に、プロジェクトはしばしば同様のパターンに従うので、新しいプロジェクトは既存の「足場」から始めることができるということである。「1つのメリットは、できるだけ多くのプロジェクト管理を自動化できることです」とMarcusは語る。「もう1つは、労働者が専門分野に集中できるように、可能な限りデザインの多くの部分を自動化できることです」。別の言葉で言えば、デザイナーは書類仕事を追いかける役人ではなく、デザイナーでなければならないということだ。

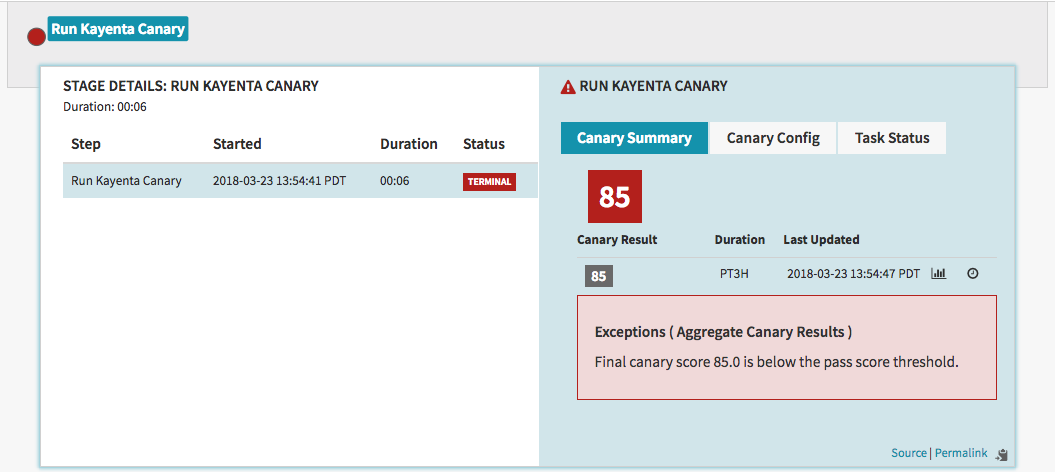

B12の第1の使命は、スタンフォードの研究を応用し、それを利用可能なソフトウェアライブラリの形にすることだった。Orchestra プラットフォームは、離散的なステップのワークフローを取り込み、その仕事を、階層的レビューを受けて評価された専門家たちに割り当てるようにデザインされている。このように、それは様々な複雑な作業工程に適用可能な柔軟なライブラリだ。同社はフラッシュチーム論文の第一著者であるDaniela Retelnyを、プロダクトディレクターとして雇用した。

B12は、アルゴリズム的アカウンタビリティへの関心とブラックボックス社会への懸念が高まっていることを踏まえ、Orchestraのオープンソース化に踏み切った。「コミュニティの誰でもが、フィードバックを送ることができるようにするためです」とMarcusは説明する。

そして、B12はそのシステムを立ち上げるために何らかの業界を選択する必要があり、その結果ウェブサイトの作成と管理に落ち着いたのだ。BantaとMarcusは、これまでのウェブデザインは、オンラインのDIYエディタと、フルサービスのコンサルタントの間での選択であったと説明した。そして彼らはDIYシステムの価格優位性を維持しながらも、よりカスタマイズ可能なものを提供したいのだ、と私に説明した。Bantaは「AIとオートメーションとスマートな人材を組み合わせて、ウェブサイトの作成をエンドツーエンドでリデザインすることができる」と考えているのだ。

既存のいくつかの「足場」を使用して、いくつかの基本的な質問に答えるだけで、すぐにB12を使ったビジネスウェブサイトの構築を開始することができる。それはソーシャルメディアプロファイルをスキャンし、既存の資産を取り込んで、特定のビジネスの流れに基づいて、既存の設計を利用し、プロセスを始めることができる。これにより、最も退屈な作業が大幅に削減され、専門家は作業の創造的側面に集中することができる。

「アルゴリズムを用いて生成されたウェブサイトを見ればすぐに、ユーザーたちは私たちに対して、そのウェブサイトに関して好きな点と嫌いな点を教えてくれます。そのあと Orchestra は、ユーザーのウェブサイトのために作業をしてくれる専門家のチームを集めることが可能です」とBantaは説明する。したがって、もしユーザーが異なるデザインやその他の機能を望む場合には、Orchestraは、そうした変更を行うための適切な専門家のためのタスクを起動するようにデザインされている。そしてウェブサイトが開設されたら、トラッフィクを最大化するために、B12は専門家によるサイトのレビューに基づいて定期的なSEOアップデートを提供する。完全自動化されたウェブサイトのデザインは無料で、プレミアムデザインは月額29ドルからだ。

専門家にとって、このシステムの利点は明らかだ。退屈な作業はアルゴリズムに置き換えられ、誰が何を担当するのかを調整するために何時間もSlackでやりとりをする必要もない。パフォーマンス評価も、担当した分野の他の専門家によって行われる。専門家の仕事の質を分析する特別な専門知識を持たない、ゼネラリストマネージャによってではない。アルゴリズムはこれまであなたが出会った中でも最高の上司かも知れない。

プラットフォームに参加するには、別の専門家によって評価されるスタータープロジェクトに取り組む必要がある。その最初のプロジェクトは、新しく参加した専門家のために最初の評価を提供するが、そこから、評判が向上するにつれて、Orchestraは徐々に、専門家に対してより困難で興味深い課題を割り当てるようになる。Marcusによれば、B12はこれまで1000人以上の専門家から申請を受け取り、そのうちの約3%を受け入れたと述べた。

現在同社は、ウェブサイトの構築だけに集中しているが、類似の業界にその技術を広げていく可能性については強く意識している。究極的には、同社の目指すゴールは、人間が人間らしくいられるようにするためのソフトウェアを構築することだ。「Orchestraのようなものがあることの利点は、単に人びとが専門性を発揮して働くことを楽しむだけでなく、チームと共に働く喜びのあるコミュニティを形成できることです」とMarcusは語る。

B12はGeneral Catalyst、Breyer Capital、Founder Collective、SV Angelから1240万ドルを調達した。

[原文へ]

(翻訳:sako)

FEATURED IMAGE: LAURA LEZZA/GETTY IMAGES