今週はお金が余っているという方、2台目のブガッティを買う代わりにこのほぼ新品のEnigma Machine(エニグマ暗号機)はどうだろう? 第二次世界大戦で連合国を苦しめたこのデバイスは、そもそも売りに出されること自体が珍しい。しかも、実際に戦争で使われたのにこれほど状態が良いのは、過去に聞いたこともない。

Enigmaをめぐるさまざまな奇譚伝説も面白いが、ここで紹介するには長すぎる。簡単に言うと、これらのマシンはほとんど解読不能のコードを作り出し、ナチスは連合国側に通信を傍受されていても秘密の通話ができた。しかし英国のブレッチリー・パークにいた、有名なアラン・チューリング(Alan Turing)を筆頭とする数学者たちとそのほかの分野の専門家たちはEnigmaのコードの解読に成功し、戦争の流れを変えた。これら暗号科学の歴史に関心のある読者には、チューリングの伝記やSimon Singh氏のThe Code Book(邦訳:新潮文庫「暗号解読(上/下)」)をお勧めしたい。

連合軍にマシンを盗まれることを恐れたドイツ軍は、すべてのEnigmaを破壊するよう命じた。そして終戦時には当時の英首相ウィンストン・チャーチルが、残っているEnigmaをすべて破壊せよと命じたが、多くが個人蒐集家の手の中へ逃げてしまったので、今回のようにオークションに登場することもある。わずか数百台が現存していると想定されているが、このような悪名がつきまとう古器物は、正確な推計が不可能だ。

それでもこのマシンは第二次世界大戦の戦火をくぐって生き延び、無傷であるだけでなくオリジナルの回転子も無事だ。その入れ代え方式のローターは、特殊な回転により、テキストを再現不能な形に撹乱する。内部の電球も、切れていたのは一つだけだった。ただし、当然ながら電池はだめだ。でも、これよりもさらに状態のいいEnigmaがほしい人は、もしあったとしても長年待たなければならないだろう。

当然これは、こういうもののお金持ちの蒐集家にとって計り知れない価値を持つだろうし(善意の蒐集家であることを祈りたいが)、戦争や暗号の博物館もこれをぜひ欲しいだろう。Enigmaの秘密はかなり前に解明されているし、懐中時計型の複製もある。でも本物のマシンを見ると、その精巧さに心を打たれるし、今でもまだ、新しい発見と驚きがある。

このEnigmaのオークションは、5月30日にNate D Sanders Auctionsで20万ドル(約2190万円)から始まる。それは10年前の10倍だから、状態のいいこのマシンが以前のオークションより安いことは、ありえない。初値を(20万ドル)相当上回る額で落ちることは、ほぼ確実だ。

画像クレジット: Nate D Sanders Auctions

[原文へ]

(翻訳:iwatani、a.k.a. hiwa)

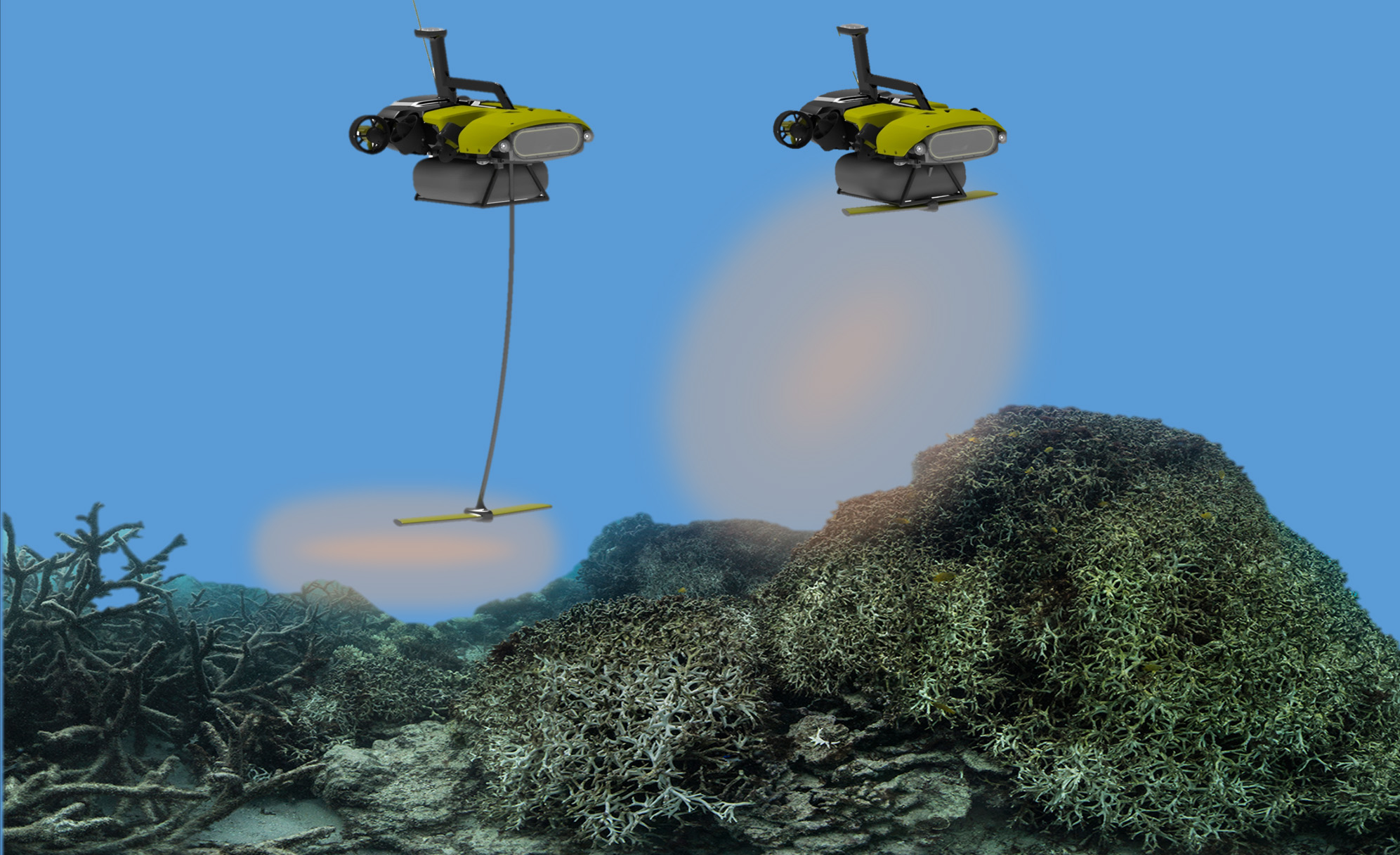

この研究のペーパーの共著者Grant Hamilton博士が、

この研究のペーパーの共著者Grant Hamilton博士が、 赤外線画像(左)と関心領域を高輝度にするニューラルネットワークの出力

赤外線画像(左)と関心領域を高輝度にするニューラルネットワークの出力