近くのスターバックスやTargetストアへの道順を教えることはAppleのバーチャルアシスタントが得意とするところだ。しかし、Siriは自分が聞いたことのない地元の店を別のフレーズやユーザーの言い間違えと誤解することがある。Appleはこれを解決するために、Siriの知らない超ローカルな名前のライブラリを作り、”Godfather’s Pizza” を ”got father’s piece” と聞き違えないようにする。

音声認識システムは膨大な量のデータを使って訓練する必要があるが、それによって文の解析やフレーズ認識の能力は高まるものの、ユーザーや友達がいつも使っている語彙を理解できるとは限らない。

私が友人に向かって “let’s go to St. John’s for a drink” と言えば、彼らは私が中西部の大聖堂ではなく、近くのバーを指していると理解する。しかしSiriにはそれを知る術がない——それどころか “St. John’s” がひとつのフレーズであることを認識できなければ、私がまったく別のことを言ったと思うかもしれない。入力ボックスにテキストをタイプするのとは違い——あれは文字列の一致をみるだけ——Siriはユーザーの発した音声から最善の予測をしなくてはならない。

しかし、もしSiriがシアトル地域のことを知っていれば、誰かが “St. John’s” と言えばバーのことだろうとわかるので、苦労して考えたり聖人(saint)の候補リストから選んだりすることなく、すばやく正確に反応できる。それがAppleの最新研究の結果だ。今は英語のみだが、多言語への対応も時間の問題だろう。

このためにAppleの音声認識チームは、Appleマップのローカル検索結果を使って「関心のある場所」を取り出した。人は場所を探すとき「いちばん近くの~」や「~への道順は?」などと聞くので識別できる。

こうした関心のある場所は、Taco Bellなどの全国チェーンを除けば地域に特化した場所を表す。シアトルのハンバーガー好きなら、一番近くにあるDick’s Drive-inを調べるだろう(実際にはどこにあるか知っているが)。ロサンゼルスなら、もちろんIn-N-Outだ。しかしピッツバーグの人はどちらも探すことはない。

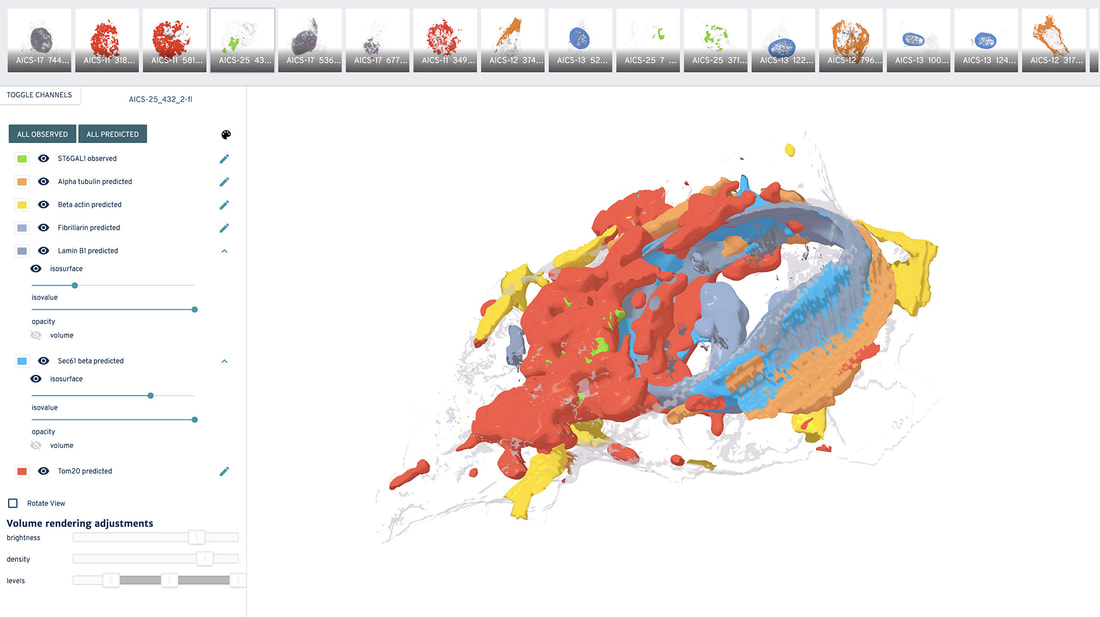

Appleはこの地域情報を、米国国勢調査局が定義した169の「大都市統計地域」に分けた。これらの地域に特化した店などの名称は、Siri が使う主要な言語モデル(LM)ではなく、ユーザーが関心のある場所を探すフレーズ(「いちばん近い~はどこ?」や「~への道順は?」など)を使ったときに用いる小さな補助モデル(Geo-LM)に登録される。

このため、”who is Machiavelli” と言ったときには、人名のMachiavelliに関する答えが返ってくるが、” is Machiaveli’s” と言えば、システムはGeo-LMを使って地元の関心スポットリストにMachiavelli’sが載っているかどうかを調べる。こうしてSiriは、マキャヴェリ氏が投獄されていた場所ではなく、レストランへの道順を答えるべきだとわかる。

こうすることで、最大25~30%だったエラー率は10~15%へと大幅に減少した。これは3回中2回しか正しい結果が得られなかったものが、10回中8~9回になることを意味している。Siriが繰り返しユーザーの欲しいものを理解できなくて、使うのを諦めてしまうことを防ぐ可能性のある質的改善だ。

この方法のすばらしいところは、比較的容易に多言語にも拡張できることだ。スペイン語でも韓国語でも、十分なデータさえあれば使えない理由はない。その意味では、Siriが隠語の多い業界人向けに特化した語彙ライブラリーを作ってくれれば、スペリングエラーを減らすことができるだろう。

機能はすでに公開されているので、今すぐテストできるはずだ。あるいはすでに使っていて気づいていないだけかもしれない。

[原文へ]

(翻訳:Nob Takahashi / facebook )

Facebookの51%という数字は、2015年の71%から大きく後退している。当時はトップだった。51%という平均値がどの所得層も代表していないのは興味深い。高所得層の利用が36%なのに対して、低所得層の10代は70%が利用していると答えた。

Facebookの51%という数字は、2015年の71%から大きく後退している。当時はトップだった。51%という平均値がどの所得層も代表していないのは興味深い。高所得層の利用が36%なのに対して、低所得層の10代は70%が利用していると答えた。

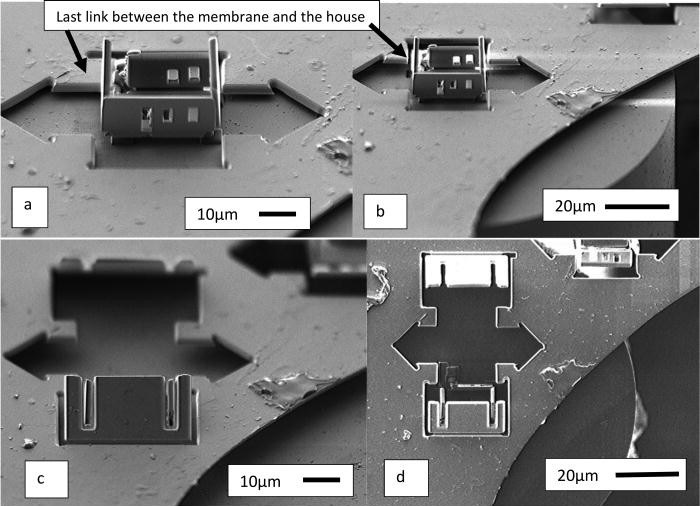

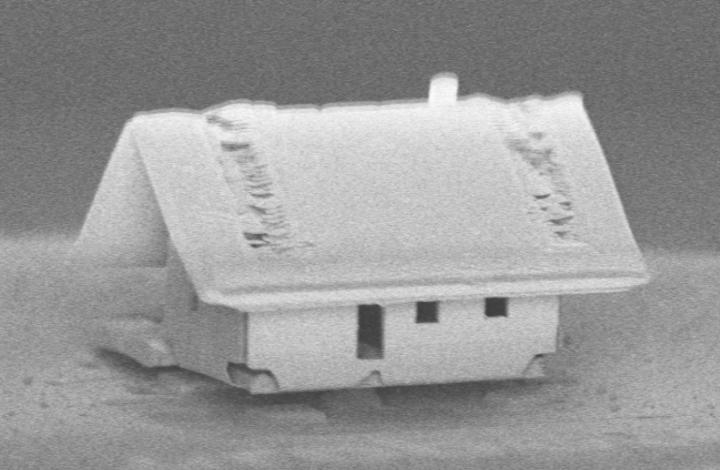

事前にCAD作業が行われ、ロボットは設計図に沿って、お互いぶつからないように気をつけて、ゆっくりとしかし効率的に作業する。

事前にCAD作業が行われ、ロボットは設計図に沿って、お互いぶつからないように気をつけて、ゆっくりとしかし効率的に作業する。