スイスのスタートアップAvriosは、企業が一人の人間に一台の車という従来の考えにとらわれず、状況に応じた移動方法を受け入れることにより、業務上の移動手段がもっと面白くなるはずだと考えている。

また、内燃機関からグリーンな代替動力への切り替えを加速することで、進歩的という評価を得たいと企業が考えるようになると同時に、新しい都市型移動手段が数多く生まれ、個人輸送のための幅広いマルチモーダルな選択肢として顧客に提示できるようになった。したがって、従業員が使える車種の選択肢が少ない企業は、もう長くは存続できない、というのが彼らの主張だ。

しかし、バランスをとりながら選択肢を増やすことは、車両管理の業務をさらに難しいものにする恐れがある。なぜなら、供給業者(全体の数が増えて、小さな業者も多くなる)との交渉、コストと有用性の把握、輸送ソリューションを業務の目的や従業員の要求に合理的にマッチさせるといった作業が重なるからだと、Avriosは話している。そこで、ますます多様化する複雑な車両の管理作業においては、AIが鍵になる。

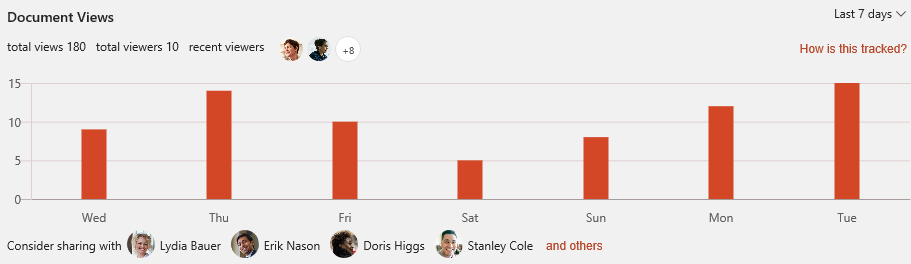

現段階では乗客輸送用車両と小型トラックに焦点を絞ったAvriosのプラットフォームは、ヨーロッパを中心とした、7万台ほどの車両を運用する700あまりの企業に採用されているが、すでに機械学習技術を導入し、車両のリース費用に関する情報を把握しつつ、車両管理業務を助けている。

しかしAvriosにとって、これはまだ基礎作りの段階だ。電気自動車の技術に人気が集まり、業務用車両にも電気自動車が導入され始めている今、同社はそのプラットフォームを、近く起きると想定される大転換に対応するものとして位置づけている。

都市圏における個人の移動手段が豊かに多様化する兆しは、配車サービスの大手Uberが電動バイクや電動スクーターに目をつけるといった行動から、すでに消費者サイドで見え始めている。

もちろんビジネスの側も、立ち遅れまいと考えている。そのため車両管理プラットフォームは、そうした新しい、きめ細かい移動手段に対応するべく挑戦を続けてゆく必要があると、AvriosのCEO、Andreas Brennerは話している。

2015年に設立されたスタートアップAvriosは、昨年、自社の顧客を対象に調査を行った結果、現在、ヨーロッパの企業がエンジン車両に費やしている年間予算は600億ユーロ(約7兆7300億円)あり、今後5年間で別の動力を利用した車両に移行すると見積もった。

この調査では、大半の企業(80パーセント)が、現在、スプレッドシートとAccessデータベースで、迫り来る移行に対処しようとしていることもわかった。そこでAvriosは、市場の大改革に適応できるよう、援助の機会を伺っている(主な競合相手はスプレッドシートになると同社は話している)。

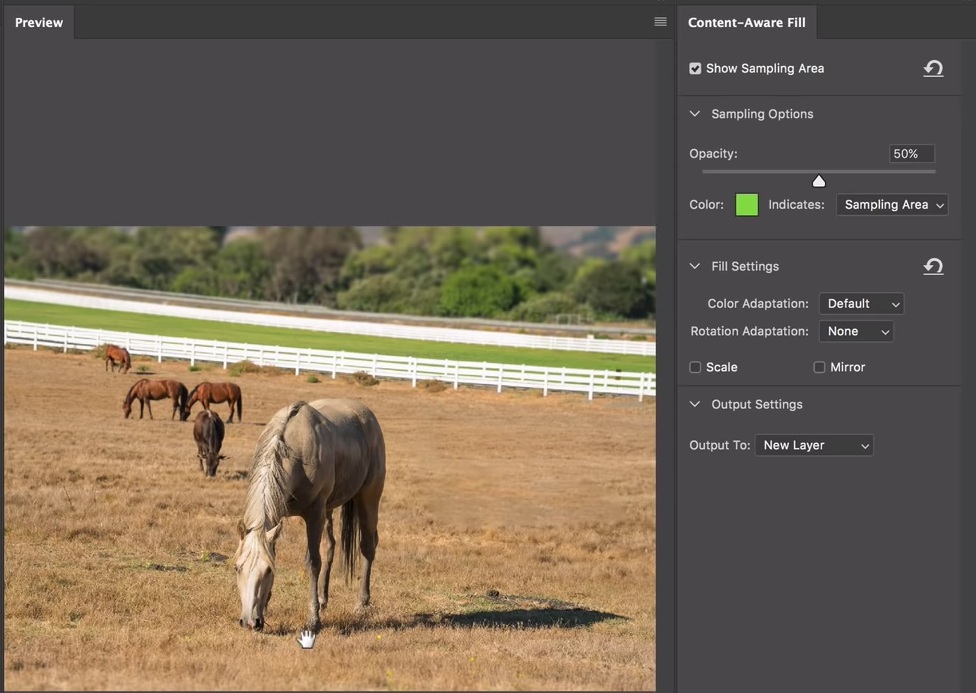

車両管理プラットフォームSaaSの最初の役割も(立ち上げ当初はダッシュボードと呼ばれていたが、2017年秋からプラットフォームと呼ばれるようになった)、業務の支援だった。彼らは、送り状や車両リースの書類を、車両管理者のために取り込んで処理をするシステムを構築した。それが今では、ほぼ完全に自動化されているとBrennerは言う。

「信じられないでしょうが、たとえば、大手のリース企業で、送り状やリースのデータの読み込みを行うAPIを持っているところは、ほとんどありません。そのため、そうした契約書や送り状を処理できるシステムを、根本から作らなければなりませんでした」と彼は言う。

「初期のころは、すべて手作業から始めました。しかし今では99パーセントの書類を完全に自動処理できています。これは、通常の構造化フォーム認識だけでは実現できません。本格的なAIシステムが貢献しています。魔法は、そのAIの中で起きているのです」

「私たちの仕事の特徴は、顧客の複数の言語による構造化されていないデータを、すべて読み込める点にあります。それには、車両管理には欠かせない非常に多くの情報が含まれていて、時間を大幅に節約できます」と彼は付け加えている。

彼が見据えている将来は、フランス語のPDF形式の送り状を自動的に処理するといった程度の技術ではない(それはそれで便利だが)。より豊富できめ細かい移動手段を取り混ぜて利用する方針に業界が移行するという、もっとエキサイティングなものだ。

もうひとつ、彼らは調査を行なった。顧客のデータから、走行距離と車両の種類をもとに、車両がどのように使われているかを調べ「車両の使用事例を推論」したとBrennerは話している。

「私たちは、動いていない車両や荷物を運んでいない車両は、経済的な視点からは、なんの意味もないという前提に立っています。そこが、他のオプションに入れ替えるべき第一候補でした。少なくとも電気自動車の場合、街中で1日に10キロから20キロしか走らなかったとしたら、内燃機関の車に比べて、経済的な意味がまったくありません」と彼は指摘する。

そこから彼らは、今後5年以内に、内燃機関の車の30パー円とがシフトすると予測した。

彼らは、顧客がすでに電気自動車を加えた車両の運用方針を実施していることを知った(「進歩的な企業は、2019年には特定の割合を電気自動車に切り替えるという方針を実行しています」と彼は話している)。

彼らはまた、社内カーシェアリングの「大きな需要」があることも発見した。そこで彼らのプラットフォームには、カーシェアリングを管理する予約モジュールも組み込まれた。

さらに面白いことに、一部の顧客は、従業員に電動バイクを提供するといった、非常に柔軟性の高い実験を行なっていることもわかった。

「ドラバーの働く意欲と定着率を高めるために、新しい可能性をどのように利用したらよいかを、みんなは真剣に考えています」とBrennerは言い、移動手段のマルチモーダルな選択肢を従業員に与えることが魅力的な企業としての利益につながると提言している。「しかも、こうした車両運用方針は、より多くのグループに広がります」

「見習い従業員が電動自転車に乗れるとしたら、それは大きな意欲につながります」と彼は続ける。「私たちのお客様も、このことはよく理解されています」

とは言うものの、この程度の柔軟性も、今のヨーロッパではまだ試験段階に過ぎない。

しかし、ヨーロッパの運送業界が、来年、車両運用方針に電気自動車を組み入れるのは「確かなこと」と彼は見ている。さらに、あらゆる種類の移動手段の変化が、あと7年以内に起きる可能性があるという。

「2019年には、もっとクリエイティブで、もっと進んだ選択肢の実験が行われるでしょう。そしてその結果によって、2020年にはさらに大変革が起こると、私たちは見ています」と彼は断言し、それにより生み出される車両管理業務の課題を具体化している。

「車両管理担当者の立場に立ってみましょう。これまでにやり方は、だいたい2社か3社の馴染みの大手リース会社を持ち、彼らと条件を話し合い、だいたい15車種ほどのモデルと、いくつかの装備のオプションから、従業員が車両を選べるようにします。それが従来の方法であり、これにメンテナンスのオプションや、資金繰りなどを加えれば、それだけでもう十分に難しい仕事です。私たちが第一に取り組むべき課題は、それです。彼らの車両運用方針を理解することです」

「しかし、より専門的で小規模な供給業者を加えると、途端に細かい交渉が始まります。諸経費はかさみます。さらに供給業者の数が増える、というのが今起きていることです。レンタカー会社は、もっと個人の利用事例に沿った提案をしてくれます。カーシェアの場合は、さらに絞り込んだ使用事例に適応した、特別な提案をしてくれます。車両管理担当者として、そこまで従業員の要求に応えようとすれば、管理すべき契約の数、車両運用方針に加える項目数、意思決定や従業員への引き渡し方法の複雑さが爆発的に増加してしまいます」

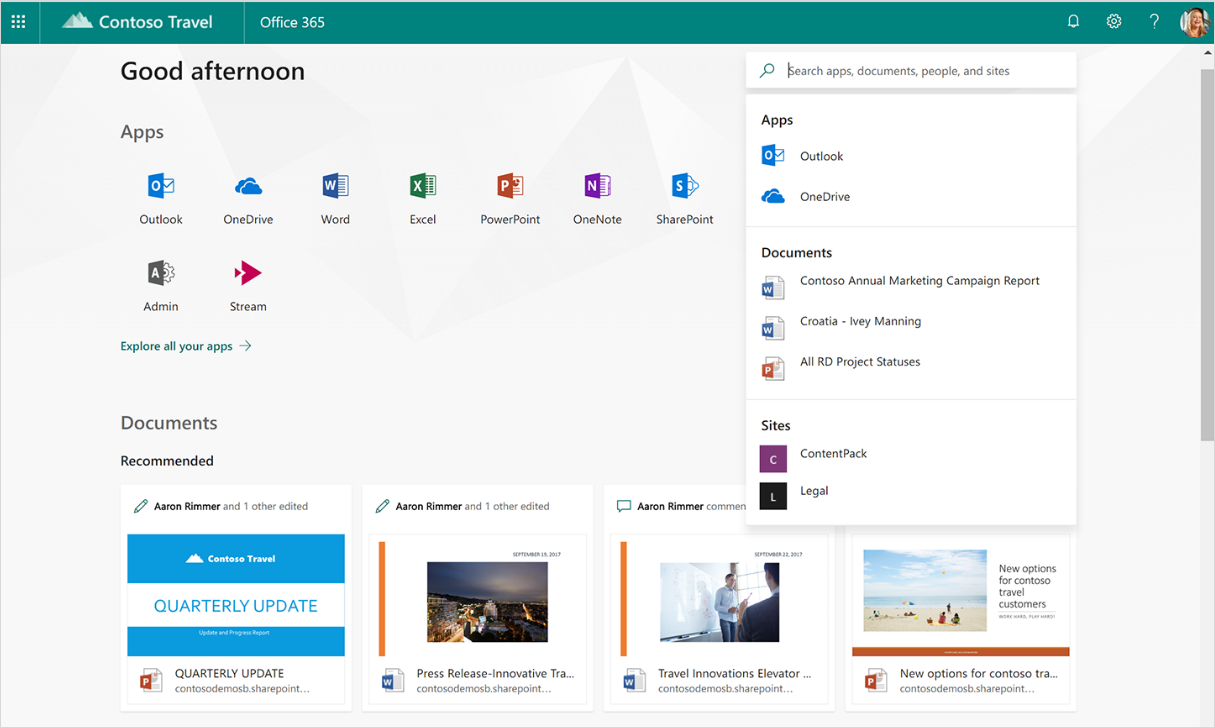

「車両管理担当者の仕事とは、そういうものです。そこを私たちが手助けしたいと思っているのです。コストの管理と、従業員が私たちのプラットフォームを使って、直接、車両の予約ができるようにすることです。私たちのプラットフォームを通じて、レンタカーやリース車両を、直接、注文できるのです。そうして、すべてが自動的に車両運用方針に整合するようになります」

同社は、そのプラットフォームを利用することで、現時点で、車両管理費用が最大30パーセント、車両コストが最大10パーセント削減できると主張している。さらに、データ機密性は向上し、環境や所有者の責任に関する法律にも準拠できる。

未来予測が示すとおり、移動手段の種類や数が大幅に増え、選択肢が、微妙な差異の特定分野に細分化されるようになると、コスト管理、コンプライアンス、複雑化する運用方針に対処するプラットフォームの重要性が際立ってくる。多くの従業員と車両を抱える企業においては、なおさらだ。

Avriosは、現在、おもにヨーロッパで事業を展開している。顧客には、保険会社、小売業者、ファッション系企業、機械製造業者、専門のサービスを提供する企業などがある。

Brennerによれば、数は少ないものの、アメリカ、中東、アフリカの顧客もあるという(その多くは世界的な輸送網を有しているとのこと)。

競争力としては、「本当の車両管理プラットフォーム」を提供していると彼は強調する。Avriosは、こうしたプラットフォームを提供する最初の企業であり、長年のライバルは、車両管理ソフトや車両運用サービスを提供しているに過ぎないと彼は話している(AFleetLogistics、Leaseplan、Arvalといった既存のインターネット・ポータルは、彼によれば「透明化を提案しているが、本当の意味での透明化はなされていない顧客囲い込みツール」だとのこと)。

「私たちは、プラットフォームという形でアプローチしています。そこには、ソフトウエア提供業者の要素(データの構造化や報告など)も含まれますが、FleetLogisticsのような車両管理サービス提供業者の要素(調達の自動化、他の車両と比較した標準コストの算出、新しい車両の調達やリースにおける入札プロセスの最適化)もあります」と彼は話す。「私たちは中立の立場で、どこで本当に損をしているかをお客様に理解してもらう手助けをしています」

TechCrunchに明かされた資金調達の情報によれば、2015年12月にシード投資、2017年7月にシリーズA投資、2018年7月には400万ドル(約4億4600万円)の拡大/加速ファンドを獲得している。これらはすべて、非公開だった。今日までの投資総額は1400万ドル(約15億6000万円)にのぼる。投資家には、Lakestar、Notion、Siraj Khaliq(Atomico)、Andrew Flett(Fleetmatics)などの名前があがっている。

Brennerによれば、シリーズAの拡大ファンドは製品開発に使われ、「車両管理ダッシュボードから、より多くの移動オプションを追加したものへの移行の加速」を目指すとのことだ。

また、最初に計画していたよりも早く事業規模を拡大するためにも使われる。「今は成長ステージに入ったと思っています。なので、成長ステージのスタートアップとして定石どおり、製品と売り込みとマーケティングです」と彼は語っている。

「今、私たちは、自分たちの筋道を理解できるようになりました。長期的にこの会社をどの方向に進めたいか、誰が顧客なのか、市場での我々の立ち位置はどうかなども理解できるようになりました。なので、市場に対して、もっと公的に話をするいい時期が来たと感じたのです」と、これまで投資について公にせず力を貯めてきた理由を、彼は説明している。

「とにかく、何よりも顧客と製品開発に集中したかったのです」

[原文へ]

(翻訳:金井哲夫)