今日(米国時間6/5)のWWDCでAppleがiOSの時期バージョンを発表することは以前から予測されていた。今回のデベロッパー・カンファレンスでiOS 11が紹介されたのは順当といえる。一般ユーザー向けの公開は9月を待たねばならないが、AppleによればiOS 11は以下のようなモバイルOSになるという。

AppleのCEO、ティム・クックはまず「iOS 10は86%のiOSデバイスにインストールずみだ」と述べた。続いてAppleのソフトウェア・エンジニアリング担当上級副社長、クレイグ・フェデリーギがiOS 11の新機能を紹介し、「iOS 11はテクノロジー面で大幅な進歩を遂げると同時に新機能も多数追加された」と述べた。

iOS 11ではスタンプ(sticker)とiMessageがショートカット・ドロワーから簡単にアクセスできるようになった。スタンプを送信するために何度もタップする必要はなくなる。すべての会話は自動的にiCloudに同期される。この同期は以降も維持されるため、ユーザーが一つのデバイスであるメッセージを削除するとすべてのAppleデバイスで削除される。 つまり今後は休暇旅行から戻ってMacを開くと膨大な未読メッセージの雪崩に襲われるということはなくなる。

-

apple-liveblog0565.jpg

-

apple-liveblog0470.jpg

-

apple-liveblog0491.jpg

-

apple-liveblog0500.jpg

-

apple-liveblog0516.jpg

Apple Payに関して、他のApple Payユーザーに現金を送ることができるようになった。VenmoあるいはSquare Cashに似た機能だ。この機能はiMessageにビルトインされている。現金を受け取った場合、Apple Pay Cash cardの残高に追加される。この資金はApple Payを通じて支払に充てることができる。自分の銀行口座に振り込むことも可能だ。

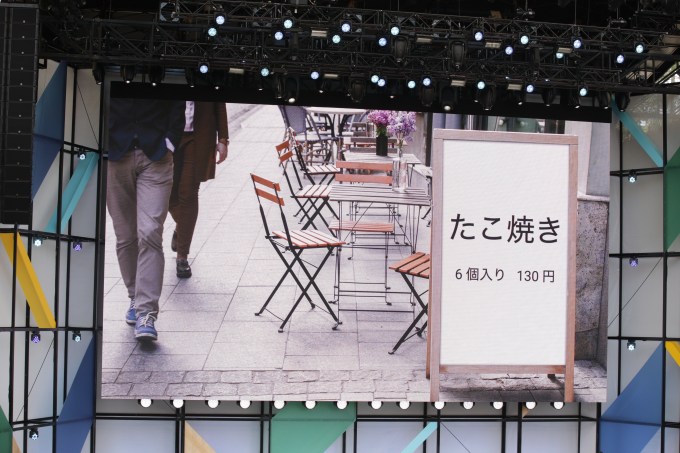

SiriもiOS 11で大幅に強化された。 Siriは毎月3億7500万のデバイスで利用されているという。iOS 11ではSiriの発音は改良され、抑揚もさらに自然になったという。またSiriを用いて翻訳も可能になる。中国語、フランス語、ドイツ語、イタリア語、英語が翻訳では最初にサポートされる。

Siriは文脈やユーザーの関心の把握でも改善された。Appleはこれを「Siri知能( intelligence)」と呼んでいるが、iOSのあらゆる場面で利用される。たとえば誰かiMessageで「どこまで行くの?」と尋ねたとすると、iOSはカレンダーを開いてどこに行く予定か調べ、回答の候補を表示する。ユーザーがアイスランド旅行について検索したとすると、iOSはスペルの自動訂正辞書にReykjavik〔アイスランドの首都〕などの単語を追加する。ニュース・アプリにもアイスランドのニュースが表示されるようになる、といった具合だ。

-

apple-liveblog0543.jpg

-

apple-liveblog0555.jpg

-

apple-liveblog0559.jpg

-

apple-liveblog0571.jpg

-

apple-liveblog0576.jpg

カメラ・アプリはHEVC(h.265)をサポートする。 このコーデックはビデオの画質を改善すると同時にファイル圧縮にも優れている。画像処理ソフトも改良を受け、既存のカメラで撮影した場合でも画質の向上が期待できるようだ。【略】

コントロール・センターも大幅にアップデートされた。デザインが一新され、多数のボタンが追加された。今後はユ次々にタブを切り替える手数が省かれる。たとえば、ミュージックビデオを再生している場合、輝度調整と一時停止を同一の画面で実行できる。さらに詳細な選択が必要な場合、3Dタッチで即座に機能を呼び出せる。

Apple Mapsのカーナビ機能もiOS 11で強化された。アメリカ内ではショッピング・モールや空港の詳細地図が利用できる。アメリカ人には非常に便利だろう。

iOSは運転中、Bluetoothで車載オーディオに接続していることを認識する。iPhoneのモーション・センサーは自動的に「電話に出られません」モードを起動する。このモードではすべての通知の表示が保留される。メッセージが着信した場合、予め用意した返信が自動送信されるよう設定できる。

AirPlayにもメジャー・アップデートが来た。AirPlay 2ではWiFi経由で複数のスピーカーを接続しiOSデバイスからコントロールできる。Libratone、Devialet、Bose、B&Oその他多数のオーディオ・メーカーがAirPlay 2をサポートする予定だ。それだけではない。AirPlay 2にはデベロッパー向けAPIが用意され、AirPlayを利用したアプリの開発が可能になった。

MusicKit APIの登場にによりデベロッパーはApple Musicの利用ができるようになった。たとえばShazamは(とうとう)Apple Musicのプレイリストに楽曲を自動で追加できるようになる。

-

apple-liveblog0640.jpg

-

apple-liveblog0662.jpg

-

apple-liveblog0687.jpg

-

apple-liveblog0682.jpg

Appleのフィル・シラーはApp Storeのアップデートについて簡単に触れた。もっとも重要な点はデザインが一新されることだろう。見た目はApple Newsにやや似ている。 ‘Today’タブには個人別にカスタマイズされたお勧めが表示される。ゲームは別に独自のタブが用意される。‘Apps’タブにはApp Storeチームによるお勧めアプリが掲載される。【略】

iOS 11のベータ版は今日から公開されるが、今後夏までに細かいバグ修正が行われるはずだ。一般ユーザー向け公開は9月。アップデートは無料。

アップデート: Appleはさらに多数の機能を発表した。キーノートの最後でフェデリーギがステージに戻り、iPad専用機能を発表した。 iPad画面の下部にはドックが用意され、これまでより簡単にアプリを切り替えられるようになった。Split Viewを用いれば同時に2つのアプリを並べて開くことができる。ドラッグアンドドロップで簡単に実行できる。

Split Viewについていえば、アプリ選択機能が一新された。コントロール・センターを開くショートカットと最近使ったアプリのプレビューが表示される。iOS 10の小さなアイコンのリストよりずっと使いやすい。

新しいFilesアプリはiPad上のファイルとクラウド・サービスを表示する。ユーザーはFilesアプリとメール・アプリ間でファイルをドラッグアンドドロップで移動できる。iPadのアプリは閉鎖的に単独で作動するだけではなくなった。これはAppleとしては画期的な方針転換だ。

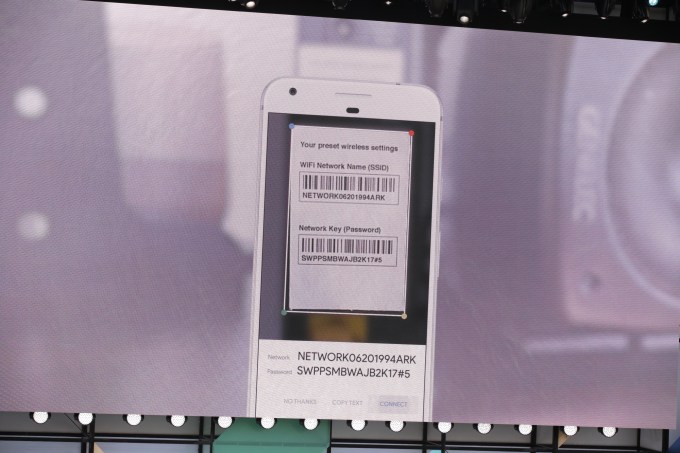

ユーザーはApple PencilでNotesアプリに書き込むことができる。Appleは書かれたテキストをOCRを使って処理し検索可能にする。カメラ・アプリにもネーティブで文書をスキャンする機能が追加された。スクリーンショットを撮ると、小さいポップアップが隅に表示される。タップするとスクリーンショットをトリミングし、説明を加えることができる。いちいち写真アプリを開く必要はない。

いろいろな面でiPadのiOSはデスクトップ・コンピュータのOSに近づいてきた。アプリは全画面でなく移動可能な窓で表示できるようになりドックも追加された。AppleはiPadをますます強力にしようと計画している。

iOS 11はiPad Air以降、iPad mini 2以降、第5世代iPad以降、iPhone 5s以降の各シリーズで作動する。

-

apple-liveblog0889.jpg

-

apple-liveblog0896.jpg

-

apple-liveblog0917.jpg

-

apple-liveblog0928.jpg

-

apple-liveblog0935.jpg

-

apple-liveblog0942.jpg

-

apple-liveblog0948.jpg

-

apple-liveblog0956.jpg

[原文へ]

(翻訳:滑川海彦@Facebook Google+)